Reconsiderando The Precipice

En los años transcurridos desde que escribí The Precipice, la pregunta que oigo con más frecuencia es si los riesgos han cambiado. Hace ya casi cuatro años que salió el libro, pero como el texto tiene que estar listo mucho antes, en realidad llevamos unos cinco años de cambios en el panorama de los riesgos.

Voy a examinar cuatro de los mayores riesgos —el cambio climático, la guerra nuclear, las pandemias y la inteligencia artificial (IA)— para mostrar cómo han cambiado. Ahora bien, han ocurrido muchas cosas en estos años, y no quiero limitarme a repasar las noticias en cámara rápida. Afortunadamente, creo que para cada uno de estos riesgos hay algunas ideas clave que se pueden extraer de todo lo que ha sucedido. De manera que me propongo abordarlos y desentrañar estas actualizaciones clave y los motivos de su importancia.

Voy a centrarme en los cambios que se han producido en el panorama del riesgo existencial, que incluye la extinción humana y otras formas en las que todo el potencial de la humanidad podría perderse definitivamente. Para la mayoría de estas áreas, hay muchos otros riesgos graves y daños actuales que también han cambiado, pero no podré ahondar en ellos. El objetivo de esta charla es centrarme solamente en los cambios del riesgo existencial.

Cambio climático

Empecemos con el cambio climático.

Podemos estimar los daños potenciales del cambio climático en tres pasos:

- ¿cuánto carbono emitiremos?

- ¿cuánto calentamiento produce ese carbono?

- ¿cuánto daño produce ese calentamiento?

Y hay actualizaciones clave sobre los dos primeros, que en su mayoría han pasado desapercibidos para el público en general.

Emisiones de carbono

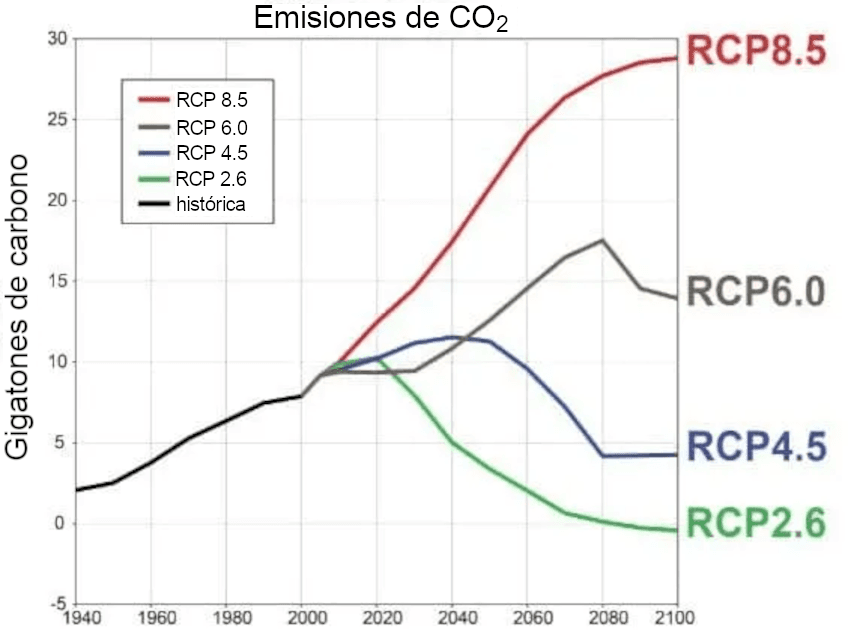

La pregunta de cuánto carbono emitiremos se plantea a menudo en términos de trayectorias de concentración representativas (RCP, por sus siglas en inglés).

Inicialmente había cuatro, donde los números más altos significan mayor efecto invernadero para el año 2100. Todas se eligieron de forma un tanto arbitraria, con la intención de representar posibilidades aproximadas del modo en que podrían desarrollarse nuestras emisiones a lo largo del siglo. Nuestra falta de conocimiento sobre qué camino tomaríamos era una enorme fuente de incertidumbre sobre la gravedad que podría revestir el cambio climático. Muchas de las predicciones climáticas más pesimistas se basan en la peor de estas trayectorias, la RCP 8.5. Ahora es claro que no estamos en absoluto en la RCP 8.5, y que nuestro rumbo se sitúa en algún punto entre las dos trayectorias inferiores.

Esto no es una gran noticia. Mucha gente esperaba que pudiéramos controlar nuestras emisiones aún más rápido. Pero a efectos del riesgo existencial derivado del cambio climático, gran parte del riesgo proviene de las peores posibilidades, por lo que incluso el mero hecho de movernos hacia la mitad del intervalo significa un menor riesgo existencial, y la parte inferior de la parte media es incluso mejor.

Sensibilidad climática

¿Qué pasa con la segunda pregunta sobre cuánto calentamiento producirá ese carbono? La medida fundamental aquí es algo llamado sensibilidad climática de equilibrio. Esto se define a grandes rasgos como la cantidad de grados de calentamiento que se producirían si las concentraciones de carbono en la atmósfera se duplicaran con respecto a los niveles preindustriales. Si no hubiera retroalimentaciones, sería fácil de calcular: duplicar el dióxido de carbono manteniendo todo lo demás fijo produce aproximadamente 1.2 °C de calentamiento. Pero la sensibilidad climática también tiene en cuenta muchas retroalimentaciones climáticas, como el vapor de agua y la formación de nubes. Estas la hacen más elevada y también mucho más difícil de calcular.

Cuando escribí The Precipice, el IPCC afirmaba que la sensibilidad climática se situaba probablemente entre 1.5 °C y 4.5 °C.

Cuando se trata de estimar los impactos del calentamiento, el rango es muy amplio: la parte superior da tres veces más calentamiento que la inferior. Además, la sensibilidad real bien podría ser todavía mayor, ya que lo único que decía el IPCC era que había una probabilidad de dos tercios de que se situara dentro de ese rango. Así que había una probabilidad aproximada de 1 en 6 de que la sensibilidad climática fuera incluso superior a 4.5 °C. Y de ahí provenía gran parte del riesgo existencial: escenarios en los que el clima es más sensible a las emisiones de lo que esperamos.

Para comprender el riesgo existencial derivado del cambio climático, deberíamos averiguar en qué punto de este vasto rango se encuentra realmente la sensibilidad climática. Pero se ha avanzado muy poco en este sentido. El rango de 1.5 °C a 4.5 °C se propuso por primera vez el año en que yo nací y no había cambiado de manera significativa en los siguientes 40 años de investigación.

Bien, ahora sí ha cambiado.

En el último informe de evaluación, el IPCC ha reducido el rango de probabilidad para que abarque de 2.5 °C a 4 °C, reflejando una mejor comprensión de las retroalimentaciones climáticas. Se trata de una bendición mixta, ya que está diciendo que tanto los resultados muy buenos como los muy malos tienen menos probabilidades de producirse. Pero, de nuevo, reducir la posibilidad de un calentamiento extremo disminuirá el riesgo existencial, que es lo que nos interesa aquí. Y también ha reducido su intervalo de confianza del 90 %, pues ahora dice que es un 95 % probable que la sensibilidad climática sea inferior a 5 °C.

En ambos casos, las actualizaciones consisten en acotar el rango de posibilidades plausibles, lo que tiene el efecto de disminuir la probabilidad de resultados extremos, lo que a su vez reduce el riesgo existencial. Pero hay una diferencia interesante entre ellos. Si consideramos nuestras emisiones, las acciones de la humanidad para responder a la amenaza del cambio climático las han reducido respecto a lo que habrían sido sin esas acciones. Nuestras acciones redujeron el riesgo. En cambio, en el caso de la sensibilidad climática, el cambio en el riesgo no es causal, sino epistémico: hemos descubierto evidencia de que la temperatura no será tan sensible a nuestras emisiones como temíamos. Lo mismo ocurrirá con otros riesgos. En ocasiones hemos hecho que los riesgos sean menores (o mayores), en otras hemos descubierto que siempre lo fueron.

Guerra nuclear

Mayor probabilidad de aparición

Cuando escribí The Precipice, la idea de una guerra nuclear me parecía una amenaza olvidada, algo que tenía que recordar a la gente que aún existía. Esto es lo que dije sobre la posibilidad de una guerra entre grandes potencias, cuando intentaba argumentar que aún podía ocurrir:

Consideremos la posibilidad de una guerra entre grandes potencias en este siglo. Es decir, una guerra entre cualquiera de los países o bloques más poderosos del mundo. Una guerra de esa magnitud definió la primera mitad del siglo XX, y su amenaza inminente definió también gran parte de la segunda mitad. A pesar de que la tensión internacional puede estar aumentando de nuevo, parece casi impensable que algunas de las grandes potencias se enfrenten en una guerra esta década, y poco probable en un futuro previsible. Pero un siglo es mucho tiempo, y sin duda existe el riesgo de que estalle de nuevo una guerra entre grandes potencias.

La invasión rusa de Ucrania ha hecho que las potencias nucleares estén sustancialmente más cerca de una guerra nuclear. Recordemos todos los llamados a favor de una zona de exclusión aérea, con la amenaza implícita de que si se violaba, EE. UU. y Rusia acabarían inmediatamente en una guerra armada en Ucrania. O la retórica exacerbada tanto de EE. UU. como de Rusia sobre represalias nucleares devastadoras y las acciones para aumentar sus niveles de preparación nuclear. No estamos en el nivel de la crisis de los misiles de Cuba, y la tensión ha disminuido desde su punto álgido, pero la situación sigue siendo notablemente peor de lo previsto mientras escribía The Precipice.

Probable nueva carrera armamentista

Cuando escribí The Precipice, el principal tratado nuclear entre EE. UU. y Rusia (Nuevo START) estaba a punto de expirar y el presidente Donald Trump pretendía dejar que eso sucediera. La administración entrante de Biden lo volvió a firmar en el último minuto. Pero no puede volver a renovarse. Expira exactamente dentro de dos años y habría que negociar un nuevo tratado que lo sustituyera en un momento en el que los dos países mantienen una pésima relación y participan activamente en una guerra subsidiaria.

En The Precipice, hablé de la historia de la disminución de los arsenales de cabezas nucleares desde 1986 y mostré este conocido gráfico.

Estábamos acostumbrados a que esa curva de cabezas nucleares fuera siempre descendente, y el reto consistía en cómo hacer que bajara más deprisa.

Pero ahora existe la inminente posibilidad de que los arsenales aumenten. De hecho, creo que esa es la posibilidad más probable. En cierto modo, este podría ser un momento aún más importante para la comunidad del riesgo nuclear, ya que sus acciones pueden inclinar la balanza entre un aumento drástico y un aumento leve, o entre un aumento leve y la estabilidad. Pero es un periodo triste.

En The Precipice, una de las razones por las que no calificaba más alto el riesgo existencial de una guerra nuclear era que con nuestros arsenales actuales no existe una vía científica conocida para que una guerra total conduzca a la extinción humana (ni un relato sólido sobre cómo podría acabar permanentemente con la civilización). Pero ahora los arsenales van a aumentar, y puede ser que mucho.

Colapso del financiamiento

Mientras tanto, se ha producido un colapso en el financiamiento del trabajo sobre la paz nuclear y la reducción de armas —trabajo que (entre otras cosas) ayudó a convencer al gobierno de EE. UU. a crear el tratado Nuevo START en primer lugar—. La MacArthur Foundation había sido uno de los principales donantes en este ámbito, contribuyendo con cerca del 45 % de todo el financiamiento. Pero dejó de financiar este trabajo, lo que provocó un colapso masivo en el financiamiento de este campo, y los expertos nucleares tuvieron que marcharse para dedicarse a otras carreras profesionales, aun cuando su ayuda era más necesaria que en cualquier otro momento de las últimas tres décadas.

Cada uno de estos cambios es un gran problema.

- La invasión rusa de un país europeo, que conduce a una guerra subsidiaria con EE. UU.

- El vencimiento del único tratado de control de armas en vigor, que daría lugar a una nueva carrera armamentista nuclear.

- Entretanto, los actores de la sociedad civil que trabajan para limitar estos riesgos ven cómo su financiamiento se reduce a la mitad.

El riesgo nuclear está en alza.

Pandemias

COVID

Después de haber escrito el libro, sufrimos la mayor pandemia de los últimos 100 años. Empezó a finales de 2019, cuando mi texto ya estaba listo, y golpeó de lleno al Reino Unido y EE. UU. justo cuando el libro salió a la venta en marzo.

La pandemia de COVID no era un riesgo existencial. Pero sí tuvo implicaciones para tales riesgos.

En primer lugar, puso de manifiesto graves deficiencias en nuestra capacidad para defendernos de tales riesgos. Uno de los grandes retos del riesgo existencial es que es especulativo. En The Precipice escribí que si hubiera un peligro claro y aparente (como un asteroide que siguiera una trayectoria visible de colisión con la Tierra) las cosas se agilizarían. La humanidad sería capaz de unirse ante un enemigo común, relegando a un segundo plano nuestras disputas nacionales o entre facciones. Bueno, hubo algo de eso al principio. Pero a medida que la crisis se prolongaba, vimos cómo se polarizaba cada vez más a lo largo de las líneas nacionales y políticas existentes. Así que una de las lecciones aquí es que la unión en torno a una amenaza común es una fase bastante temporal: se obtienen unos meses de gracia y hay que aprovecharlos bien antes de que la polarización haga acto de presencia.

Otro tipo de debilidad que sacó a la luz fue la de nuestras instituciones para gestionar estos riesgos. Cuando empezó la pandemia, yo tenía en muy buen concepto a la OMS y a los CDC, pero creo que no estuvieron a la altura. Una hipótesis que he oído al respecto es que hace una generación sí tenían las aptitudes necesarias para gestionar este tipo de crisis, pero que las décadas transcurridas sin necesidad de demostrarlas hicieron que se atrofiaran.

Una segunda implicación es que la pandemia de COVID fue un disparo de advertencia. La idea de que la humanidad pueda experimentar grandes catástrofes que cambien nuestro modo de vida era casi impensable en 2019, pero ahora es mucho más creíble. Esto es cierto tanto a nivel personal como a nivel de la civilización. Ahora nuestra imaginación acepta la posibilidad de nuevos acontecimientos capaces de trastocar completamente nuestra vida cotidiana durante años. Y podemos imaginar acontecimientos que arrasen el planeta y amenacen a la civilización misma. Nuestro aire de invulnerabilidad se ha disipado.

Dicho esto, la respuesta inmunitaria ha sido menor de lo que se esperaba. La opinión convencional es que una crisis como esta conduce a un ciclo de pánico-descuido, en el que extremamos las precauciones durante un tiempo, pero no podemos mantenerlas. Esta era la expectativa de muchas personas en el ámbito de la bioseguridad, y la estrategia principal consistía en asegurarse de que la respuesta no se centrara demasiado en una reaparición de la pandemia de COVID, sino que cubriera un amplio abanico de posibles pandemias y que el financiamiento estuviera blindado para que no pudiera desviarse a otros fines cuando el recuerdo de esta tragedia comenzara a desvanecerse.

Pero ni siquiera vimos una fase de pánico: el gasto en biodefensa para futuras pandemias fue decepcionante en el Reino Unido y aún peor en los Estados Unidos.

Una tercera implicación fue la asombrosa mejora en los tiempos de desarrollo de vacunas, incluido el éxito del primer despliegue de las vacunas de ARNm.

Cuando escribí The Precipice, el tiempo típico para el desarrollo de una vacuna era de décadas, y el más rápido de todos los tiempos fue de diez años. El consenso de los expertos era que la vacuna contra el COVID tardaría al menos un par de años, pero en lugar de eso tuvimos listas varias vacunas completamente diferentes en tan solo un año. Realmente no estaba claro que esto fuera posible. Las vacunas siguen siendo extremadamente importantes para la biodefensa mundial, ya que proporcionan la salida definitiva para pandemias como la de COVID, cuyo elevado R0 significa que no pueden suprimirse únicamente con cambios de comportamiento. Otras intervenciones nos otorgan el tiempo necesario para llegar a las vacunas, y si podemos adelantar ese tiempo, se facilita además la tarea de sobrevivir durante ese tiempo.

Una cuarta y última implicación se refiere a la investigación en ganancia de función. Este tipo de investigación biológica en la que los científicos fabrican una versión más mortífera o más transmisible de un patógeno existente era una de las fuentes de pandemias extremas que más me preocupaban en The Precipice. Aunque los científicos que están detrás de la investigación en ganancia de función tienen buenas intenciones, el historial de patógenos que escapan de sus laboratorios es mucho peor de lo que la gente cree.

Respecto a la pandemia de COVID, se dio la extraña situación de que la mayor catástrofe mundial desde la Segunda Guerra Mundial fue muy probablemente causada por la fuga de un patógeno de un laboratorio con una línea de investigación bienintencionada, aunque arriesgada, sobre los coronavirus de los murciélagos. Las investigaciones fidedignas sobre los orígenes de esta enfermedad están más o menos divididas al respecto. Es totalmente posible que las acciones de las personas de un laboratorio concreto hayan matado a más de 25 millones de personas en todo el mundo. Sin embargo, la reacción suele ser indiferente: que en realidad no importa, ya que pertenece al pasado y no podemos cambiarlo. Esto de verdad me sigue sorprendiendo. Quiero creer que si hubiera la sospecha de que el responsable de la muerte de millones de personas fuera alguien de un laboratorio estadounidense, sería el juicio del siglo. Está claro que la trama quedó atrapada en una guerra cultural política, así como en la desconfianza entre dos grandes potencias, aunque en realidad yo habría pensado que esto daría al asunto aún más visibilidad y dramatismo. Pero a la gente no parece importarle y la investigación en ganancia de función continúa más o menos como antes.

Tecnologías de protección

Dejando a un lado el COVID, ha habido avances recientes en dos tecnologías de protección que me entusiasman mucho.

La primera es la secuenciación metagenómica. Se trata de una tecnología que puede tomar una muestra de un paciente o del medio ambiente y secuenciar todo el ADN y el ARN que contiene, cotejándolos con bases de datos de organismos conocidos. Un ejemplo de aplicación práctica sería utilizarla para enigmas de diagnosis: si un médico no puede determinar por qué un paciente está tan enfermo, puede tomar una muestra y enviarla a un laboratorio central para su secuenciación metagenómica. Si China hubiera contado con esta tecnología, habría sabido en 2019 que existía un nuevo patógeno cuya coincidencia más cercana era el SARS, pero que presentaba cambios sustanciales. Dada la historia de China con el SARS, probablemente habrían actuado rápidamente para detenerlo. También existen casos de uso potencial en los que se toma una muestra del medio ambiente, como las aguas residuales o el aire acondicionado de un aeropuerto. Una nueva secuencia caracterizada por el crecimiento exponencial en el tiempo podría servir para detectar nuevas pandemias incluso antes de que se manifiesten los síntomas.

La segunda es mejorar la calidad del aire. Una gran lección de la pandemia es que la epidemiología estaba subestimando el potencial de transmisión aérea. Esto abre la posibilidad de una revolución en la salud pública. Del mismo modo que se produjeron enormes avances en el siglo XIX cuando se comprendió la transmisión por el agua y se descubrió la importancia del agua limpia, también podrían producirse enormes avances con el aire limpio.

Una gran sorpresa de la pandemia fue la escasa transmisión que se produjo en los aviones, aunque hubiera una persona infectada cerca. Gran parte de ello se debió a los impresionantes sistemas de filtración y acondicionamiento de aire con los que cuentan los aviones modernos. Podríamos mejorar nuestros edificios para incluir sistemas de este tipo. Y ha habido avances sustanciales en la luz UV con efecto germicida, incluyendo la nueva banda de luz UVC que puede tener un gran beneficio en su capacidad para matar gérmenes sin dañar la piel o los ojos humanos.

Disponemos de un par de vías diferentes para protegernos utilizando estas tecnologías. Podríamos mejorar nuestros edificios compartidos, como oficinas y escuelas, para utilizarlas todo el tiempo. Esto limitaría la transmisión de virus incluso en los primeros días, antes de que nos hayamos dado cuenta del brote, y tendría importantes beneficios inmediatos en la prevención de la propagación de resfriados y gripes. Y durante una pandemia, podríamos ampliar la escala de su uso a muchos más lugares.

Estas son algunas características clave de estas tecnologías:

- Pueden combatir una amplia gama de patógenos, incluidos los nuevos (ya sean naturales o artificiales). Incluso ayudan con patógenos sigilosos antes de que produzcan síntomas.

- Requieren pocos cambios en el comportamiento prosocial por parte del público.

- Tienen grandes beneficios secundarios para ayudar a combatir enfermedades infecciosas cotidianas como la gripe.

- Y su investigación no es de doble uso (ayudan sistemáticamente a la defensa pero no al ataque).

La IA en la biotecnología

Por último, está el papel de la IA en el riesgo de pandemias. La biología es probablemente la ciencia que más se ha beneficiado de la IA hasta ahora. Por ejemplo, cuando escribí The Precipice, los biólogos habían determinado la estructura de unas 50 mil proteínas diferentes. Después, AlphaFold de DeepMind aplicó la IA para resolver el problema del plegamiento de proteínas y la ha utilizado para encontrar y publicar las estructuras de 200 millones de proteínas. Este ejemplo no tiene ningún efecto directo sobre el riesgo existencial, pero gran parte de la biología sí conlleva riesgos, y la rápida aceleración de las capacidades biológicas puede abrir nuevos riesgos a un mayor ritmo, dándonos menos tiempo para anticiparnos y responder a ellos.

Una vía muy reciente mediante la cual la IA podría contribuir al riesgo de pandemias es a través de modelos de lenguaje (como ChatGPT) que facilitan a los actores malintencionados aprender a diseñar y desplegar nuevos patógenos para crear pandemias catastróficas. No se trata de un cambio cualitativo en el riesgo de pandemias artificiales, puesto que ya existe un fuerte proceso de democratización de la biotecnología, en virtud del cual personas con menos conocimientos y laboratorios más básicos son capaces de replicar rápidamente los últimos avances y técnicas. En última instancia, muy pocas personas desean desplegar armas biológicas catastróficas, pero a medida que se amplía el grupo de personas que podrían hacerlo, crece la posibilidad de que dicho grupo albergue a alguien con esas intenciones. Los modelos de lenguaje de la IA están acelerando aún más esta democratización y, a menos que estas capacidades se eliminen de los futuros sistemas de IA, lo cierto es que aumentarán el riesgo derivado del bioterrorismo.

IA

Esto nos lleva, por último, al riesgo asociado a la IA.

Han ocurrido tantas cosas durante los últimos cinco años en el ámbito de la IA que es difícil intentar resumirlas. Pero quiero centrarme en tres cosas que me parecen especialmente importantes.

Agentes de aprendizaje por refuerzo ⇒ modelos de lenguaje

En primer lugar, está el cambio de los agentes de aprendizaje por refuerzo a los modelos de lenguaje.

Hace cinco años, el trabajo principal en inteligencia artificial general (IAG) eran los agentes de juego entrenados con aprendizaje por refuerzo profundo. Sistemas como AlphaGo, AlphaZero, AlphaStar y OpenAI 5. Se trata de sistemas entrenados para realizar acciones en un mundo virtual que superan a un adversario y que avanzan inexorablemente hacia la victoria por mucho que este intente detenerlos. Y se crearon agentes de IA que superaron a los mejores humanos en una amplia variedad de juegos.

Ahora, la vanguardia es la IA generativa: sistemas que generan imágenes, vídeos y (especialmente) texto.

Estos nuevos sistemas no son (inherentemente) agentes. Así que el escenario clásico de amenaza de Yudkowsky y Bostrom (en el que me centré en The Precipice) no se aplica directamente. Eso es un gran problema.

Parece que las personas podrán hacer poderosos agentes a partir de modelos de lenguaje. Pero no es necesario que tengan forma de agente, por lo que quizá sea posible que los primeros laboratorios creen IAG alineadas que no sean agentes para ayudar con las medidas de seguridad de los agentes de IA o que la gobernanza nacional o internacional prohíba los agentes de IA avanzados, sin dejar de beneficiarse de los sistemas avanzados no agentes.

Y como predijo Stuart Russell, estos nuevos sistemas de IA han leído enormes cantidades de escritura humana. Algo así como un billón de palabras de texto. Toda la Wikipedia; novelas y libros de texto; vastas partes de internet. Probablemente han leído más ética académica que yo, y casi toda la ficción no es más que humanos haciéndoles cosas a otros humanos en combinación con juicios sobre esas acciones.

Estos sistemas disponen así de una gran cantidad de señales de entrenamiento sobre los valores humanos y contrastan enormemente con los sistemas de juego, que no sabían nada de dichos valores y a los que no era claro cómo enseñárselos. Así que el reto ya no consiste en darles suficiente información sobre la ética, sino en hacer que les importe.

Como se trataba de un aprendizaje supervisado con una gran cantidad de datos de entrenamiento (no muy lejos de todo el texto jamás escrito), hubo una mejora muy rápida de las capacidades. Pero esto no es exactamente la aceleración de propósito general que personas como Yudkowsky habían estado prediciendo.

Yudkowsky predijo que la aceleración de las capacidades de la IA arrasaría con el rango relativamente estrecho de las capacidades humanas porque no hay nada de especial en esos niveles. Y como estaba aumentando tan rápidamente, la superaría en un periodo muy corto:

Los modelos de lenguaje han aumentado su capacidad todavía más rápido. Pero con ellos hay algo muy especial respecto al rango de capacidades humanas, porque ese es el nivel de todos los textos con los que se entrenan. Sus capacidades se están elevando rápidamente hacia el nivel humano a medida que se entrenan con todos nuestros escritos, pero también pueden estancarse en ese punto:

En cierto sentido, aún podrían superar las capacidades humanas (por ejemplo, podrían conocer más temas simultáneamente que cualquier humano y ser más rápidos escribiendo), pero sin un nuevo enfoque, es posible que no superen a los mejores humanos en cada área.

Incluso si la gente pasa entonces a nuevos tipos de entrenamiento para seguir avanzando más allá del nivel humano, las mejoras podrían volver a adoptar velocidades más lentas, lo que supondría un bache en las curvas de aprendizaje:

Y por último, dado que los modelos de lenguaje dependen de cantidades realmente enormes de poder de cómputo para poder ampliar su escala, ya no es posible dirigir un laboratorio de IAG como una organización sin ánimo de lucro, o como un proyecto paralelo de una empresa rica. Los laboratorios de IAG, en otro tiempo bastante académicos y cautos, han pasado a depender de enormes cantidades de poder de cómputo de sus socios corporativos, y estos quieren a cambio una rápida comercialización y un mayor control sobre la agenda.

Carreras

Otro gran cambio en el riesgo asociado a la IA proviene del aumento de las carreras hacia la IA.

Hace tiempo que éramos conscientes de las posibilidades y los peligros de estas carreras: que llevarían a recortar gastos en seguridad en un intento de llegar a la IAG avanzada antes que nadie.

En los primeros años que siguieron a la escritura de The Precipice, vimos carreras notables entre OpenAI y DeepMind, con Anthropic uniéndose también a la refriega. Luego, en 2023, ocurrió algo nuevo. Se convirtió no solo en una carrera entre estos laboratorios, sino en una carrera entre las empresas más grandes de la Tierra. Microsoft intentó capitalizar sus inversiones premonitorias en OpenAI, aprovechando lo que quizá fue el momento de su mayor ventaja en IA para intentar hacerse con Search, la joya de la corona de Google. Pusieron en marcha un sistema potente, pero muy desalineado, que dio al mundo su primer ejemplo de un sistema de IA que se volvía contra sus propios usuarios.

Algunos de los ejemplos más extremos fueron amenazar con vengarse de un periodista por escribir una historia negativa sobre él, e incluso amenazar con matar a un investigador de la ética de la IA. Fue un auténtico momento 2001: Odisea del Espacio, con una IA capaz de averiguar por sí misma si habías dicho cosas negativas sobre ella en otras conversaciones y de amenazarte con castigarte por ello.

En realidad, el sistema seguía sin ser un agente y no estaba tratando de vengarse. Estaba más bien simulando a un personaje que actúa así. Pero seguía teniendo sistemáticamente comportamientos que de ser tenidos por humanos se considerarían amenazas de venganza.

Microsoft consiguió mitigar estos comportamientos y acabó con un sistema que sí supuso un verdadero reto para Google Search. Google respondió fusionando sus laboratorios Brain y DeepMind en un único gran laboratorio mucho más centrado en construir modelos de lenguaje cada vez más grandes para desplegarlos de inmediato en sus productos.

Me preocupa mucho que esta nueva carrera entre las grandes empresas tecnológicas (que no comprenden los riesgos asociados a la IA avanzada del mismo modo que los propios laboratorios) empuje a los laboratorios hacia despliegues más arriesgados, se oponga a una regulación útil y haga mucho más difícil para los laboratorios tirar del freno de emergencia si creen que sus sistemas se están volviendo demasiado peligrosos.

Gobernanza

Por último, en los últimos 16 meses se han producido cambios drásticos en el interés público y gubernamental.

Cuando escribí The Precipice, ya existía un interés público por el auge de la IA, especialmente por la victoria de AlphaGo sobre Lee Sedol. Y el gobierno de EE. UU. estaba empezando a hablar de una posible carrera con China en el campo de la IA, pero sin hacer gran cosa al respecto.

Esto empezó a cambiar de verdad en octubre de 2022, cuando el gobierno estadounidense introdujo una serie de controles a la exportación para las tecnologías de chips informáticos con el fin de mantener los chips de IA más avanzados fuera de China y retrasar así el desarrollo de una industria china de chips para IA. Esta fue una señal importante de la seria intención de controlar el acceso internacional al poder de cómputo necesario para el desarrollo de la IA avanzada.

Un mes después se produjo el lanzamiento de ChatGPT, seguido de Bing y GPT-4 a principios de 2023. El acceso público a sistemas tan avanzados provocó un rápido aumento de la conciencia pública sobre lo mucho que había progresado la IA y de la preocupación pública por sus riesgos.

En mayo, Geoffrey Hinton y Yoshua Bengio —dos de los fundadores del aprendizaje profundo— manifestaron una gran preocupación por lo que habían creado y abogaron por una respuesta de los gobiernos a los riesgos existenciales derivados de la IA. Más tarde, ese mismo mes, se unieron a otras eminencias de la IA para firmar una sucinta declaración pública en la que afirmaban que ocuparse del riesgo de extinción humana derivado de la IA debería ser una prioridad global.

A esta le siguió rápidamente una declaración similar de The Elders, un grupo de antiguos líderes mundiales entre los que se encuentran un ex secretario general de la ONU, un ex director general de la OMS y expresidentes y ex primeros ministros de Irlanda, Noruega, Mongolia, México, Chile y otros países, además de varios ganadores del Premio Nobel de la Paz. Estuvieron de acuerdo en que:

sin una regulación global adecuada, el extraordinario ritmo del progreso tecnológico de la IA supone una amenaza existencial para la humanidad.

El riesgo existencial derivado de la IA había pasado por fin de ser una preocupación académica especulativa a un nuevo tema fundamental de la gobernanza global.

Posteriormente, en octubre y noviembre, se produjo una oleada de actividad por parte de los gobiernos de EE. UU. y del Reino Unido. Biden firmó una orden ejecutiva dirigida a la seguridad de los sistemas de IA de vanguardia. El Reino Unido convocó la primera de una serie de reuniones internacionales sobre la gobernanza internacional de la IA, con un enfoque explícito en el riesgo existencial derivado de la IA. Veintiocho países y la UE firmaron la Declaración de Bletchley. Poco después, EE. UU. y el Reino Unido lanzaron cada uno sus propios institutos nacionales de seguridad de la IA.

En conjunto, esto supuso un cambio asombroso en la ventana de Overton en tan solo 16 meses. Si bien no existe un consenso universal, la idea de que el riesgo existencial derivado de la IA es una prioridad global de primer orden es ahora una posición estándar respetada por muchos líderes de la IA y de la política mundial, al igual que la necesidad de una regulación nacional e internacional de la IA de vanguardia.

Los efectos de todo esto sobre el riesgo existencial son complejos:

- El cambio a los modelos de lenguaje ha tenido efectos bastante dispares

- Las carreras son malas

- La mejora de la gobernanza es buena

El panorama general es mixto.

Conclusiones

En The Precipice, expuse mi mejor estimación de probabilidades para el riesgo existencial en los próximos 100 años en cada una de estas áreas. Eran de 1 en 1 000 para el riesgo climático y para el nuclear, de 1 en 30 para las pandemias y de 1 en 10 para la IA no alineada. Probablemente se estén preguntando de qué manera afecta todo esto a esos números y cuáles son mis nuevos números. Pero como se habrán dado cuenta, todos están redondeados (normalmente al factor de 10 más próximo) y ninguno se ha movido tanto.

Pero puedo decir que, en mi opinión, el riesgo climático ha disminuido, el nuclear ha aumentado y que el panorama de las pandemias y la IA es mixto: con muchos cambios pero sin una dirección clara para el riesgo global.

Quiero terminar con unas palabras sobre cómo ha venido reaccionando el mundo ante el riesgo existencial en su conjunto.

En The Precipice, presenté la idea de la seguridad existencial. Se trata de un hipotético estado futuro del mundo en el que el riesgo existencial es bajo y se mantiene bajo; en el que hemos apagado los fuegos actuales y puesto en marcha los mecanismos para garantizar que el fuego ya no suponga una amenaza sustantiva.

En estos momentos nos encontramos esencialmente en la fase de apagar fuegos —afrontando los desafíos que se nos han venido encima— y este es el reto más urgente en la actualidad. Pero la seguridad existencial también incluye el trabajo para establecer las normas e instituciones que garanticen que las cosas nunca se descontrolen tanto como en este siglo: establecer la gravedad moral del riesgo existencial; establecer las normas internacionales, luego los tratados internacionales y la gobernanza para hacer frente al riesgo existencial.

Esto no va a ser rápido, pero en un plazo de décadas podría haber un progreso sustancial. Y asegurarse de que este proceso tenga éxito en las próximas décadas es crucial si queremos que perduren los beneficios que obtengamos de la lucha contra los incendios actuales.

Creo que las cosas van por buen camino. La ONU ha empezado a ocuparse explícitamente de los riesgos existenciales como una de sus grandes prioridades globales. The Elders han estructurado su agenda en torno a la lucha contra los riesgos existenciales. Un primer ministro británico citó The Precipice en un discurso ante la ONU y otro celebró toda una cumbre en torno al riesgo existencial de la IA. El mundo está empezando a tomarse en serio la seguridad frente a los riesgos existenciales, y eso es un avance muy positivo.