¿Debemos aspirar a prosperar en lugar de limitarnos a sobrevivir? Serie Better Futures.

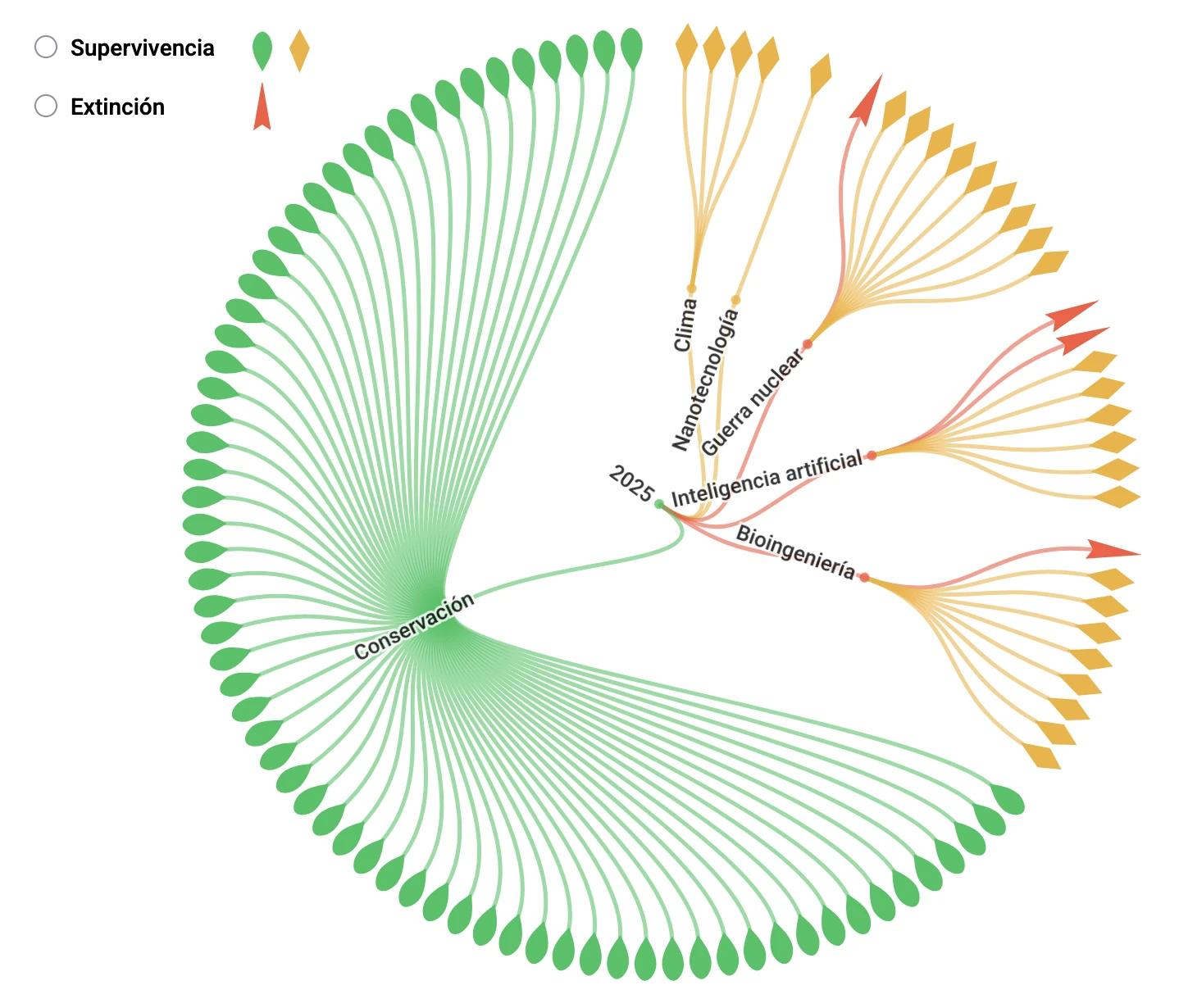

Forethought y yo lanzamos hoy una serie de ensayos titulada Better Futures, aquí.a Llevamos unos ocho años trabajando en ella, ¡así que estoy muy contento de que por fin haya salido a la luz! La serie plantea esta pregunta: cuando miramos hacia el futuro, ¿debemos centrarnos en sobrevivir o en prosperar?

En la práctica, al menos, los altruistas orientados al futuro tienden a centrarse en garantizar nuestra supervivencia (o en que no nos veamos permanentemente despojados del poder por unas IA sin valores). Pero tal vez deberíamos centrarnos más bien en la prosperidad futura.

¿Por qué?

Bueno, incluso si sobrevivimos, probablemente solo tendremos un futuro que será una pequeña fracción de lo bueno que podría haber sido. En lugar de eso, podríamos intentar guiar a la sociedad para encaminarla hacia un futuro verdaderamente maravilloso.

Es decir, creo que hay más en juego cuando se trata de prosperar que cuando se trata de sobrevivir. Así que tal vez ese debería ser nuestro principal objetivo.

La serie completa de ensayos está disponible desde hoy. Pero publicaré resúmenes de cada ensayo durante las próximas dos semanas. Además, el primer episodio del videopódcast de Forethought trata sobre este tema y ya está disponible también.

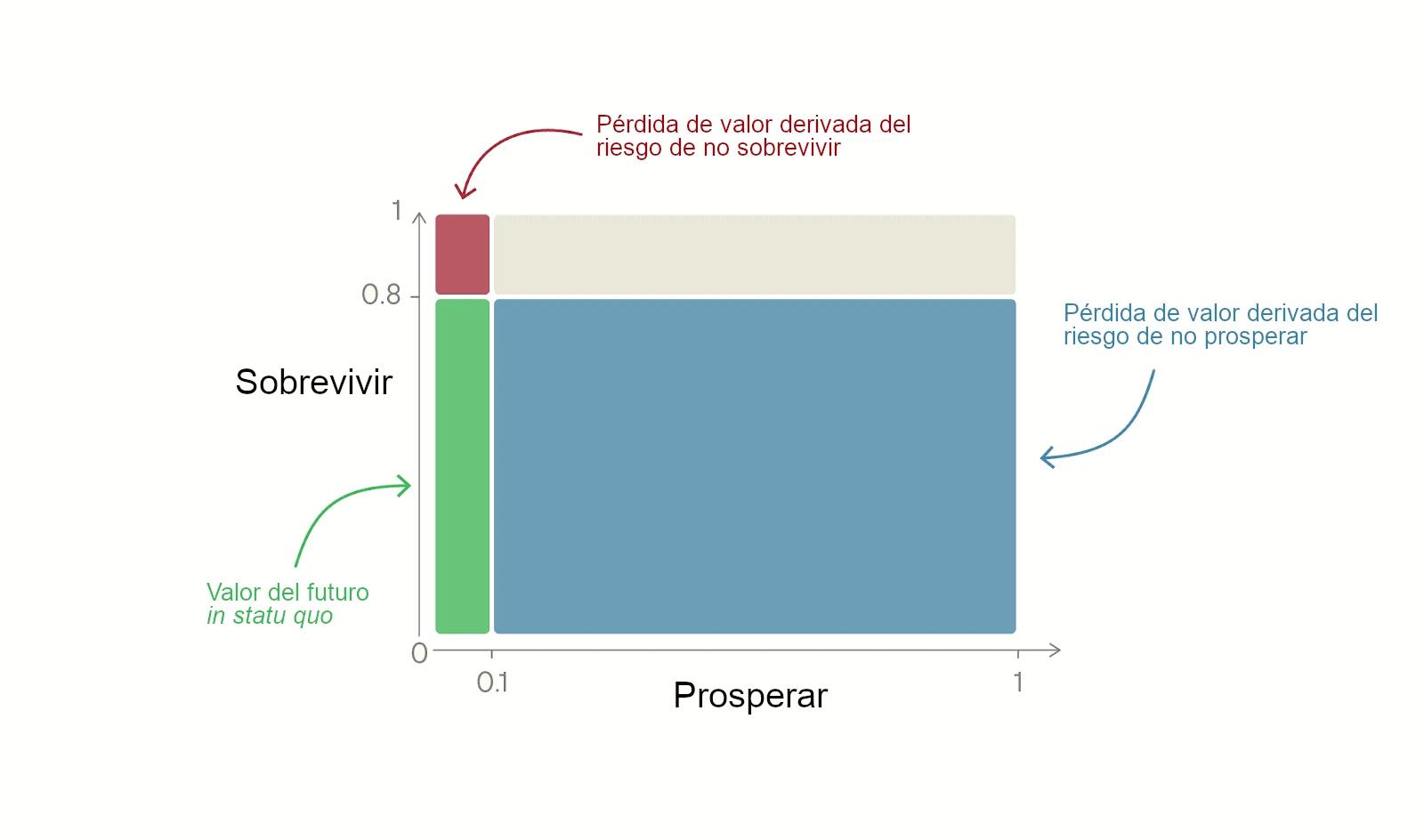

El primer ensayo es Introducing Better Futures: junto con el suplemento, ofrece los argumentos básicos para centrarse en intentar que el futuro sea maravilloso, en lugar de limitarnos a garantizar que tengamos un futuro aceptable. Se basa en un modelo simple de dos factores: el valor del futuro es el producto de nuestra probabilidad de “Sobrevivir” y del valor del futuro si Sobrevivimos, es decir, nuestra “Prosperidad”.

(“No Sobrevivir”, en este caso, significa cualquier cosa que nos condene a un futuro con un valor cercano a 0 a corto plazo: la extinción por una catástrofe biológica cuenta, pero también cuenta la posibilidad de que una superinteligencia sin valores nos arrebate el poder sin causar la extinción humana. Creo que así es como se utiliza a menudo el término “catástrofe existencial” en la práctica).

La idea clave es: tal vez estemos más cerca del “techo” de la Supervivencia que del “techo” de la Prosperidad.

La mayoría de la gente (aunque no todos) cree que es mucho más probable que Sobrevivamos este siglo a que no lo hagamos. Metaculus sitúa el riesgo de extinción en torno al 4 %; una encuesta a superpronosticadores lo sitúa en el 1 %. Toby Ord sitúa el riesgo existencial total de este siglo en un 16 %.

Por el contrario, ¿cuál es el valor de Prosperar? Es decir, si la extinción a corto plazo es 0, ¿qué porcentaje del valor del mejor futuro posible deberíamos esperar alcanzar? En los dos primeros ensayos, Fin Moorhouse y yo argumentamos que es bajo.

Y si estamos más lejos del techo de la Prosperidad, entonces la magnitud del problema de No Prosperar es mucho mayor que la del riesgo de No Sobrevivir.

Para ilustrarlo: supongamos que nuestra probabilidad de Supervivencia en este siglo es del 80 %, pero el valor del futuro, en caso de sobrevivir, es de solo el 10 %.

Si es así, entonces el problema de No Prosperar es 36 veces mayor en magnitud que el problema de No Sobrevivir.

(Si tu “p(doom)” es muy alta, entonces este argumento no es válido y la serie de ensayos te resultará menos interesante).

Puede ser difícil pensar con claridad sobre la importancia de Prosperar, porque el valor absoluto del futuro podría ser muy alto, mientras que solo logramos una pequeña fracción de lo que es posible. Pero lo que importa es la fracción de valor alcanzada. Dada mi definición de las cantidades de valor, es tan importante pasar de un futuro con un valor del 50 % al 60 % como pasar de un futuro con un valor del 0 % al 10 %.

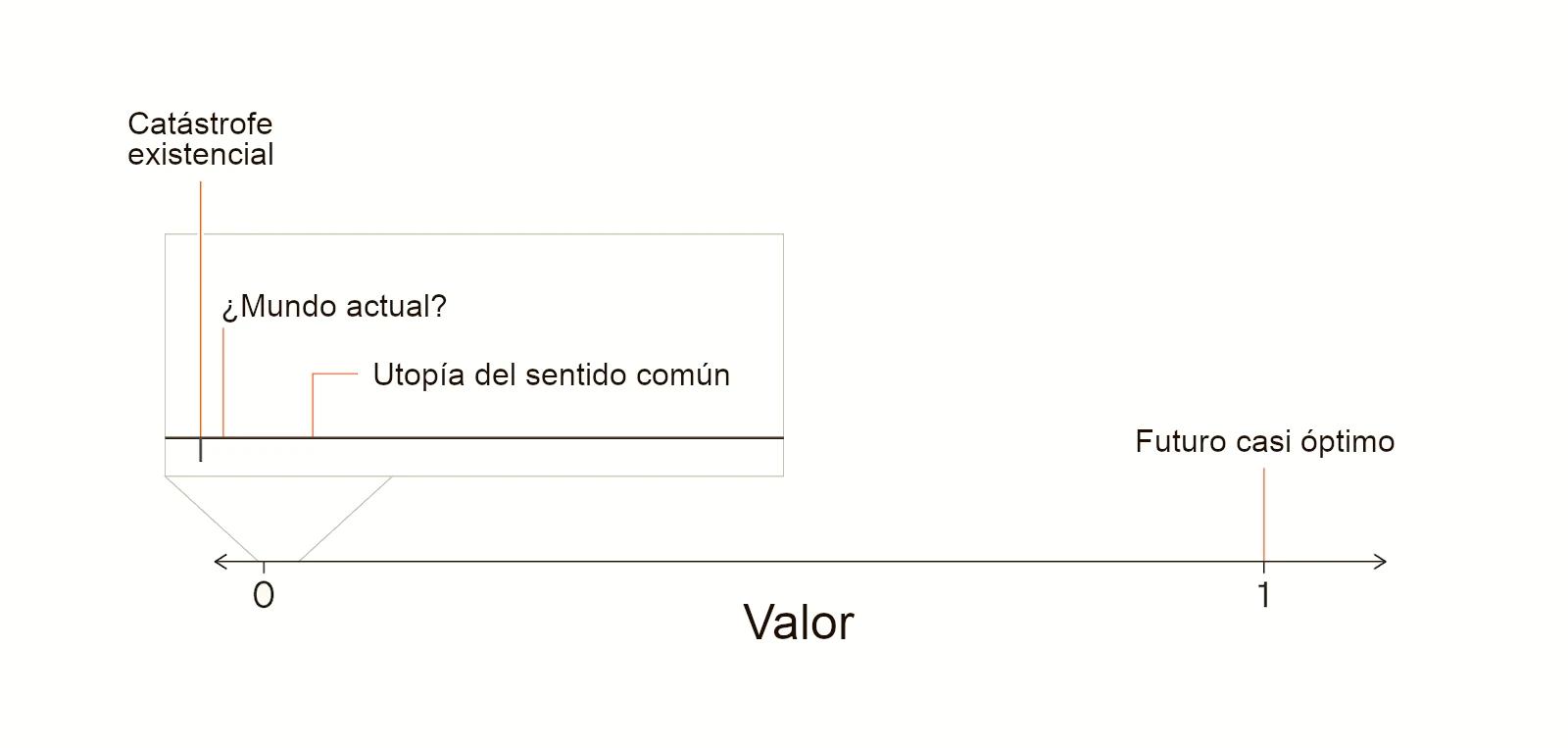

Podríamos incluso lograr un mundo que, según el sentido común, sería utópico, pero seguiríamos perdiéndonos casi todo el valor posible.

En la mitología medieval, existe una concepción de la utopía llamada “Cockaigne”, una tierra de abundancia donde nadie envejece y se puede comer y tener tanto sexo como se desee.

Hoy en día, en los países ricos, vivimos en sociedades que los campesinos medievales probablemente considerarían como Cockaigne. Pero estamos muy, muy lejos de una sociedad perfecta. Del mismo modo, lo que hoy podríamos considerar una utopía apenas roza la superficie de lo que es posible.

Teniendo en cuenta todo lo anterior, creo que hay mucho más en juego cuando se trata de Prosperar que cuando se trata de Sobrevivir.

Creo que Prosperar también está más desatendido. La razón fundamental es que el deseo latente de Sobrevivir (en este sentido) es mucho más fuerte que el deseo latente de Prosperar. La mayoría de la gente realmente no quiere morir ni verse privada de poder durante su vida. Por lo tanto, para que el riesgo existencial sea alto, tiene que producirse un fallo realmente importante de la racionalidad.

Por ejemplo, quienes controlan la IA superinteligente (y sus empleados) tendrían que estar engañados sobre el riesgo al que se enfrentan, o tener preferencias inusuales, como estar dispuestos a arriesgar sus vidas a cambio de un poco más de poder. Por otra parte, observemos la disposición a pagar agregada de Estados Unidos para evitar una probabilidad de apenas una décima de punto porcentual de una catástrofe que acabara con la humanidad: más de un billón de dólares. Los disparos de advertencia podrían desatar, al menos parcialmente, ese deseo latente, despertando una enorme atención social.

Por otro lado, ¿cuántas personas tienen el deseo latente de asegurarse que la gente dentro de miles de años no vaya a cometer algún error moral sutil pero importante? No muchas. La sociedad podría estar claramente encaminada a cometer algunos errores morales importantes y simplemente podría no importarle.

Incluso dentro de la comunidad del altruismo eficaz (y otras comunidades adyacentes), la mayor parte de la atención se centra en Sobrevivir más que en Prosperar. Afortunadamente, la seguridad de la IA y la reducción del riesgo biológico han recibido mucha más atención e inversión en los últimos años; aunque con ello, su desatención relativa disminuye.

La tratabilidad del trabajo por futuros mejores es mucho menos clara; si el argumento falla, falla aquí. Pero creo que al menos deberíamos intentar averiguar cuán tratables son las mejores intervenciones en este ámbito. Hace una década, el trabajo sobre la seguridad de la IA y la mitigación del riesgo biológico parecía increíblemente intratable. Pero el esfuerzo concertado hizo que estas áreas fueran tratables.

Creo que querremos hacer lo mismo en muchas otras áreas, incluyendo los golpes de Estado humanos facilitados por la IA, la IA para mejorar el razonamiento, la toma de decisiones y la coordinación, el carácter y la personalidad que queremos para la IA avanzada, los derechos legales deberían tener las IA, la gobernanza de los proyectos para desarrollar superinteligencia, la gobernanza del espacio profundo, etc.

Por último, aquí hay algunas advertencias para la serie en su conjunto.

En primer lugar, los ensayos tienden a utilizar un lenguaje moral realista, por ejemplo, al hablar de una ética “correcta”. Pero la mayoría de los argumentos son transferibles: se pueden traducir al lenguaje que se prefiera, por ejemplo, “lo que yo pensaría sobre la ética tras una reflexión ideal”.

En segundo lugar, solo hablo de una parte de la ética, concretamente, lo que es mejor para el futuro a largo plazo, o lo que a veces denomino “ética cósmica”. Por lo tanto, no hablo de razones obvias para querer evitar catástrofes a corto plazo, como no querer que tú y todos tus seres queridos mueran. Pero no estoy diciendo que esas no sean razones morales importantes.

En tercer lugar, pensar en mejorar el futuro a veces puede parecer inquietantemente utópico. Creo que es una preocupación real: algunos de los movimientos utópicos del siglo XX fueron muy dañinos. Y creo que eso debería hacernos actuar con especial cautela respecto a las propuestas de futuros mejores que se basan en una concepción estrecha de un futuro ideal. Dado el gran progreso moral que deberíamos esperar lograr, deberíamos asumir que prácticamente no tenemos idea de cómo podrían ser los futuros mejores posibles.

En cambio, estoy a favor de lo que he venido llamando viatopía, que es un estado del mundo en el que la sociedad puede guiarse a sí misma hacia resultados casi óptimos, sean cuales sean. Es plausible que la viatopía sea un estado de la sociedad en el que el riesgo existencial sea muy bajo, en el que puedan prosperar muchos puntos de vista morales diferentes, en el que muchos futuros posibles sigan abiertos para nosotros y en el que las decisiones importantes se tomen mediante procesos reflexivos y deliberados.

Desde mi punto de vista, la prioridad clave en el mundo actual es acercarnos a la viatopía, no a un estado final concreto y limitado. No voy a profundizar en el concepto de viatopía en esta serie, pero espero escribir más sobre él en el futuro.