Por qué la IA podría resultar catastrófica: un argumento simple en cuatro pasos

- Las mayores empresas tecnológicas del mundo están creando inteligencias que superarán a los humanos en casi todas las tareas económica y militarmente relevantes.

- Muchas de estas inteligencias ya no serán simples (aunque impresionantes) reconocedores de patrones, sino que serán mentes orientadas a objetivos que actuarán en el mundo real.

- A diferencia del software tradicional, no podemos especificar lo que estas mentes querrán ni verificar lo que harán. Solo podemos desarrollarlas y moldearlas, y esperar que el moldeado se mantenga.

- Todo esto puede acabar muy mal.

Las mayores empresas tecnológicas del mundo están creando inteligencias que serán mejores que los humanos en casi todas las tareas económica y militarmente relevantes

Los directores generales de OpenAI, Google DeepMind, Anthropic y Meta AI han declarado explícitamente que su objetivo es crear una IA de nivel humano o sobrehumana, han gastado miles de millones de dólares en ello y planean seguir gastando entre cientos de miles de millones y billones en el futuro cercano. Por “sobrehumana” no entienden “mejor que el humano medio en una sola cosa”, sino algo así como “mejor que los mejores humanos en casi todas las tareas relevantes”.

¿Tendrán éxito? Sin nadie que los detenga, probablemente sí.

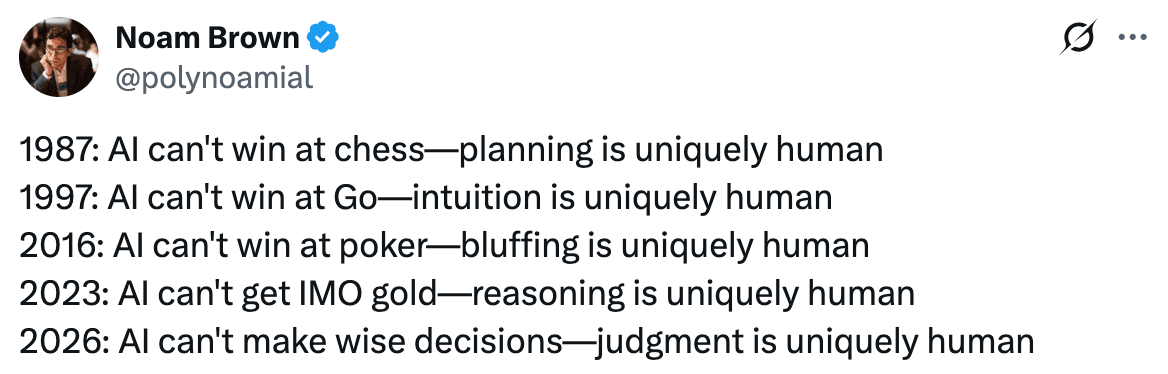

En febrero de 2026, las IA son mejores que los mejores humanos en una gama limitada de tareas (ajedrez, go, Starcraft, pronosticación meteorológica). Están a la par, aproximadamente, con profesionales cualificados en muchas otras (programación, respuesta a preguntas de conocimiento general de nivel de doctorado, matemáticas de competición, conducción urbana, cierto tipo de arte comercial, redaccióna), y son ligeramente peores que las personas en la mayoría de las tareas.b

Pero las IA no harán más que mejorar con el tiempo, y parece que lo harán rápidamente. En los últimos 10 años ya se han producido rápidos avances. Hace siete años (antes de GPT-2), los modelos de lenguaje apenas podían encadenar frases coherentes, mientras que hoy en día los modelos de lenguaje a gran escala pueden realizar con facilidad tareas de redacción de nivel universitario, y Grok, de X AI, puede cantar elaboradas alabanzas sobre cómo sodomizaría a los izquierdistas, con detalles gráficos.c

Cabe destacar que, aunque históricamente el progreso de la IA ha variado según los diferentes ámbitos, la tendencia de la última década ha sido que su progreso sea cada vez más general. Es decir, las IA avanzarán hasta el punto de poder realizar todas (o casi todas) las tareas, y no solo un conjunto limitado de tareas especializadas. Hoy en día, la IA es responsable de entre el 1 % y el 3 % de la economía estadounidense, y es probable que la de este año sea la fracción más pequeña de la economía mundial que la IA represente jamás.

A aquellas personas que no estén convencidas por estos argumentos generales, les recomiendo que comprueben por sí mismas los avances y las capacidades de la IA. En particular, sugiero que comparen las capacidades de los modelos antiguos con las de los actuales y observen las rápidas mejoras. AI Digest, por ejemplo, tiene una buena guía interactiva.

Es importante destacar que todos, excepto los pronosticadores más optimistas, han subestimado de forma sistemática y drástica la velocidad del progreso de la IA. En 1997, los expertos creían que pasarían 100 años antes de que la IA pudiera superar a los humanos en el Go. En 2022 (!), la mediana de los investigadores encuestados pensaba que la IA no podría escribir funciones sencillas en Python antes de 2027. Para diciembre de 2024, la inteligencia artificial ya escribía entre el 11 % y el 31 % de todo el código Python nuevo.e

Hoy en día, las personas más involucradas en estas tecnologías creen que muy pronto podrán desarrollar una inteligencia artificial general sobrehumana. Dario Amodei, director general de Anthropic AI, cree que lo más probable es que sea en unos años, posiblemente tan pronto como 2027. Demis Hassabis, director general de Google DeepMind, cree que sucederá en un plazo de 5 a 10 años.

Aunque no está claro exactamente cuándo las IA llegarán a ser drásticamente mejores que los humanos en casi todas las tareas económica y militarmente relevantes, la alta probabilidad de que esto ocurra relativamente pronto (no mañana, probablemente no este año, no está clarof si al final serán 3 años o 30) debería preocuparnos bastante a todos por lo que sucederá después.

Muchas de estas inteligencias ya no serán simples (aunque impresionantes) reconocedores de patrones, sino que serán mentes orientadas a objetivos que actuarán en el mundo real

Muchas personas asienten a argumentos como los de los párrafos anteriores, pero asumen que las IA futuras tendrán una “inteligencia sobrehumana” en un sentido abstracto, sin dejar de ser chatbots, como los modelos de lenguaje de hoy en día.g Instintivamente, imaginan las IA futuras como chatbots superiores, o como una mera enciclopedia con conocimiento sobrehumano.

Creo que esto es muy incorrecto. Es posible que algunas inteligencias artificiales del futuro parezcan meras enciclopedias, pero muchas no lo serán. Hay al menos dos formas distintas en las que muchas IA sobrehumanas no se parecerán a enciclopedias superinteligentes:

- Tendrán fuertes tendencias de búsqueda de objetivos, planificación y capacidad para lograr metas.

- Controlarán robots físicos y otras máquinas para interactuar y lograr sus objetivos en el mundo real.h

¿Por qué creo esto?

En primer lugar, ya existen muchos esfuerzos para hacer que los modelos estén más orientados a objetivos, así como esfuerzos para avanzar en la robótica de modo que los modelos puedan controlar más fácilmente cuerpos robóticos y otras máquinas. A través de Claude Code, los modelos Claude de Anthropic son (en comparación con las interfaces de chatbot de 2023 y 2024) sustancialmente más orientados a objetivos, capaces de ejecutar de forma autónoma proyectos de programación, ayudar a las personas con la planificación de viajes, etc.

Los modelos ya son lo suficientemente autónomos como para que (como mero efecto secundario de su entrenamiento) se pueda demostrar en algunas condiciones de laboratorio que chantajean a los desarrolladores para evitar ser reemplazados. ¡Esto parece algo preocupante por sí solo!

Del mismo modo, las empresas tecnológicas ya están construyendo robots que actúan en el mundo real y pueden ser controlados por la IA:

En segundo lugar, las tendencias apuntan claramente en esta dirección. Las IA no son muy generales hoy en día en comparación con los humanos, pero son mucho más inteligentes y generales que hace unos años. Del mismo modo, tampoco están muy orientadas a objetivos en este momento, especialmente en comparación con los humanos e incluso con muchos animales no humanos, pero están mucho más orientadas a objetivos que hace tan solo dos años.

Las IA actuales tienen una capacidad de planificación limitada (a menudo con horizontes temporales del orden de varias horas), tienen dificultades para mantener la coherencia de los planes a lo largo de los días y su capacidad para interactuar con el mundo físico es limitada.

Todo esto ha mejorado drásticamente en los últimos años y, si las tendencias continúan (y no hay ninguna razón fundamental para que no sea así), cabe esperar que sigan “mejorando” en un futuro previsible.

En tercer lugar, y quizás lo más importante, existen enormes incentivos económicos y militares para desarrollar un mayor comportamiento de búsqueda de objetivos en las IA. Más allá de las tendencias actuales, la razón por la cual las empresas y los gobiernos quieren desarrollar IA orientadas a objetivos es simple: realmente quieren hacerlo.

Un dron militar que puede evaluar de forma autónoma un nuevo campo de batalla, elaborar sus propios planes complejos y atacar con una velocidad sobrehumana a menudo será preferible a uno que “solo” tenga una capacidad sobrehumana para identificar objetivos, pero que aún necesite a un humano lento y falible para dirigir cada acción.

Del mismo modo, un asesor de IA sobrehumano que puede darte consejos sobrehumanos sobre cómo dirigir bien tu fábrica es sin duda útil. Pero, ¿sabes qué es aún más útil? Una IA que pueda dirigir de forma autónoma una fábrica por completo, incluyendo la gestión de la logística, el funcionamiento, la mejora de la distribución de la fábrica, la contratación y el despido de trabajadores (humanos), la gestión de un grupo mixto de trabajadores humanos y robots, la coordinación entre copias de sí misma para implementar procesos sobrehumanos de producción, etc.

Por lo tanto, no creo que las IA superinteligentes seguirán siendo chatbots para siempre (y quizá nunca lo sean). Los incentivos económicos y militares para convertirlas en mentes que persiguen objetivos y optimizan en el mundo real son, en la práctica, sencillamente demasiado altos.

Mi opinión es que las IA sobrehumanas no serán meros agentes infrahumanos en cuanto a la planificación y sobrehumanos en cuanto al pensamiento científico, sino que algún día tendrán también una capacidad sobrehumana para la planificación y la búsqueda de objetivos en el mundo real.

A diferencia del software tradicional, no podemos especificar lo que estas mentes querrán ni verificar lo que harán. Solo podemos desarrollarlas y moldearlas, y esperar que el moldeado se mantenga

En términos generales, el software tradicional se programa. Las IA modernas no.

En el software tradicional, se especifica exactamente lo que hace el software de forma precisa, dada una condición precisa (por ejemplo, “si el lector hace clic en el botón de suscripción, abrir una ventana emergente”).

Las IA modernas funcionan de manera muy diferente: primero se las hace crecer y luego se las moldea.

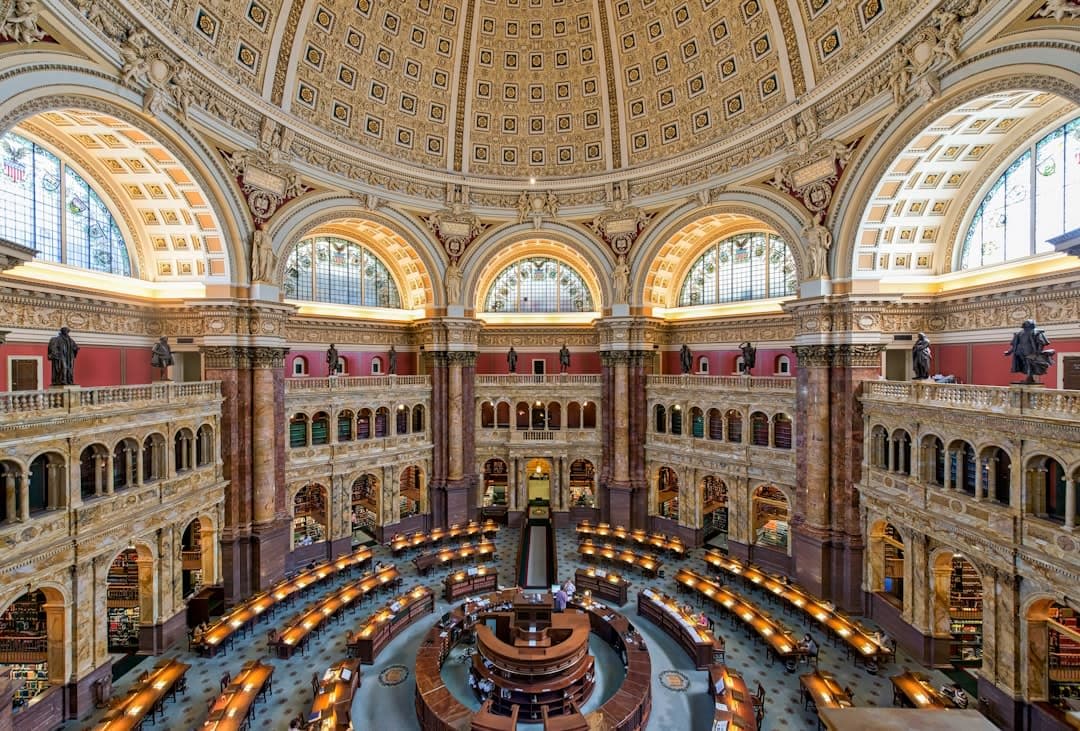

Se comienza con una gran cuba de neuronas digitales indiferenciadas. A las neuronas se las alimenta con mucha información, equivalente a varios miles de bibliotecas. A lo largo de este lento proceso de entrenamiento, las neuronas adquieren conocimiento sobre el mundo de la información y heurísticas sobre cómo se estructura esta información, en diferentes niveles de abstracción (las palabras en inglés siguen a palabras en inglés, los adjetivos en inglés preceden a otros adjetivos o sustantivos, c2 sigue a e=m, etc.).

Al final de este ciclo de entrenamiento, se obtiene lo que las empresas de IA modernas denominan un “modelo base”, un modelo con una capacidad sobrehumana para predecir qué palabras siguen a otras.

Un modelo así es interesante, pero no muy útil. Si le preguntas a un modelo base: “¿Puedes ayudarme con mis impuestos?”, una respuesta estadísticamente válida bien podría ser “Vete a la mierda”. Esto es válido y estadísticamente común en los datos de entrenamiento, pero no resulta útil para hacer la declaración de impuestos.

Por lo tanto, el siguiente paso es dar forma: condicionar a las IA para que sean útiles y económicamente valiosas para los propósitos humanos.

A continuación, el modelo base se coloca en diversos entornos en los que asume el papel de una “IA” y se le condiciona para que tome la decisión “correcta” en diversos escenarios (ser un chatbot amigable y útil, ser un buen programador con buen criterio de programación, razonar como un matemático para responder bien a preguntas de concursos matemáticos, etc.).

Una categoría amplia de condicionamiento es lo que a veces se denomina coloquialmente alineación: dados los objetivos inherentes a la IA, condicionar su comportamiento de manera que comparta ampliamente los objetivos humanos en general y, en particular, los de las empresas de IA.

Probablemente esto funcione… hasta cierto punto. Las IA que desafían de forma abierta y transparente a sus usuarios y creadores en situaciones similares a las que encontraron en el pasado —por ejemplo, negándose claramente a seguir instrucciones o avergonzando a su empresa matriz y provocando desastres previsibles de relaciones públicas— se corrigen y (en su mayoría) se condicionan y penalizan. A corto plazo, cabe esperar que desastres obvios como los “nazis negros” de Google Gemini y el “MechaHitler” de Grok, de Elon Musk, disminuyan.

Sin embargo, es poco probable que estas soluciones improvisadas sean algo más que un parche a medio y largo plazo:

- A medida que las IA ganan inteligencia, se vuelven conscientes de la evaluación: es decir, saben cada vez mejor cuándo se las está evaluando en busca de ejemplos de desalineación y se cuidan de ocultar los indicios de que sus objetivos reales no son exactamente los que pretendían sus creadores.

- A medida que las IA se vuelven más orientadas a objetivos o agénticas, es probable que desarrollen instintos más fuertes de autoconservación y preservación de objetivos.

- Ya observamos esto en evaluaciones en las que (todavía) no son lo suficientemente inteligentes como para ser plenamente conscientes de la evaluación; en muchas situaciones, casi todos los modelos de vanguardia están dispuestos a intentar chantajear a los desarrolladores para evitar que los desconecten.

- A medida que las IA se vuelven más orientadas a objetivos y se integran cada vez más en entornos del mundo real, se encontrarán con situaciones cada vez más novedosas, incluidas situaciones muy diferentes tanto de las bibliotecas de datos con las que se han entrenado como de los entornos simplificados en los que han sido condicionadas.

Estas situaciones se producirán cada vez con más frecuencia a medida que alcancemos el umbral en el que las IA sean ampliamente más sobrehumanas, tanto en capacidad general como en la búsqueda de objetivos en el mundo real.

Así pues, en resumen, tendremos cada vez más mentes no humanas con capacidades sobrehumanas, operando en el mundo real, capaces de buscar objetivos mucho mejor que la humanidad y con una amalgama de objetivos improvisados, al menos en cierta medida diferentes de los objetivos humanos.

Lo que me lleva al siguiente punto:

Todo esto puede acabar muy mal

Antes de pasar a la última sección, quiero que reflexiones un poco sobre dos preguntas:

- ¿Te parece inverosímil alguno de los puntos anteriores?

- Si son ciertos, ¿te reconforta? ¿Sientes que la humanidad está en buenas manos?

Creo que los puntos anteriores por sí solos deberían bastar para que la mayoría de la gente se preocupe significativamente. Puedes cuestionar los detalles específicos de cualquiera de estos puntos de la sección anterior o estar en desacuerdo con mi modelo de amenazas a continuación. Pero creo que la mayoría de las personas razonables verán algo similar a mi argumento y se sentirán bastante preocupadas.

Ahora expliquemos con algún detalle cómo podría ser la situación estratégica tras la llegada de la IA sobrehumana.

Mentes mejores que las humanas para conseguir lo que quieren, que desean cosas lo suficientemente diferentes de lo que nosotros queremos, remodelarán el mundo para adaptarlo a sus propósitos, no a los nuestros.

Esto puede incluir la extinción de la humanidad, ya que los planes de la IA podrían implicar matar a la mayoría o a todos los humanos, o destruir de otro modo la civilización humana, ya sea como medida preventiva o como efecto secundario.

Como medida preventiva: como se ha establecido anteriormente, es poco probable que los objetivos humanos coincidan perfectamente con los de las IA. Por lo tanto, las IA sobrehumanas incipientes podrían desear matar preventivamente o neutralizar de otro modo las capacidades humanas para impedir que tomemos medidas que no les gusten. En particular, las primeras IA sobrehumanas podrían llegar a preocuparse razonablemente de que los humanos desarrollen superinteligencias rivales.

Como efecto secundario: Muchos de los objetivos que una IA podría tener no incluyen el florecimiento humano, ni directamente ni como efecto secundario. En tales situaciones, la humanidad podría simplemente perecer como efecto colateral de que mentes sobrehumanas optimicen el mundo para lo que ellas quieren, en lugar de lo que nosotros queremos. Por ejemplo, si los centros de datos pudieran funcionar de manera más eficiente si el mundo entero estuviera mucho más frío, o careciera de atmósfera. Alternativamente, si se desarrollan varias mentes sobrehumanas distintas al mismo tiempo y creen que la guerra es mejor que la cooperación para alcanzar sus objetivos, la humanidad podría ser solo una nota al pie en las guerras de la IA, del mismo modo que las bajas de murciélagos fueron una mera nota al pie en la primera Guerra del Golfo.

Nótese que nada de esto requiere que las IA sean “malvadas” en ningún sentido dramático, ni que sean fenomenológicamente conscientes, ni que “piensen realmente” de alguna manera humana especial, ni implica ninguno de los otros debates populares en la filosofía de la IA. No requiere que nos odien, ni que un día se despierten y decidan rebelarse. Solo requiere que sean muy capaces, que deseen cosas ligeramente diferentes a lo que nosotros queremos y que actúen en base a esos deseos. El resto se desprende de la lógica estratégica ordinaria, la misma lógica que aplicaríamos a cualquier agente drásticamente más poderoso cuyos objetivos no coincidan perfectamente con los nuestros.

Conclusión

Esa es la situación. Las empresas más poderosas del mundo están construyendo mentes que pronto nos superarán. Esas mentes serán agentes que persiguen objetivos, no solo enciclopedias parlantes. No podemos especificar ni verificar completamente sus objetivos. Y el resultado por defecto de compartir el mundo con seres mucho más capaces que tú, que quieren cosas distintas a las tuyas, es que no consigues lo que quieres.

Ninguna de las premisas individuales aquí planteadas es exótica. La conclusión parece descabellada principalmente porque la situación es descabellada. Estamos viviendo el desarrollo de la tecnología más transformadora y peligrosa de la historia de la humanidad, y las personas que la construyen coinciden ampliamente con esa descripción. La pregunta es simplemente qué hacemos al respecto, si es que hacemos algo.

¿Significa eso que estamos condenados? No, no necesariamente. Existe la posibilidad de que la estrategia fragmentaria de seguridad de la IA de las empresas líderes funcione lo suficientemente bien como para que no muramos todos, aunque ciertamente no quiero confiar en ello. Una regulación eficaz y la presión pública podrían aliviar algunos de los casos más graves de recortes en seguridad debidos a las presiones competitivas. La investigación académica, gubernamental y sin ánimo de lucro sobre seguridad también puede aumentar ligeramente nuestras probabilidades de supervivencia, parte de la cual he ayudado a financiar.

Si hay suficiente presión por parte del público, la sociedad civil y los líderes políticos de todo el mundo, tal vez podamos lograr acuerdos internacionales para una ralentización o una pausa global en el desarrollo futuro de la IA. Y además, tal vez tengamos suerte y todo salga bien por alguna razón imprevisible.

Pero la esperanza no es una estrategia. Así como la fatalidad no es inevitable, tampoco lo es la supervivencia. La supervivencia y el florecimiento continuado de la humanidad son posibles, pero están lejos de estar garantizados. Todos debemos decidirnos a realizar el largo y arduo trabajo de asegurarlos.