Plazos de la inteligencia artificial: qué dicen los argumentos y los “expertos”

Este artículo comienza con un resumen de cuándo deberíamos esperar que se desarrolle una IA transformadora, basándose en las múltiples perspectivas consideradas anteriormente en la serie. Creo que es un resumen útil, incluso si has leído todos los artículos anteriores, pero si quieres saltártelo, haz clic aquí.

A continuación abordo la pregunta: “¿Por qué no hay un consenso sólido entre los expertos sobre este tema, y qué significa eso para nosotros?”

Estimo que hay una probabilidad de más de un 10 % de que se desarrolle una IA transformadora en los próximos 15 años (antes de 2036); una probabilidad de aproximadamente un 50 % de que se desarrolle en los próximos 40 años (antes de 2060); y una probabilidad de unos dos tercios de que se desarrolle este siglo (antes de 2100).

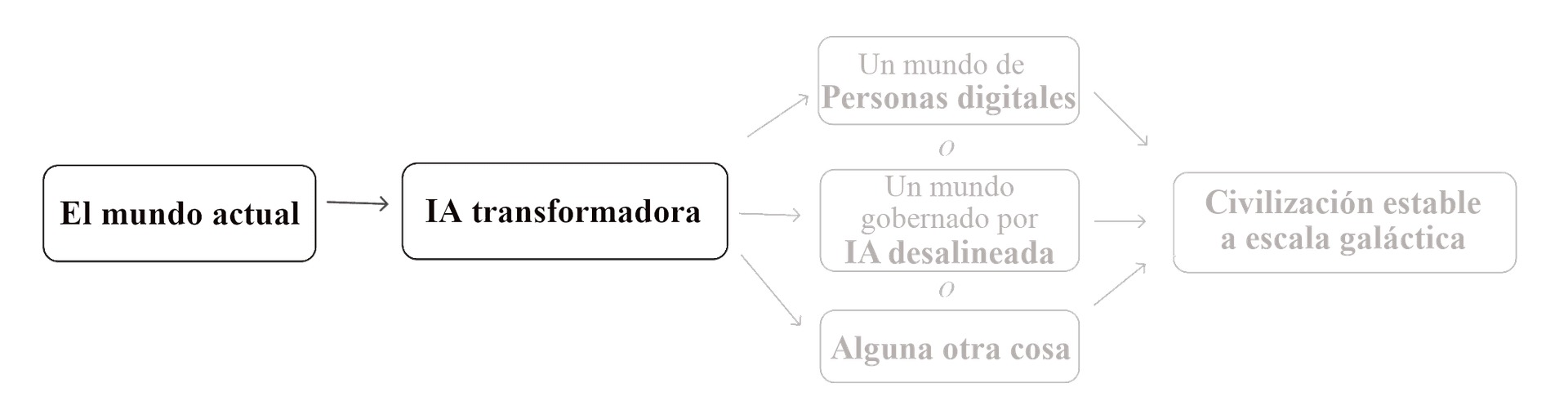

(Por “IA transformadora” me refiero a “una IA lo suficientemente potente como para llevarnos a un futuro nuevo y cualitativamente diferente”. Me centro específicamente en lo que llamo PAACT: sistemas de IA que pueden automatizar esencialmente todas las actividades humanas necesarias para acelerar el avance científico y tecnológico. He argumentado que el PAACT podría ser suficiente para hacer de este el siglo más importante, por su potencial para desencadenar una explosión de la productividad y para generar riesgos derivados de una IA desalineada.)

Esta es mi conclusión general, basada en una serie de informes técnicos que abordan la pronosticación de la IA desde distintas perspectivas, muchos de ellos elaborados por Open Philanthropy en los últimos años, en los que hemos intentado desarrollar un panorama completo de la pronosticación de la IA transformadora para orientar nuestra asignación de becas relacionadas con el largoplacismo.

He aquí una tabla sinóptica con los distintos tipos de pronóstico de la IA transformadora que he analizado y con enlaces a análisis más detallados incluidos en entradas anteriores, así como a los informes técnicos correspondientes:

| Tipo de pronóstico | Informes principales | Mis conclusiones |

|---|---|---|

| Estimaciones de probabilidad para la IA transformadora | ||

| Encuesta a los expertos. ¿Qué expectativas tienen los investigadores de la IA? | When will AI exceed human performance? Evidence from AI experts | La encuesta a los expertos implicaa una probabilidad aproximada de un 20 % para 2036; una probabilidad aproximada de un 50 % para 2060; una probabilidad aproximada de un 70 % para 2100. Otras preguntas formuladas de forma ligeramente distinta (a una minoría de los encuestados) arrojan estimaciones mucho más tardías. |

| Marco de anclajes biológicos. Partiendo de los patrones habituales en los costos del “entrenamiento de la IA”, ¿cuánto costaría entrenar un modelo de IA tan grande como un cerebro humano para realizar las tareas más difíciles que hacen los humanos? ¿Y cuándo será lo suficientemente barato como para que podamos esperar que alguien lo haga? | Draft report on AI timelines, basado en How much computational power does it take to match the human brain? | más de un 10 % de probabilidad para 2036; aproximadamente un 50 % de probabilidad para 2055; aproximadamente un 80 % de probabilidad para 2100. |

| Perspectivas sobre la carga de la prueba | ||

| Es poco probable que un siglo en particular sea el “más importante”. (Más) | ‘¿Estamos viviendo en la bisagra de la historia?’; Thoughts on whether we’re living at the most influential time in history | Tenemos muchas razones para pensar que este siglo es “especial” antes de analizar los detalles de la IA. Muchas se han tratado en artículos anteriores; otra se trata en el siguiente. |

| ¿Qué pronosticarías sobre los plazos de la IA transformadora, basándote solo en información básica sobre (a) cuántos años lleva la gente intentando construir una IA transformadora; (b) cuánto se ha “invertido” en ella (en términos del número de investigadores de IA y la cantidad de cómputo que han utilizado); (c) si ya se ha conseguido (de momento, no)? (Más) | Semi-informative priors over AI timelines | Estimaciones centrales: 8 % para 2036; 13 % para 2060; 20 % para 2100.b En mi opinión, este informe pone de relieve que la historia de la IA es corta, que la inversión en IA está aumentando rápidamente y que, por tanto, no debería sorprendernos demasiado que se desarrolle pronto una IA transformadora. |

| Según el análisis de los modelos económicos y la historia de la economía, ¿hasta qué punto es probable un “crecimiento explosivo” —definido como un crecimiento anual de la economía mundial superior al 30 %— de aquí a 2100? ¿Está tan lejos de lo “normal” como para que debamos dudar de la conclusión?(Más) | Report on whether AI could drive explosive economic growth, Modeling the human trajectory | Modeling the human trajectory proyecta el pasado hacia el futuro, lo que implica un crecimiento explosivo para 2043–2065. Report on whether AI could drive explosive economic growth concluye: “Creo que las consideraciones económicas no son una buena razón para descartar la posibilidad de que la IAT se desarrolle en este siglo. De hecho, existe una perspectiva económica plausible desde la que se espera que los sistemas de IA suficientemente avanzados provoquen un crecimiento explosivo.” |

| “¿Cómo ha predicho la gente la IA […] en el pasado?, y ¿deberíamos ajustar nuestras propias opiniones hoy para corregir los patrones que podemos observar en predicciones anteriores? […] Nos hemos encontrado con la opinión de que la IA ha sido propensa a la exageración repetida en el pasado, y que, por lo tanto, deberíamos esperar que las proyecciones actuales sean probablemente demasiado optimistas.” (Más) | What should we learn from past AI forecasts? | “El punto álgido de la exageración de la IA parece haber sido entre 1956 y 1973. Aun así, a menudo se pone un énfasis excesivo en la exageración implícita en algunas de las predicciones de IA más conocidas de este periodo.” |

En aras de la transparencia, nótese que muchos de los informes técnicos son análisis de Open Philanthropy, y que yo soy codirector general de Open Philanthropy.

Teniendo en cuenta todo lo anterior, creo que algunos lectores seguirán sintiéndose incómodos. Aunque piensen que mis argumentos tienen sentido, es posible que se pregunten: si esta tesis es correcta, ¿por qué no se la discute y acepta más ampliamente? ¿Cuál es el estado de la opinión de los expertos?

Mi resumen del estado de la opinión de los expertos en este momento es:

- Las afirmaciones que hago no contradicen ningún consenso particular de los expertos. (De hecho, las probabilidades que he dado no están muy lejos de lo que parecen predecir los investigadores de IA, como se muestra en la primera fila.) Pero hay algunos indicios de que no están pensando demasiado en el asunto.

- Los informes técnicos de Open Philanthropy en los que me he basado han sido reseñados por expertos externos. Investigadores de aprendizaje automático reseñaron Draft report on AI timelines; neurocientíficos reseñaron How much computational power does it take to match the human brain?; economistas reseñaron Report on whether AI could drive explosive economic growth; académicos centrados en temas relevantes en materia de incertidumbre y/o probabilidad reseñaron Semi-informative priors over AI timelines.c (Algunas de estas reseñas tenían puntos de desacuerdo significativos, pero ninguno de estos puntos parecían ser casos en los que los informes contradijeran un claro consenso de los expertos o de la literatura.)

- Pero tampoco existe un consenso activo y sólido entre los expertos que respalde afirmaciones como “Hay al menos un 10 % de probabilidades de que se desarrolle una IA transformadora antes de 2036” o “Es muy probable que estemos en el siglo más importante para la humanidad”, del mismo modo que se respalda, por ejemplo, la necesidad de tomar medidas contra el cambio climático.

En última instancia, mis afirmaciones se refieren a temas para los que simplemente no hay un “campo” de expertos dedicados a estudiarlos. Eso, en sí mismo, es un hecho aterrador, y algo que espero que cambie con el tiempo.

Pero, mientras tanto, ¿debería guiar nuestras acciones la hipótesis del “siglo más importante”?

A continuación, discutiré:

- Qué aspecto podría tener un “campo de pronosticación de la IA”.

- Un “punto de vista escéptico” que afirma que los debates actuales sobre estos temas son demasiado reducidos, homogéneos e insulares (con lo que estoy de acuerdo) y que, por tanto, la hipótesis del “siglo más importante” no debería guiar nuestras acciones hasta que exista un campo maduro y sólido (con lo que no estoy de acuerdo).

- Por qué creo que deberíamos tomarnos en serio la hipótesis mientras tanto, hasta que se desarrolle dicho campo:

- No tenemos tiempo para esperar a que haya un consenso sólido entre los expertos.

- Si hay buenas refutaciones por ahí —o futuros expertos potenciales que podrían desarrollar tales refutaciones— aún no las hemos encontrado. Cuanto más en serio se tome la hipótesis, más probabilidades habrá de que aparezcan esas refutaciones. (También conocida como la Ley de Cunningham: “el mejor modo de obtener la respuesta correcta en Internet no es hacer una pregunta, es escribir la respuesta incorrecta”).

- Creo que insistir sistemáticamente en un sólido consenso de los expertos es un patrón de razonamiento peligroso. En mi opinión, está bien correr cierto riesgo de engañarnos y de caer en la insularidad, a cambio de hacer lo correcto en el momento más importante.

¿Qué tipo de especialización es la pronosticación de la IA?

Las preguntas analizadas en los informes técnicos enumerados más arriba incluyen:

- ¿Son las capacidades de la IA cada vez más impresionantes con el paso del tiempo? (IA, historia de la IA)

- ¿Cómo podemos comparar los modelos de IA con los cerebros animales/humanos? (IA, neurociencia)

- ¿Cómo podemos comparar las capacidades de la IA con las de los animales? (IA, etología)

- ¿Cómo podemos estimar el costo de entrenar un sistema de IA a gran escala para una tarea difícil, basándonos en la información que tenemos sobre el entrenamiento de sistemas de IA anteriores? (IA, ajuste de curvas)

- ¿Cómo podemos hacer una estimación de información mínima sobre la IA transformadora, basándonos únicamente en cuántos años/investigadores/dólares se han invertido en este campo hasta la fecha? (filosofía, probabilidad)

- ¿Qué probabilidades hay de que se produzca un crecimiento económico explosivo este siglo, según la teoría y las tendencias históricas? (economía del crecimiento, historia económica)

- ¿Cómo ha sido la “exageración de la IA” en el pasado? (historia)

Al hablar de implicaciones más amplias de la IA transformadora para el “siglo más importante”, también he discutido cosas como “¿Hasta qué punto son viables las personas digitales y el establecimiento de asentamientos espaciales en toda la galaxia?” Estos temas abarcan la física, la neurociencia, la ingeniería, la filosofía de la mente y otras disciplinas.

No hay ningún trabajo o credencial obvia que convierta a alguien en un experto en la cuestión de cuándo podemos esperar el surgimiento de una IA transformadora, o en la cuestión de si estamos en el siglo más importante.

(En particular, no estoy de acuerdo con la afirmación de que deberíamos confiar exclusivamente en los investigadores de IA para estos pronósticos. Además del hecho de que no parecen estar pensando mucho sobre el tema, creo que confiar en personas especializadas en construir modelos de IA cada vez más potentes para que nos digan cuándo podría llegar la IA transformadora es como confiar en empresas de investigación y desarrollo de energía solar —o de extracción de petróleo, según cómo se lo mire— para pronosticar las emisiones de carbono y el cambio climático. Sin duda tienen parte de razón. Pero la pronosticación es una actividad distinta de la innovación o construcción de sistemas de vanguardia.)

Y ni siquiera estoy seguro de que estas preguntas tengan la forma adecuada para un campo académico. Tratar de pronosticar la IA transformadora, o determinar las probabilidades de que estemos en el siglo más importante, parece:

- Más similar al modelo electoral de FiveThirtyEight (“¿Quién va a ganar las elecciones?”) que a la ciencia política académica (“¿Cómo interactúan los gobiernos y los electores?”);

- Más similar a los mercados financieros (“¿Subirá o bajará este precio en el futuro?”) que a la economía académica (“¿Por qué existen las recesiones?”);d

- Más similar a la investigación de GiveWell (“¿Qué organización benéfica ayudará más a la gente, por dólar?”) que a la economía del desarrollo académica (“¿Qué causa la pobreza y qué puede reducirla?”)e

Es decir, no tengo claro cuál sería el “hogar institucional” natural de los conocimientos especializados sobre la pronosticación de la IA transformadora y el “siglo más importante”. Pero parece justo decir que hoy en día no existen instituciones grandes y sólidas dedicadas a este tipo de cuestiones.

¿Cómo debemos actuar en ausencia de un sólido consenso entre los expertos?

La perspectiva escéptica

A falta de un consenso sólido entre los expertos, supongo que algunas personas (en realidad, la mayoría) se mostrarán escépticas independientemente de los argumentos que se presenten.

He aquí una versión de una reacción escéptica muy general por la que siento bastante empatía:

- Todo esto es demasiado descabellado.

- Estás haciendo una afirmación grandilocuente acerca de vivir en el siglo más importante. Esto tiene toda la apariencia de que te estás engañando.

- Has argumentado que la carga de la prueba no debería ser tan pesada, porque hay muchas formas en las que la época en que vivimos es notable e inestable. Pero… no confío en mi propia capacidad para evaluar esas afirmaciones, o tus afirmaciones sobre la IA, o realmente cualquier otra cosa sobre estos temas descabellados.

- Me preocupa que haya tan pocas personas que parecen discutir estos argumentos. Me preocupa lo pequeño, homogéneo e insular que parece ser el debate. En general, esto parece más bien una ficción que algunas personas inteligentes se cuentan a sí mismas —con muchos gráficos y cifras para racionalizarla— para exaltar su lugar en la historia. No parece “real”.

- Así que llámame cuando haya un campo maduro de quizás cientos o miles de expertos, criticándose y evaluándose unos a otros, que hayan alcanzado el mismo tipo de consenso que vemos en el caso del cambio climático.

Entiendo que te sientas así, y yo también me he sentido así a veces, sobre todo en lo que se refiere a los puntos 1 a 4. Pero voy a dar tres razones por las que el punto #5 no parece correcto.

Razón 1: no tenemos tiempo para esperar un consenso sólido de los expertos

Me preocupa que la llegada de la IA transformadora pueda convertirse en una especie de versión en cámara lenta de la pandemia de COVID-19, pero con mayores riesgos. Si nos fijamos en la mejor información y los mejores análisis disponibles hoy en día, hay motivos para esperar que ocurra algo grande. Pero la situación es en gran medida desconocida; no encaja en los patrones que nuestras instituciones manejan habitualmente. Y cada año de acción adicional es valioso.

También podría pensarse que es una versión acelerada de la dinámica del cambio climático. Imaginemos que las emisiones de gases de efecto invernadero hubieran empezado a aumentar hace pocof (en lugar de a mediados del siglo XIX), y que no existiera la climatología como campo establecido. Sería muy mala idea esperar décadas a que surgiera un campo para empezar a reducir las emisiones.

Razón 2: La Ley de Cunningham (“el mejor modo de obtener la respuesta correcta en Internet no es hacer una pregunta, es escribir la respuesta incorrecta”) puede ser nuestra mejor esperanza para encontrar el error en estos argumentos

Lo digo en serio.

Hace varios años, algunos colegas y yo sospechábamos que la hipótesis del “siglo más importante” podía ser cierta. Pero antes de tomarla demasiado en serio, queríamos ver si podíamos encontrarle defectos fatales.

Una forma de interpretar nuestras acciones de los últimos años es como si estuviéramos haciendo todo lo posible para descubrir que la hipótesis es errónea.

En primer lugar, intentamos hablar con gente sobre los argumentos clave: investigadores de IA, economistas, etc. Sin embargo:

- Teníamos ideas vagas sobre los argumentos de esta serie (en su mayoría o quizás totalmente tomados de otras personas). No fuimos capaces de exponerlos con claridad y especificidad.

- Hubo muchos puntos fácticos clave que, en nuestra opinión, era probable que se verificaran,g pero que no habíamos precisado y que no pudimos presentar para que fueran criticados.

- En general, ni siquiera pudimos articular un argumento lo bastante concreto como para dar a los demás una oportunidad justa de rebatirlo.

Así que nos esforzamos mucho en elaborar informes técnicos sobre muchos de los argumentos clave. (Estos informes ahora son públicos y se incluyen en la tabla al principio de este artículo.) Esto nos puso en situación de publicar los argumentos y, potencialmente, encontrar contraargumentos fatales.

A continuación, encargamos reseñas a expertos externos.h

Hablando en nombre propio solamente, la hipótesis del “siglo más importante” parece haber sobrevivido a todo esto. De hecho, tras examinar las numerosas perspectivas y profundizar en los detalles, creo en ella con más fuerza que antes.

Pero digamos que esto se debe simplemente a que los verdaderos expertos —personas que aún no hemos encontrado, con contraargumentos devastadores— consideran que todo esto es tan tonto que no se molestan en participar en la discusión. O digamos que hoy en día hay gente que algún día podría convertirse en experta en estos temas y echar por tierra estos argumentos. ¿Qué podríamos hacer para lograr que esto ocurra?

La mejor respuesta que se me ocurre es: “Si esta hipótesis fuera más conocida, más aceptada y más influyente, recibiría un mayor escrutinio crítico”.

Esta serie es un intento de dar un paso en esa dirección: avanzar hacia una mayor credibilidad de la hipótesis del “siglo más importante”. Esto sería bueno si la hipótesis fuera cierta; también parece el mejor siguiente paso si mi único objetivo fuera poner en tela de juicio mis creencias y descubrir que es falsa.

Por supuesto, no estoy diciendo que aceptes o promuevas la hipótesis del “siglo más importante” si no te parece correcta. Pero creo que si tu única reserva es que no hay un consenso sólido al respecto, seguir ignorando la situación parece extraño. Si la gente se comportara así en general (ignorando cualquier hipótesis no respaldada por un consenso robusto), no estoy seguro de entender cómo cualquier hipótesis —incluidas las verdaderas— pasaría de ser marginal a ser aceptada.

Razón 3: el escepticismo tan general parece una mala idea

Cuando estaba dedicado a GiveWell, la gente de vez en cuando decía algo parecido a lo siguiente: “No se puede exigir a todos los argumentos lo que exige GiveWell a sus organizaciones benéficas recomendadas: ensayos controlados aleatorizados, datos empíricos sólidos, etc. Algunas de las mejores oportunidades de hacer el bien serán las menos obvias, así que esta norma corre el riesgo de descartar algunas de las mayores oportunidades potenciales de tener impacto.”

Creo que esto es correcto. Creo que es importante revisar el enfoque general que uno tiene sobre el razonamiento y las normas de evidencia y preguntarse: “¿Cuáles son algunos escenarios en los que mi enfoque falla, y en los que realmente preferiría que tuviera éxito?” En mi opinión, está bien correr cierto riesgo de engañarnos y de caer en la insularidad, a cambio de hacer lo correcto en el momento más importante.

Creo que la preocupación por estos riesgos y por la falta de un consenso sólido entre los expertos es una buena razón para explorar a fondo la hipótesis del “siglo más importante”, en lugar de aceptarla inmediatamente. Podemos preguntarnos dónde puede haber un error no descubierto, buscar algún sesgo que nos lleve a exaltar nuestra propia importancia, investigar las partes del argumento que parezcan más cuestionables, etc.

Pero si has investigado el asunto en una medida que te ha parecido razonable o práctica, y no has encontrado ningún error aparte de consideraciones como “No hay un consenso sólido entre expertos” y “Me preocupa el riesgo de engañarme o caer en la insularidad”, entonces creo que descartar la hipótesis es el tipo de cosa que esencialmente garantiza que no estarás entre las primeras personas que se den cuenta de una cuestión tremendamente importante, y actúen en consecuencia, si se presenta la oportunidad. Creo que es un sacrificio demasiado grande, en términos de renunciar a oportunidades potenciales de hacer mucho bien.

Esta es una traducción directa del artículo original, publicado bajo licencia CC BY 4.0.