El altruismo eficaz en la era de la IAG

Esta publicación se basa en un memorándum que escribí para el Meta Coordination Forum de este año. Véase también el reciente artículo de Arden Koehler, que toca muchos puntos similares.

Resumen

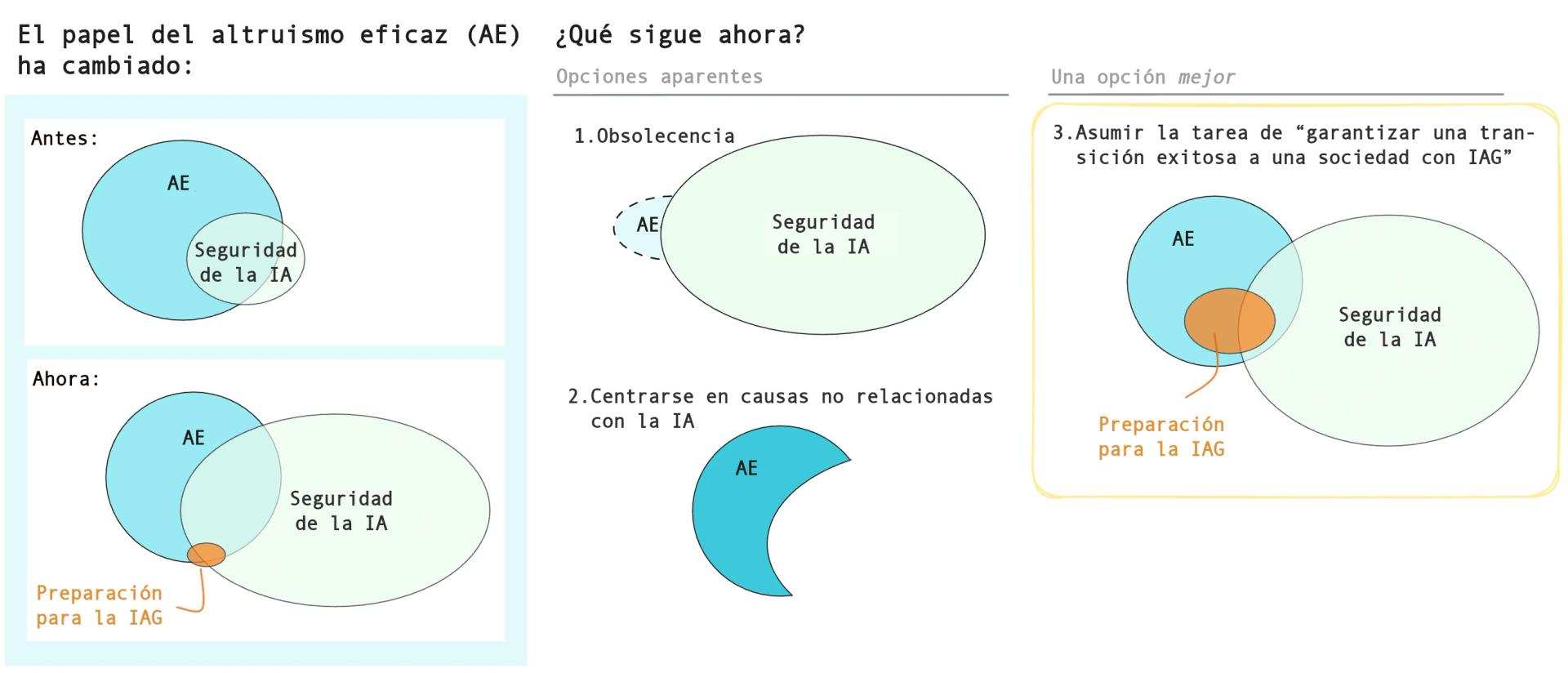

El movimiento del altruismo eficaz se encuentra en una encrucijada. Ante el rapidísimo progreso de la IA y el auge del movimiento por la seguridad de la IA, algunos ven el altruismo eficaz como un movimiento que ya es historia, destinado a desaparecer; otros piensan que deberíamos volver a centrarnos mucho más en áreas de trabajo “clásicas” como la salud global y el bienestar animal.

Defiendo una tercera vía: el altruismo eficaz debería asumir la misión de garantizar una transición exitosa a una sociedad con IAG, ampliando significativamente el alcance de nuestra área de trabajo más allá de la tradicional seguridad de la IA. Esto significa trabajar en áreas desatendidas como el bienestar, el carácter y la persuasión de la IA, la disrupción epistémica, la concentración del poder humano, la gobernanza del espacio, entre otras (sin dejar de trabajar en la salud global, el bienestar animal, la seguridad de la IA y el riesgo biológico).

Estas áreas de trabajo adicionales son extremadamente importantes y están desatendidas, y se benefician particularmente de una mentalidad alineada con el altruismo eficaz (búsqueda de la verdad, sensibilidad al alcance, disposición a cambiar de opinión rápidamente). Creo que la participación de más gente en estas otras áreas constituiría uno de los mayores éxitos para el desarrollo del movimiento del altruismo eficaz en este momento; en general, sería algo más valioso que el trabajo marginal de seguridad técnica o el de gobernanza relacionado con la seguridad. Si podemos llevarlo a cabo, esto representa una oportunidad de impacto potencialmente enorme para el movimiento del altruismo eficaz.

Recientemente, se ha puesto un mayor énfasis en un altruismo eficaz que “prioriza los principios”, lo que me parece muy bien. Pero me preocupa que, en la práctica, este enfoque pueda convertirse en una excusa para anclarse en las áreas de trabajo ya existentes, en lugar de una invitación a averiguar en qué otras áreas deberíamos centrarnos. Un enfoque basado en principios significa estar genuinamente dispuesto a cambiar de dirección a la luz de nueva evidencia; si el mundo ha cambiado espectacularmente, es de esperar que nuestras prioridades cambien también.

Esta tercera vía requerirá mucha agilidad intelectual y voluntad para cambiar de opinión. Después de FTX, gran parte del altruismo eficaz adoptó una “mentalidad orientada a las relaciones públicas” que, en mi opinión, ha perdurado y es contraproducente. El altruismo eficaz es intrínsecamente controvertido porque decimos cosas que no son populares y, en vista los acontecimientos recientes, seremos controvertidos de todos modos. Esto es liberador: podemos centrarnos en presentar argumentos que consideramos verdaderos e importantes, con valentía y honestidad, en lugar de limitarnos con una cautela excesiva.

Tres futuros posibles para el movimiento del altruismo eficaz

El progreso de la IA ha avanzado muy rápido, mucho más rápido de lo que la mayoría de la gente preveía.a La seguridad de la IA se ha convertido en un campo por derecho propio, con su propio impulso y con un conjunto independiente de instituciones. Puede dar la sensación de que, en cierto modo, este campo está devorando al altruismo eficaz: por ejemplo, en los campus universitarios, los grupos de seguridad de la IA suelen desplazar a los grupos de altruismo eficaz.

He notado que la gente ha adoptado un par de actitudes distintas frente al altruismo eficaz.:

- (1) El altruismo eficaz es un movimiento del pasado, destinado a marchitarse y desaparecer, y eso está bien.b

- (2) El altruismo eficaz debería volver a sus ideas fundamentales y originales, y apostar a doble o nada: la salud y el desarrollo globales, el bienestar animal y la donación eficaz.

Recibo mucha energía de tipo (1) de, por ejemplo, la oficina de Constellation y otras personas muy involucradas en la seguridad y la gobernanza de la IA. He recibido energía de tipo (2) de una manera más difusa de algunas conversaciones que he tenido y de debates en Internet; a veces me parece que el enfoque de “priorizar los principios” del altruismo eficaz (con el que estoy totalmente de acuerdo) puede utilizarse en la práctica como excusa para una actitud de “promover la combinación clásica de áreas de trabajo”.

Creo que el enfoque correcto es una tercera vía:c

- (3) El altruismo eficaz debería asumir —e integrar en su identidad general— la misión de garantizar una transición exitosa a una sociedad con IAG, convirtiéndola en uno de sus principales objetivos (aunque esté lejos de ser el único). Esto significa abarcar una serie de áreas de trabajo que vaya más allá de lo que normalmente se entiende por “seguridad de la IA”.

Para ser más preciso y concreto, me refiero a algo así:

- En cuanto al contenido de los planes de estudios, tal vez el 30 % o más debería tratar sobre áreas de trabajo más allá de la seguridad de la IA, el riesgo biológico, el bienestar animal o la salud global. (Más adelante detallaré cuáles son).

- Y gran parte del contenido debería versar sobre los valores y hábitos epistémicos que necesitaremos para navegar en un mundo que cambia muy rápidamente.

- En cuanto al debate público en línea relacionado con el altruismo eficaz, tal vez un 50 % debería centrarse en que la transición a una sociedad con IAG sea exitosa.

- Este porcentaje es mayor que el del contenido de los planes de estudios porque las ideas sobre la “preparación para la IAG” son, en general, más novedosas e interesantes que otros contenidos, y porque los contenidos relacionados con la IA suscitan ahora de forma orgánica mucho más interés que otras áreas.

- En cuanto a lo que hace la gente, quizás el 15 % (por ahora, pero ampliaría la escala hasta el 30 % o más con el tiempo) trabajaría principalmente en áreas de trabajo distintas a las “clásicas”, y una proporción mayor (el 50 % o más) lo tendría en mente como algo a lo que podrían dedicarse en unos años.

- Creo que uno de los mayores éxitos del desarrollo del movimiento del altruismo eficaz sería lograr que las personas se dedicaran a estas otras áreas; porque, en general, son más valiosas que el trabajo marginal en áreas como la seguridad técnica o la gobernanza de la seguridad.

- Si alguien realmente puede centrarse en un área totalmente desatendida, como los golpes de Estado por medio de la IA o los derechos de la IA, y hacerla más concreta y tratable, es probable que sea la mejor manera de tener un gran impacto.

En términos más generales, me gusta pensar en la situación de esta manera:

- Los pensadores de la Ilustración tuvieron un impacto inmensamente positivo en el mundo al contribuir a establecer el marco social, cultural e institucional de la Era Moderna.

- El altruismo eficaz podría verse a sí mismo como un contribuyente a una segunda Ilustración, centrándose en cuál debería ser el marco social, cultural e institucional para la era de la IAG, y ayudando a que la transición a esa sociedad ocurra del mejor modo posible.

Creo que la tercera vía es el enfoque correcto, por dos razones de peso:

- Creo que, en conjunto, las áreas de trabajo relacionadas con la IAG distintas a la alineación técnica y el riesgo biológico son tan importantes o incluso más que estos últimos, y que hay áreas muy desatendidas en este ámbito. El altruismo eficaz puede ayudar a llenar esos vacíos.

- Actualmente, el movimiento del altruismo eficaz se siente intelectualmente a la deriva, y este enfoque podría ser restaurador.

Una tercera posible razón es la siguiente:

- Incluso si solo se considera la seguridad de la IA, los altruistas eficaces son mucho más valiosos que los investigadores de alineación técnica ajenos a la comunidad.

Las abordaré una por una.

Razón n.º 1: Áreas de trabajo desatendidas

Actualmente, estas son las principales áreas de trabajo del altruismo eficaz:

- salud y desarrollo globales

- cría intensiva de animales

- seguridad de la IA

- riesgo biológico

- “meta”

En el enfoque de la “tercera vía”, que asume la misión de lograr que la transición a una sociedad con IAG sea exitosa, el menú podría ser más parecido al siguiente (aunque cabe señalar que esta enumeración es más ilustrativa que exhaustiva, no sigue ningún orden de prioridad y, en la práctica, no todos sus elementos tendrían el mismo pesod):

- salud y desarrollo globales

- cría intensiva de animales

- seguridad de la IA

- carácter de la IAe

- bienestar de las IA / mentes digitales

- derechos económicos y políticos de las IA

- persuasión con IA y disrupción epistémica

- IA para mejorar el razonamiento, la toma de decisiones y la coordinación

- riesgo de golpes de Estado perpetrados por humanos (habilitados por IA)

- salvaguarda de la democracia

- pérdida gradual de poder

- riesgo biológico

- gobernanza del espacio

- riesgos S

- macroestrategia

- “meta”

Creo que el movimiento del altruismo eficaz tendría un mayor impacto si las personas y el dinero estuvieran más repartidos entre estas áreas de trabajo de lo que lo están en la actualidad.

Expongo los argumentos básicos sobre la importancia de algunas de estas áreas, y explico con más detalle qué son, en Preparing for the intelligence explosion (véase especialmente la sección 6) y la serie Better Futures (véase especialmente el último ensayo).f El punto clave es que hay mucho por hacer para que la transición a un mundo con IAG sea exitosa; y gran parte de este trabajo no queda cubierto de forma natural por la seguridad de la IA y la bioseguridad.

Estas áreas están inusualmente desatendidas. La cantera de profesionales de la seguridad de la IA es mucho más sólida que la de estas otras áreas, gracias al programa MATS y otras becas; la cantera para muchas de estas otras áreas es casi inexistente. Y los incentivos habituales para dedicarse a la investigación técnica en seguridad de la IA (en el caso de algunos empleadores, al menos) son muy atractivos: participaciones en la empresa, un salario inicial del orden de 1 millón de dólares al año, un puesto emocionante y de alto estatus, en medio de toda la acción, y trabajar con otras personas inteligentes. Compárese esto con las campañas públicas, por ejemplo, en las que se gana mucho menos y se recibe mucho más odio.g

Estas otras áreas de trabajo también son inusualmente afines al altruismo eficaz, en el sentido de que se benefician especialmente de la mentalidad del altruismo eficaz (es decir, seriedad ética, búsqueda intensa de la verdad, alto grado de desacoplamiento, sensibilidad al alcance, cosmopolitismo fuerte, ambición y disposición a tomar acciones personales costosas).

Si el progreso de la IA continúa como espero, en los próximos diez años el mundo cambiará radicalmente como resultado de las nuevas capacidades de la IA, las nuevas tecnologías y las respuestas de la sociedad a esos cambios. También aprenderemos muchísimo más del progreso intelectual impulsado por la IA. Para hacer el mayor bien posible, la gente deberá ser extremadamente ágil y estar dispuesta a cambiar de opinión, algo que no suele ser habitual en la mayoría de las personas.

La principal advertencia, en mi opinión, es que, por el momento, estas otras áreas tienen mucha menos capacidad de absorción que la seguridad y la gobernanza de la IA: aún no existe un ecosistema próspero de organizaciones y becas, etc., que facilite el trabajo en estas áreas. Eso significa que preveo que habrá un período durante el cual: (i) haya mucho debate sobre estas cuestiones; (ii) algunas personas trabajen en la creación del ecosistema necesario o en la investigación necesaria para determinar cuáles son los caminos más viables; pero (iii) la mayoría de las personas elijan otras carreras profesionales, con vistas a dar el salto cuando el área esté más madura. Esta situación me recuerda mucho el riesgo de toma de poder por parte de la IA o al riesgo biológico alrededor de 2014.

Razón n.º 2: En la actualidad, el altruismo eficaz está intelectualmente a la deriva

Actualmente, el ecosistema del altruismo eficaz en Internet no se siente como un lugar lleno de ideas nuevas y emocionantes, de manera que resulte atractivo para la gente inteligente y ambiciosa:

- El foro es bastante decepcionante hoy en día. Para alguien que escribe una entrada de blog y quiere una buena interacción intelectual, LessWrong, que tiene sus propios problemas, es una opción mucho más sólida.

- Hay poco debate público sobre el altruismo eficaz; la sensación que se tiene es que la mayor parte del núcleo intelectual lo ha “abandonado” y ya lo trata como un movimiento “del pasado”. (Desde mi punto de vista, la mayor parte del debate en Internet se centra en personas como Bentham’s Bulldog y Richard Chappell, aunque solo sea porque son de las pocas personas que realmente participan).

Las cosas no son desastrosas ni irrecuperables, y todavía hay mucho potencial. (Por ejemplo, me pareció que EAG Londres fue vibrante y emocionante, y en general las reuniones presenciales siguen siendo estupendas). Pero creo que estamos lejos de donde podríamos estar.

Me parece una ventaja muy afortunada que estas otras áreas de trabajo sean tan intelectualmente fértiles; hay muchas preguntas sin respuesta y muchas disyuntivas complejas con las que lidiar. Un movimiento de altruismo eficaz que se involucrara mucho más en estas áreas tendría, por su naturaleza, una intensa vitalidad intelectual.

También me parece que hay muchísimas oportunidades al alcance de la mano en esta área. Por un lado, ya se está realizando una gran cantidad de análisis con sabor a altruismo eficaz, por parte de altruistas eficaces o de personas afines al movimiento, solo que la mayor parte tiene lugar en persona, en canales privados de Slack o en documentos de Google. Y cuando he compartido el contenido de esta publicación con veteranos del altruismo eficaz que ahora se centran en la IA, los comentarios que he recibido reflejan un intenso amor por el movimiento y un gran interés (en igualdad de condiciones) por hacer que el altruismo eficaz vuelva a ser grande; es solo que están muy ocupados y no les resulta evidente qué podrían hacer.

Creo que es probable que esta sea una situación en la que podríamos acabar en múltiples equilibrios. Si el altruismo eficaz en línea no parece intelectualmente vibrante, entonces no es un lugar atractivo en el cual participar intelectualmente; si parece vibrante, entonces sí lo es. (LessWrong ya ha vivido esta dinámica: cayó en un relativo declive antes de que LessWrong 2.0 lo relanzara como una comunidad intelectual activa).

Razón n.º 3: Los beneficios de la mentalidad del altruismo eficaz para la seguridad de la IA y el riesgo biológico

Esas son mis principales razones para querer que el altruismo eficaz tome la tercera vía. Pero hay un argumento adicional que otros me han recalcado: incluso solo para la seguridad de la IA o la reducción del riesgo biológico, la gente del altruismo eficaz tiende a tener un impacto mucho mayor que la ajena al movimiento.

Desgraciadamente, muchos de estos ejemplos son delicados y no he obtenido permiso para hablar de ellos, así que, en su lugar, citaré a Caleb Parikh, quien nos da una idea al respecto:

Algunos “influencers dedicados a que la IAG tenga un impacto benéfico” que han comentado o publicado en el EA Forum y que, en mi opinión, son como mínimo afines al movimiento, incluyen a Rohin Shah, Neel Nanda, Buck Shlegeris, Ryan Greenblatt, Evan Hubinger, Oliver Habryka, Beth Barnes, Jaime Sevilla, Adam Gleave, Eliezer Yudkowsky, Davidad, Ajeya Cotra, Holden Karnofsky… La mayoría de estas personas trabajan en seguridad técnica, pero creo que lo mismo puede decirse, en términos generales, de la gobernanza de la IA y otras áreas dedicadas a “lograr que el impacto de la inteligencia artificial general sea benéfico”.

Esto no es una coincidencia. El trabajo más valioso suele provenir de una comprensión profunda del panorama general, de ver algo muy importante que casi nadie está haciendo (por ejemplo, el control o la seguridad de la información) y dedicarse a ello. A veces, implica tomarse en serio acciones personalmente difíciles (por ejemplo, Daniel Kokotajlo renunció a una gran parte de la fortuna de su familia para poder hablar libremente).

Buck Shlegeris también me ha recalcado la importancia de tener una base intelectual común con otras personas dedicadas a la seguridad, para poder colaborar bien. Ryan Greenblatt da más razones a favor del desarrollo de la comunidad largoplacista aquí.

Esto no es una idiosincrasia particular de Will

Si existe una probabilidad muy alta de una toma de poder por parte de la IA (¡referencia obligatoria!), entonces mis dos primeros argumentos, al menos, pueden parecer muy débiles porque, en esencia, lo único que importa es reducir ese riesgo. Y es cierto que tengo un interés inusual en las áreas de trabajo relacionadas con la preparación para la IAG que no impliquen una toma de poder, razón por la cual estoy invirtiendo tiempo en escribir esto.

Pero el carácter general de este artículo no corresponde a una idiosincrasia de Will. He hablado con varias personas cuya estimación del riesgo de toma de poder por parte de la IA es mucho mayor que la mía y que están de acuerdo (en mayor o menor medida) con la importancia de las áreas de trabajo distintas de la desalineación y la bioseguridad, y comprenden que estas otras áreas son de particular importancia para el altruismo eficaz.

Si esto es cierto, ¿por qué no hay más gente alzando la voz al respecto? El problema es que, en la actualidad, muy pocas personas se centran realmente en la priorización de causas, en el sentido de tratar de averiguar en qué nuevas áreas deberíamos trabajar. Hay mucho por hacer y, como es comprensible, la gente está absorta trabajando en desafíos de nivel objeto.

Cuestiones relacionadas

Antes de pasar a qué hacer en concreto, comentaré brevemente tres cuestiones relacionadas, ya que creo que afectan al camino correcto a seguir.

Altruismo eficaz que prioriza los principios

Últimamente se ha hecho mucho hincapié en el altruismo eficaz que “prioriza los principios”, y estoy totalmente de acuerdo con ese enfoque. Pero esto significa cambiar de opinión sobre qué hacer, a la luz de nueva evidencia y argumentos, y a medida que llega nueva información sobre el mundo. Me preocupa que, en la práctica, dicho enfoque pueda utilizarse como pretexto para seguir con “las mismas áreas de trabajo de siempre”.h

Creo que la gente puede confundirse al pensar en la “IA” como un área de trabajo, en lugar de pensar en un determinado conjunto de predicciones sobre el mundo que tienen implicaciones para la mayoría de las cosas que podrían importarle. Incluso en las áreas de trabajo “clásicas” (p. ej., el desarrollo global), hay un potencial enorme en tomarse en serio la próxima transformación impulsada por la IA; por ejemplo, pensando en cómo se puede estructurar la transición para que beneficie en la medida de lo posible a los más pobres del mundo.

He oído a gente decir que he cambiado mi enfoque del altruismo eficaz a la IA. Pero creo que sería un gran error pensar que enfocarse en la IA es distinto a enfocarse en el altruismo eficaz. i Desde mi punto de vista, no he abandonado en absoluto mi enfoque en el altruismo eficaz. Simplemente estoy haciendo lo que los principios del altruismo eficaz sugieren que haga: a la luz de un mundo en rápida evolución, averiguar cuáles son las máximas prioridades, dónde puedo aportar más valor y centrarme en esas áreas.

El cultivo frente al crecimiento del altruismo eficaz

Desde una fría perspectiva economicista, se puede pensar en la comunidad del altruismo eficaz como una máquina para convertir el dinero y el tiempo en bien:j

Desde hace uno o dos años, se ha prestado mucha atención a aumentar los recursos. Creo que esto fue importante, sobre todo para recuperar el impulso, y me alegro de que ese esfuerzo haya tenido bastante éxito. Sigo pensando que el crecimiento del altruismo eficaz es extremadamente valioso y que alguna organización (por ejemplo, Giving What We Can) debería centrarse de lleno en el crecimiento.

Pero en este momento creo que es aún más valioso, en el margen actual, intentar mejorar la capacidad del altruismo eficaz para convertir esos recursos en valor; lo que en sentido amplio llamaré la cultura del altruismo eficaz. A veces a esto se le llama “dirigir”, pero creo que es una metáfora errónea: la idea de intentar apuntar hacia un destino muy concreto. Prefiero la analogía del cultivo, como cultivar una planta y tratar de asegurarse de que esté sana.

Hay varias razones por las que creo que, en el margen actual, es más importante cultivar la cultura del altruismo eficaz que aumentar los recursos:

- Si los plazos de la inteligencia artificial son más cortos, hay menos tiempo para que el crecimiento dé frutos. La recaudación de fondos y la captación de talento suelen llevar años, mientras que las mejoras culturales (como la reasignación del trabajo) pueden ser más rápidas.

- Los recursos futuros esperados han aumentado mucho recientemente y, a medida que aumenta la escala de los recursos, la importancia de mejorar el uso que se les da aumenta en relación con las ganancias que podrían obtenerse de aumentarlos aún más.

- Dinero: como resultado del aumento de las valoraciones de las empresas de IA, cientos de personas tendrán cantidades muy importantes para donar; el total de las nuevas donaciones esperadas es de miles de millones de dólares. Y si la inteligencia artificial transformadora realmente llega en los próximos diez años, el valor real de las acciones de las empresas de IA será mucho mayor todavía, por ejemplo, más de 10 veces superior.

- Mano de obra: aquí el cuello de botella es mayor, por ahora. Pero, impulsados por el auge del interés en la IA, MATS y otros programas de formación están creciendo a un ritmo excepcional. El propio movimiento del altruismo eficaz sigue creciendo. Y cada vez más podremos pagar por “mano de obra de IA”: una vez que la IA pueda sustituir alguna función, una organización podrá contratar tanto trabajo de IA como pueda pagar para cubrir esa función, sin necesidad de realizar una ronda de contrataciones y sin que disminuya la calidad de su desempeño a medida que se amplíe. Una vez que nos acerquemos a la verdadera IAG, el dinero y el trabajo se volverán mucho más sustituibles.

- Por otro lado, veo un cuello de botella aún mayor a la hora de saber cómo utilizar mejor esos recursos.

- Como mencioné anteriormente, si se produce una explosión de inteligencia, incluso una lenta o atenuada, habrá (i) muchos cambios en el mundo, que ocurrirán muy rápidamente; (ii) una gran cantidad de información, ideas y argumentos nuevos producidos por la IA en un breve espacio de tiempo. Eso significa que necesitamos una intensa agilidad intelectual. Mi fuerte expectativa por defecto es que la gente no cambiará su visión estratégica ni cambiará lo que está haciendo con la suficiente rapidez. Podemos intentar crear una cultura que esté preparada para esto.

- En mi opinión, el cultivo parece estar más desatendido en este momento, y preveo que esta desatención continuará. Es tentador centrarse en aumentar los recursos porque es más fácil crear métricas y dar seguimiento a los avances. En el caso del cultivo, las métricas no encajan tan bien: tener un conjunto de métricas no ayuda mucho a cultivar una planta. En cambio, la actitud correcta consiste más bien en prestar atención a los problemas cualitativos que hay y solucionarlos.

- Si la cultura cambiara de la forma que sugiero, creo que eso también sería orgánicamente bueno para el crecimiento.

Mentalidad orientada a las relaciones públicas

Tras el caso FTX, creo que el núcleo del altruismo eficaz adoptó una “mentalidad orientada a las relaciones públicas” que (i) ha sido un fracaso en sus propios términos y (ii) corroe el alma del movimiento.

Por “mentalidad de orientada a las relaciones públicas” me refiero a pensar en las comunicaciones desde la perspectiva de “¿qué es bueno para la marca del altruismo eficaz?”, en lugar de centrarse en preguntas como “¿qué ideas son verdaderas, interesantes, importantes, infravaloradas y cómo podemos difundirlas?”.k

Entiendo esto como una reacción inmediata tras el colapso de FTX: fue un momento extremadamente difícil, y no pretendo saber cuáles fueron las decisiones correctas en ese período. Pero me parece que la mentalidad centrada en las relaciones públicas ha perdurado.

Creo que esta mentalidad ha sido un fracaso en sus propios términos porque… bueno, se ha hablado mucho de mejorar la marca del altruismo eficaz en los últimos dos años, y ¿qué hemos conseguido? No quiero ser duro, pero creo que el principal efecto ha sido el debilitamiento del discurso del altruismo eficaz en Internet, lo que ha provocado que más gente crea que se trata de un movimiento anclado en el pasado.

Esto también coincide con mi perspectiva tras interactuar con “expertos en relaciones públicas”, quienes, en mi opinión, generalmente aportan poco, pero en efecto le dan a la comunicación un tono más publicitario, de una forma que genera rechazo en casi todo el mundo. Creo que el enfoque estándar de las relaciones públicas puede funcionar si eres una megacorporación o un político, pero nosotros no somos ninguna de esas cosas.

Y creo que esta mentalidad corroe el alma del altruismo eficaz porque, en cuanto dejas de centrarte rigurosamente en averiguar lo que es verdad, es casi seguro que adoptarás creencias equivocadas y te centrarás en las cosas equivocadas, con lo que perderás la mayor parte del impacto. Dadas las distribuciones de cola gruesa del impacto, equivocar un poco el foco puede significar que el bien que hagas sea 10 veces menor del que podrías haber hecho. Peor aún, es fácil que acabes teniendo un efecto negativo en lugar de positivo.

Y esto se vuelve particularmente cierto en la era de la IAG. Una vez más, cabe esperar enormes cambios e ideas intelectuales impulsadas por la IA (y propaganda impulsada por la IA); sin un enfoque intenso en entender cómo funcionan las cosas, nos perderemos los cambios o las ideas que deberían hacernos cambiar de opinión, o no estaremos dispuestos a entrar en áreas fuera de la ventana de Overton actual.

He aquí una perspectiva diferente:

- El altruismo eficaz es, intrínsecamente, un movimiento controvertido, porque dice cosas que no son populares (carece de valor promover ideas que cuentan con el respaldo universal, ¡ya que no cambiarán la opinión de nadie!) y porque su compromiso de creer realmente en la verdad significa que muchas veces entrará en conflicto con la ideología intelectual dominante del momento.

- En el pasado, existía la esperanza de que, con una gestión cuidadosa de la marca, podríamos agradarle a casi todo el mundo.

- Dados los acontecimientos de los últimos años (no solo me refiero a FTX, sino también a la reacción de la izquierda contra la asociación con multimillonarios, la de la derecha contra la ley SB 1047 y la del sector tecnológico contra el despido de Sam Altman), y dada la naturaleza intrínsecamente negativa y polarizante de los medios de comunicación modernos, ese tren ya ha partido.

- Pero esto es un hecho liberador. Significa que no necesitamos limitarnos por una mentalidad orientada a las relaciones públicas: seremos controvertidos hagamos lo que hagamos, por lo que los costos de una controversia adicional son mucho menores. En cambio, podemos centrarnos simplemente en argumentar sobre las cosas que creemos que son ciertas e importantes. ¡Piensa en Peter Singer! También creo que el cambio de actitud es real y mitiga gran parte de las posibles desventajas de la controversia.

Lo que no estoy diciendo

En borradores anteriores, descubrí que algunas personas me malinterpretaban, atribuyéndome una postura más extrema de la que realmente tengo. Por ello, a continuación presento una serie de aclaraciones rápidas (que puedes omitir si lo deseas):

¿Estás diciendo que deberíamos apostarlo todo a la preparación para la IAG?

¡No! Sigo pensando que cada uno debería averiguar por sí mismo dónde cree que tendrá el mayor impacto, y probablemente mucha gente no estará de acuerdo conmigo, y está bien.

También existe una posibilidad razonable de que no alcancemos una IA superior a la inteligencia humana en los próximos diez años, incluso después de que la fracción de la economía dedicada a la IA haya aumentado tanto como sea factible. Si es así, la probabilidad anual de alcanzar una IA superior a la humana disminuirá mucho (porque no estamos obteniendo el progreso inusualmente rápido derivado del aumento de la inversión), y los plazos probablemente se alargarían mucho. El movimiento de altruismo eficaz ideal es robusto ante este escenario, e incluso en mi propio caso pienso en mi enfoque actual como algo para los próximos cinco años, después de los cuales reevaluaré la situación dependiendo del estado del mundo.

¿No deberíamos más bien ampliar los grupos locales de seguridad de la IA (etc.) para que incluyan estas otras áreas?

Sí, ¡eso también!

¿No son cortos los plazos? ¿Y no rinde frutos todo esto solo en mundos con plazos largos?

Creo que es cierto que estas cosas son menos provechosas en mundos con plazos muy cortos (p. ej., de 3 años). Sin embargo, siguen siendo beneficiosas hasta cierto punto, y lo son comparativamente más en mundos con plazos más largos y despegues más lentos, y estos también deberían importarnos mucho.

Pero ¿no son los mundos de plazos muy cortos los de mayor efecto multiplicador?

Esto no me parece nada obvio, por algunas razones:

- Los plazos largos son de gran impacto porque se gana más tiempo para que el crecimiento exponencial del movimiento cobre impulso.

- En el futuro sabremos más y podremos pensar mejor, lo que nos permitirá tomar mejores decisiones. (Pero la ventaja se mantiene porque las diferencias de valores persisten).

- Por el contrario, los plazos muy cortos serán especialmente caóticos y estaremos volando a ciegas, por lo que será más difícil mejorar el curso de los acontecimientos.

- Dado que los mundos con plazos cortos son probablemente más caóticos y hay más posibilidades de cometer errores graves, creo que el valor esperado del futuro, en caso de que se logre mitigar el riesgo existencial, es menor en los mundos con plazos cortos que en los de plazos más largos.

¿Es el altruismo eficaz realmente el movimiento adecuado para estas áreas?

No es el movimiento ideal (es decir, no es lo que diseñaríamos desde cero), pero es lo más cercano que tenemos, y creo que la idea de crear un movimiento totalmente nuevo es menos prometedora que la evolución del propio altruismo eficaz.

¿Estás diciendo que el altruismo eficaz debería convertirse en un club intelectual? ¡¿Y qué hay de construir cosas?!

¡En absoluto! ¡Construyamos también!

¿Estás diciendo que el altruismo eficaz debería dejar de centrarse por completo en el crecimiento?

¡No! Es más bien que en este momento se le está prestando mucha atención. Eso es estupendo. Pero parece que casi no se presta atención al cultivo, a pesar de que parece especialmente importante ahora mismo, y es una lástima.

¿Y si no me convence el largoplacismo?

Dada la rapidez de la transición y la escala de la transformación social y económica que se producirá, de hecho, creo que el largoplacismo no es tan determinante, al menos siempre que se tenga una preocupación razonable por las generaciones futuras.

Pero incluso si eso significa que no te interesan estas áreas de trabajo, ¡no pasa nada! Creo que el altruismo eficaz debería abarcar muchas áreas de trabajo diferentes, al igual que una democracia sana y funcional tiene personas con opiniones muy diversas: debes averiguar qué visión del mundo te convence y actuar en consecuencia.

¿Qué hacer?

Reconozco que he dedicado más tiempo a pensar en los problemas que señalo y en el camino general a seguir que en soluciones concretas, por lo que no pretendo tener todas las respuestas. También me falta mucho contexto de lo que pasa en el terreno. Pero espero que al menos podamos empezar a debatir si la visión general es acertada y qué podríamos hacer concretamente para ayudar a avanzar en esta dirección. Así que, para empezar, aquí van algunas reflexiones preliminares.

Grupos locales

Tengo entendido que en los campus universitarios ha habido un cambio de los grupos de altruismo eficaz a los de seguridad de la IA. No conozco los detalles de los grupos locales, y supongo que esta opinión será más controvertida que mis otras afirmaciones, pero creo que esto probablemente sea un error, al menos en lo que respecta a su alcance.

Ya he expuesto la primera parte de mi razonamiento: los argumentos generales para centrarse en intervenciones de preparación para la IAG en ámbitos ajenos a la seguridad y el riesgo biológico.

Pero creo que estos argumentos golpean con especial dureza a los grupos universitarios, por dos razones:

- Los grupos universitarios tienen un impacto diferido, lo que favorece a estas otras áreas de trabajo.

- Supongamos que la mediana de edad en los grupos universitarios de altruismo eficaz es de 20 años.

- Y la mayoría tarda tres años en empezar a hacer contribuciones significativas a la seguridad de la IA.

- Así que, en el mejor de los casos, empezarán a contribuir en 2028.

- En mis mundos de plazos medianos, nos quedan unos pocos años de trabajo.

- Y casi ningún trabajo en mundos con plazos más cortos, donde más se necesita personal adicional en seguridad técnica de la IA.

- Por el contrario, muchas de estas otras áreas (i) siguen siendo relevantes incluso después del punto de no retorno con respecto a la alineación, y (ii) se vuelven comparativamente más importantes en mundos con plazos más largos y despegues más lentos (porque la probabilidad de una toma de poder desalineada disminuye en esos mundos).

- (Creo que este argumento aún no es totalmente concluyente, pero se reforzará en el próximo par de años).

- La universidad es una etapa inusual en la vida de una persona, en la que se está abierto a nuevas ideas grandes y peculiares y se puede dedicar tiempo a profundizar en ellas. Esto significa que los grupos universitarios ofrecen una forma inusualmente buena de crear una cantera para estas otras áreas, que a menudo se encuentran más allá de la ventana de Overton, y en las que es especialmente valioso tener una comprensión estratégica muy profunda.

El mejor contraargumento que he oído es que es un momento de auge para el desarrollo del campo de la seguridad de la IA. Los grupos de estudiantes de dicho campo pueden aprovechar esta ola, y se la perderían si en su lugar tuvieran un grupo de altruismo eficaz.

Esto me parece un contraargumento sólido, por lo que mi opinión final dependerá de los detalles del grupo local. Mi mejor suposición es que, siempre que sea posible: (i) los grupos de seguridad de la IA deberían centrarse más en estas otras áreas,l y (ii) debería haber tanto grupos de seguridad de la IA como de altruismo eficaz, con una serie de eventos compartidos sobre temas de “preparación para la IAG”.

En Internet

Estas son algunas de las cosas que podríamos hacer:

- Arengar a los veteranos del altruismo eficaz para que (i) hablen del altruismo eficaz y se involucren (al menos un poco) si tienen un pódcast, etc.; (ii) publiquen en el foro (especialmente si ya publican en LessWrong), Twitter, etc., e interactúen con las ideas del altruismo eficaz; (iii) de manera más general, reivindiquen su afiliación al movimiento.

- (¿Por qué “veteranos”? Es una expresión abreviada, pero mi idea es que, en este momento, no hay mucha interacción entre las personas que llevan mucho tiempo en el movimiento y las que son nuevas. Esto significa que la transferencia de información (y, por ejemplo, el asesoramiento sobre carreras profesionales) de las personas que más han reflexionado y están más informadas sobre las máximas prioridades actuales es más lenta de lo que podría ser; las áreas de trabajo de preparación para la IAG de las que hablo son solo un ejemplo de ello).

- Aclarar que se trata de conseguir que manifiesten abiertamente sus opiniones sobre el altruismo eficaz y temas relacionados en público, no de seguir la línea de ningún partido.

- Decirles explícitamente que lo importante es involucrarse con las ideas del altruismo eficaz, en lugar de preocuparse por la “marca”. Que simplemente escriban o digan cosas, en lugar de enredarse en metaestrategias al respecto. En todo caso, que hagan hincapié en la valentía y la honestidad, y desalienten las lamentaciones por la posible mala prensa.

- Como mínimo, estas personas deberían sentirse capaces de hacerlo, en lugar de dudar si, por ejemplo, el CEA siquiera quiere esto (que es la impresión que me da por el momento).

- Pero también creo que (i) en general ha habido una corrección excesiva en detrimento del altruismo eficaz, por lo que tiene sentido que algunas personas reviertan el rumbo; y (ii) la gente debería tener un poco de “sentido del deber cívico” al respecto.

- Creo que incluso un poco de esto por parte de los veteranos es realmente valioso. Hay una enorme diferencia entre una persona que publique dos episodios de pódcast o dos entradas de blog al año en los que trate las ideas del altruismo eficaz, o interactúe con el movimiento, y una que no publique nada.

- (Mi plan es hacer algo más de divulgación de lo que he hecho últimamente, empezando por esta publicación, para luego hacer algo como un episodio de pódcast al mes y tomar un pequeño impulso en febrero, cuando salga la edición del décimo aniversario de Doing Good Better).

- El EA Forum es muy importante para definir la cultura, y podríamos intentar convertirlo en un lugar donde los altruistas eficaces centrados en la IA se sientan más entusiasmados por publicar. Esto podría consistir simplemente en ajustar las expectativas del foro como un lugar de referencia para debatir temas relacionados con la preparación para la IAG.

- (Cuando he hablado con otras personas sobre esta “tercera vía” para el altruismo eficaz, me ha llamado la atención lo mucho que se menciona el foro. Creo que el foro, en particular, establece expectativas culturales para las personas que están inmersas en sus carreras profesionales y no asisten a eventos o conferencias de altruismo eficaz en persona, pero que siguen prestando cierta atención en línea).

- El foro podría tener, en la parte superior, una selección de publicaciones clásicas.

- Revisar y actualizar los planes de estudio básicos del altruismo eficaz, e incorporar más contenido sobre la preparación para un mundo con IAG.

- Aceptar que el altruismo eficaz es un movimiento que se ocupa en gran medida de que la transición a una sociedad con IAG sea exitosa.

- (Mi sensación es que los responsables de la comunicación del altruismo eficaz quieren restar importancia o alejarse del enfoque del movimiento en la IA. Pero esto es un error, tanto por la importancia del tema a nivel objeto, como porque se está desaprovechando una oportunidad: no se están capitalizando las ventajas que podríamos obtener de que los miembros del altruismo eficaz se hayan anticipado a la tendencia más importante de nuestra generación y cuenten con algunas de las ideas más interesantes que aportar al respecto. Y espero que la atención sobre muchas de las áreas de trabajo que he destacado crezca sustancialmente en los próximos años).

- 80 000 Horas podría tener más contenido sobre qué se puede hacer en estas áreas desatendidas, aunque ya ha avanzado significativamente en esa dirección.

Conferencias

- Invitar a los veteranos del altruismo eficaz a que asistan a más EAG. Decirles que lo consideren una oportunidad para generar un impacto (que no necesariamente verán materializarse), en lugar de algo de lo que puedan beneficiarse personalmente.

- Quizás, además de las EAG, se podrían organizar conferencias y retiros que sean más un foro de aprendizaje y exploración intelectual, y menos una feria de empleo.

- Tratar de organizar estos eventos en torno a la gente con experiencia que nos gustaría que asistiera; por ejemplo, celebrémoslos cerca de donde trabajan o averigüemos a qué tipo de actos querrían asistir.

- Se podrían organizar eventos centrados explícitamente en estas áreas más desatendidas (que podrían, por ejemplo, tener lugar justo después de los eventos centrados en la investigación).

Conclusión

El altruismo eficaz consiste en tomarse en serio la pregunta “¿cómo puedo hacer el mayor bien posible?” y seguir los argumentos y la evidencia hasta donde nos lleven. Sostengo que, si nos tomamos en serio este proyecto, los avances de los últimos años deberían provocar una evolución importante de nuestro enfoque.

Creo que sería una pena terrible y una gran pérdida de potencial que la gente llegara a ver el altruismo eficaz como poco más que un precursor del movimiento de seguridad de la IA, o si el altruismo eficaz se petrificara como un movimiento social centrado en un puñado fijo de causas. En cambio, podríamos ser un movimiento que afronta toda la gama de retos y oportunidades que traerá consigo la IA avanzada, haciéndolo con la vitalidad intelectual y la seriedad de propósito que constituyen la esencia del altruismo eficaz.

Gracias a Joe Carlsmith, Ajeya Cotra, Owen Cotton-Barratt, Max Dalton, Max Daniel, Tom Davidson, Lukas Finnveden, Ryan Greenblatt, Rose Hadshar, Oscar Howie, Kuhan Jeyapragasan, Arden Koehler, Amy Labenz, Fin Moorhouse, Toby Ord, Caleb Parikh, Zach Robinson, Abie Rohrig, Buck Shlegeris, Lizka Vaintrob y a todos en el Meta Coordination Forum.