Por qué los riesgos S son los peores riesgos existenciales y cómo prevenirlos

Este artículo está basado en las notas de una charla que di en EAG Boston 2017. Se puede acceder a la grabación de la charla aquí.

Los riesgos S son riesgos de eventos que provocan sufrimiento en cantidades significativas a escala cósmica. Por “significativas” entendemos “significativas en relación con el sufrimiento futuro esperado”. La charla estaba dirigida a un público no familiarizado con este concepto. Para profundizar en el tema, véase nuestro artículo Reducing risks of astronomical suffering: a neglected priority.

Hablaré de los riesgos de sufrimiento grave en un futuro lejano, o riesgos S. Reducir estos riesgos es el principal objetivo del Foundational Research Institute, el grupo de investigación alineado con el altruismo eficaz al que represento.

Para ilustrar en qué consisten los riesgos S, utilizaré una historia ficticia.

Imaginemos que algún día fuera posible transferir mentes humanas a entornos virtuales. Así, los seres sintientes podrán almacenarse y ejecutarse en dispositivos informáticos muy pequeños, como el aparato con forma de huevo blanco que se muestra aquí.

Detrás del dispositivo informático puede verse a Matt. El trabajo de Matt consiste en convencer a las mentes humanas transferidas de que actúen como mayordomos virtuales y controlen las casas inteligentes de sus propietarios. En este caso, la mente humana virtual Greta no está dispuesta a obedecer.

Para quebrar su voluntad, Matt acelera el paso del tiempo para Greta. Mientras Matt espera solamente unos segundos, Greta padece muchos meses de confinamiento solitario.

Afortunadamente, nada de esto sucedió realmente. De hecho, tomé esta historia y las capturas de pantalla de un episodio de la serie de televisión británica Black Mirror.

No solo no ocurrió, sino que es prácticamente seguro que no ocurrirá. Es improbable que cualquier escenario futuro que imaginemos ahora suceda precisamente de esta forma. Pero argumentaré que hay muchos escenarios posibles que son, en aspectos relevantes, como ese o incluso peores. Los llamaré riesgos S, donde “S” significa “sufrimiento”.

En primer lugar, explicaré qué son los riesgos S y cómo pueden materializarse. A continuación, hablaré de la razón por la cual los altruistas eficaces pueden querer centrarse en la prevención de los riesgos S, y de los tipos de trabajo mediante los cuales se puede lograr esto.

I. ¿Qué son los riesgos S?

Me gustaría presentar los riesgos S como una subclase de los riesgos existenciales, a menudo llamados “riesgos X”. Por lo tanto, será útil recordar el concepto de riesgo existencial. Nick Bostrom ha definido el riesgo existencial de la siguiente manera:1

Riesgo existencial: un riesgo que, de materializarse, aniquilaría la vida inteligente originada en la Tierra o reduciría su potencial de forma permanente y drástica.

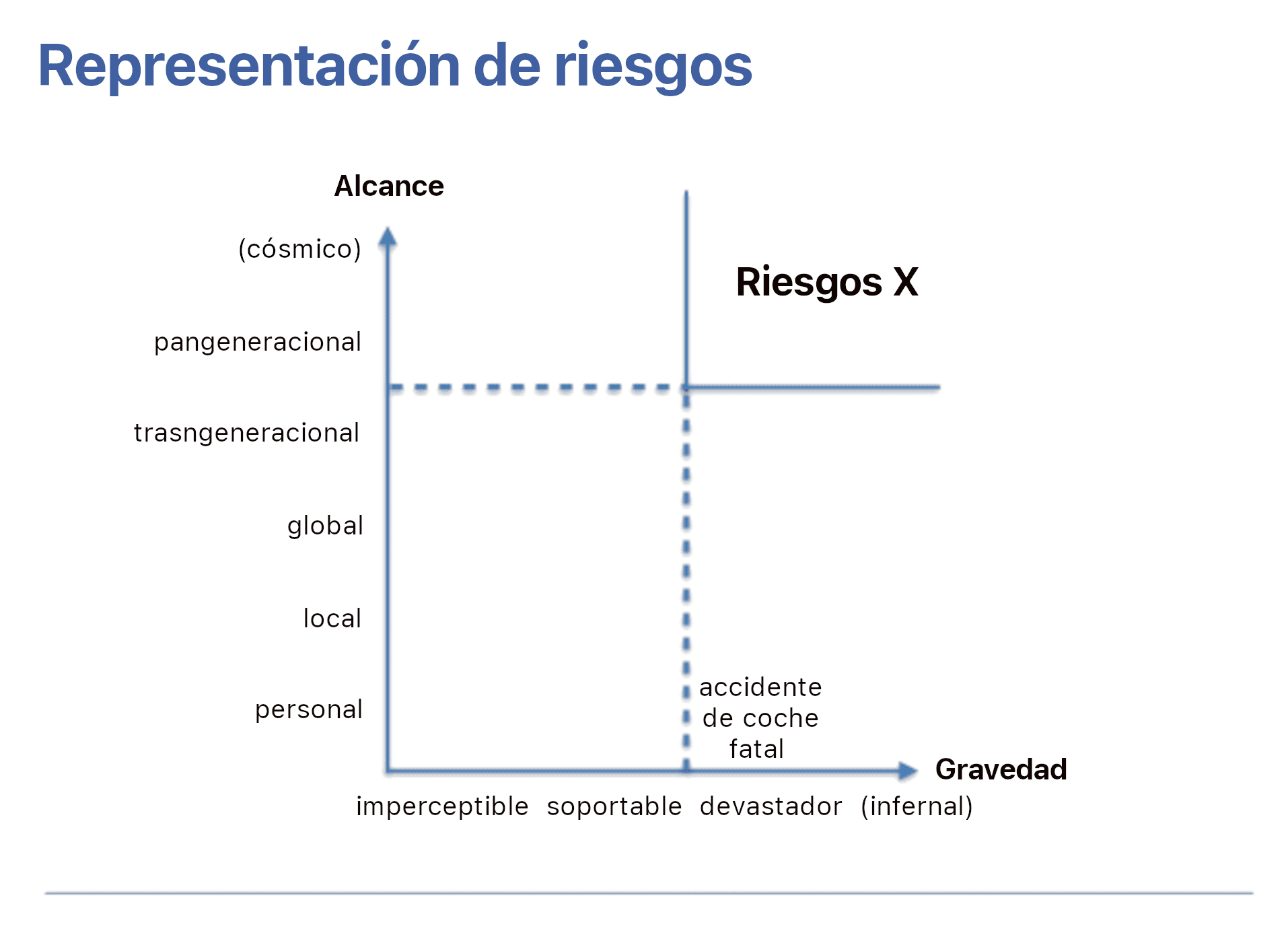

Bostrom también sugirió que una forma de entender en qué se diferencia el riesgo existencial de otros riesgos es observar dos dimensiones de riesgo. Estas dos dimensiones son su alcance y su gravedad. Podemos utilizar estas dimensiones para representar distintos tipos de riesgos en una figura bidimensional.

En el eje vertical, los riesgos se ordenan según su alcance. Es decir, nos preguntamos a cuántos individuos afectarían. ¿Sería una sola persona, todos los habitantes de alguna región, todos los habitantes de la Tierra en un momento dado, o incluso todos ellos más las generaciones futuras? En el eje horizontal, clasificamos los riesgos en función de su gravedad. Es decir, nos preguntamos cuán grave sería un resultado adverso para un individuo afectado.

Por ejemplo, un único accidente de coche mortal tendría una gravedad terminal. En ese sentido, es bastante malo. Sin embargo, en otro sentido, no es tan malo como podría haber sido, porque afecta solo a un pequeño número de personas: tiene un alcance personal y no global, ni siquiera regional. Pero también hay riesgos de mayor gravedad; por ejemplo, podría decirse que ser torturado durante el resto de tu vida, sin posibilidad de escapar, es peor que un accidente de coche mortal. O, por poner un ejemplo de la vida real, pensemos en la cría intensiva de animales. Solemos creer, por ejemplo, que la vida de los pollos en jaulas en batería es tan mala que sería mejor que no existieran. Por eso nos parece bien que la comida de esta conferencia sea mayoritariamente vegana.

Volviendo al título de mi charla, ahora puedo declarar por qué los riesgos S son los peores riesgos existenciales. Los riesgos S son los peores riesgos existenciales porque, según mi definición, tienen el mayor alcance y la mayor gravedad posibles. (Más adelante matizaré la afirmación de que los riesgos S son los peores riesgos X.) Es decir, me gustaría sugerir la siguiente definición.

Riesgo S: un riesgo que, de materializarse, provocaría un grave sufrimiento a escala cósmica, superando ampliamente todo el sufrimiento que ha existido hasta ahora en la Tierra.

Así pues, los riesgos S son aproximadamente tan graves como la cría intensiva de animales, pero con un alcance aún mayor.

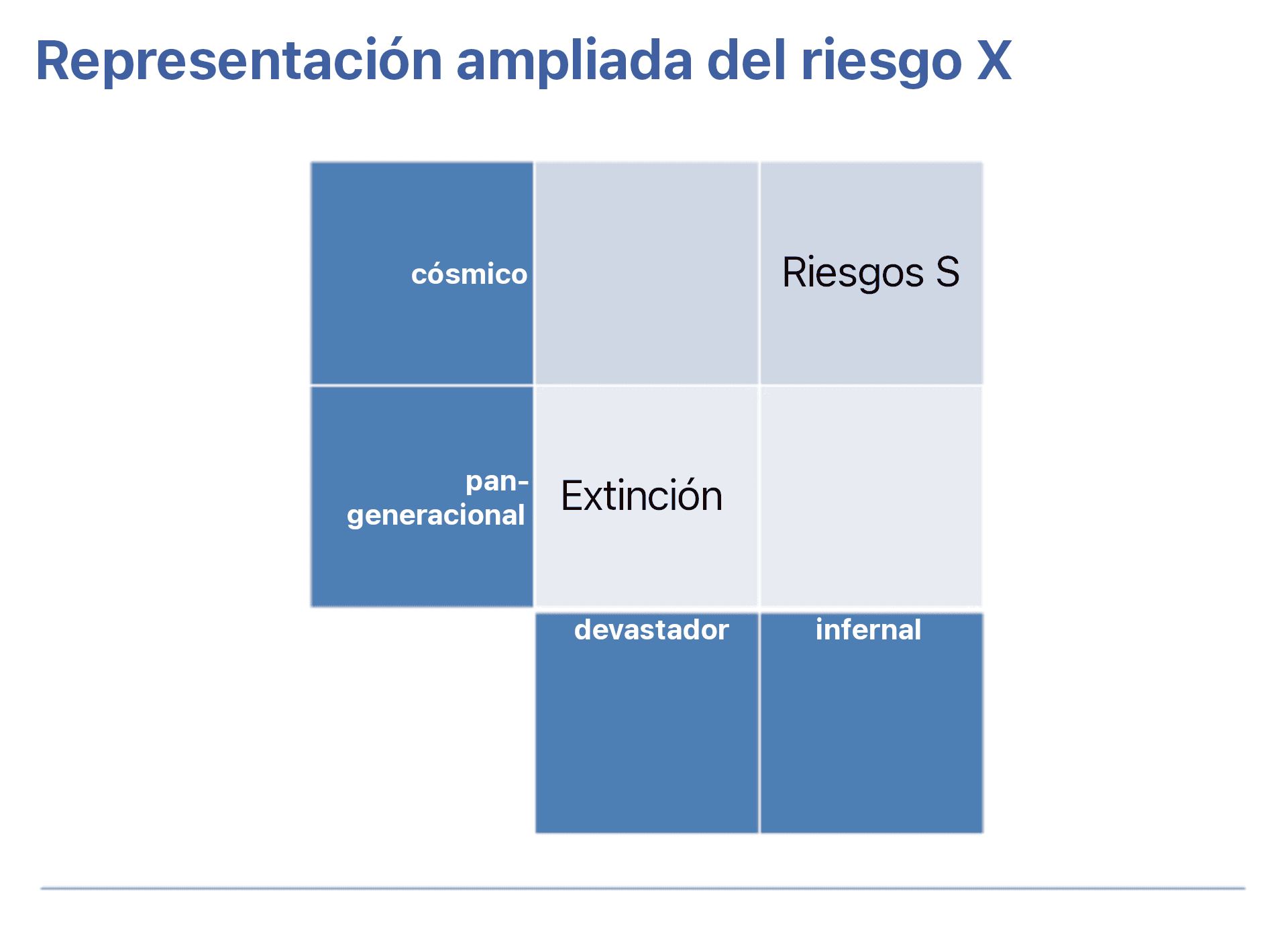

Para entender mejor esta definición, ampliemos la parte del mapa que muestra el riesgo existencial.

Una subclase de riesgos son aquellos que, por su alcance, afectarían a todas las generaciones humanas futuras y, por su gravedad, eliminarían todo lo valioso. Un ejemplo central de este tipo de riesgos devastadores y pangeneracionales son los riesgos de extinción humana.

Los riesgos de extinción son los que más atención han recibido hasta ahora. Pero, conceptualmente, los riesgos X contienen otra clase de riesgos. Se trata de riesgos de resultados aún peores que la extinción en dos aspectos. En primer lugar, en cuanto a su alcance, no solo amenazan a las generaciones futuras de seres humanos o a nuestros sucesores, sino a toda la vida sintiente de todo el universo. En segundo lugar, con respecto a su gravedad, no solo eliminan todo lo que sería valioso, sino que también vienen acompañados de mucho disvalor, es decir, características que nos gustaría evitar a toda costa. Recordemos la historia que conté al principio, pero pensemos que el confinamiento solitario de Greta se multiplica por muchos órdenes de magnitud, por ejemplo, porque afecta a una población muy grande de seres sintientes virtuales.

Detengámonos un momento. Hasta ahora, me he ocupado del concepto de riesgo S. Recapitulando, son riesgos de sufrimiento grave a escala cósmica, lo que los convierte en una subclase de riesgo existencial.

[Según lo que se entienda por “reducir su potencial” en la definición de los riesgos X, puede ser que haya riesgos S que de hecho no sean riesgos X. Esto sería cierto si pensamos que alcanzar plenamente el potencial de la vida inteligente originada en la Tierra podría suponer cantidades de sufrimiento a escala astronómica, es decir, la realización de un riesgo S. Pensemos en una cuarta parte del universo llena de sufrimiento y tres cuartas partes llenas de felicidad. Considerar que un resultado así equivale a la realización plena del potencial de la humanidad parece implicar la tesis de que el sufrimiento en cuestión se vería compensado por otras características deseables de este potencial plenamente realizado, como grandes cantidades de felicidad. Aunque todos los puntos de vista morales plausibles parecen estar de acuerdo en que evitar el sufrimiento en este escenario sería valioso, podrían discrepar en cuanto a la importancia de hacerlo. Si bien a muchas personas les parece plausible que garantizar un futuro próspero es más importante, el Foundational Research Institute está comprometido con una familia de puntos de vista diferentes, que denominamos ética centrada en el sufrimiento. (Nota: Hemos actualizado esta sección en junio de 2019.)]

A continuación, me gustaría hablar de por qué y cómo prevenir los riesgos S.

II. Riesgos S: cómo y por qué prevenirlos

Todos los sistemas de valores plausibles coinciden en que el sufrimiento, en igualdad de condiciones, es indeseable. Es decir, todo el mundo está de acuerdo en que tenemos razones para evitar el sufrimiento. Los riesgos S son riesgos de sufrimiento masivo, así que espero que estemos de acuerdo en que es bueno prevenir los riesgos S.

Sin embargo, probablemente estás aquí porque te interesa el altruismo eficaz. No quieres saber si prevenir los riesgos S es bueno, porque hay muchas cosas buenas que podrías hacer. Reconoces que hacer el bien tiene un costo de oportunidad, así que buscas hacer el mayor bien posible. ¿Hay razones para pensar que la prevención de los riesgos S supera este umbral? Es una pregunta muy compleja. Para entender hasta qué punto es compleja, primero quiero presentar un argumento aparente a favor de centrarse en la reducción del riesgo S. (No pretendo decir que alguien haya presentado un argumento semejante sobre los riesgos S o los riesgos X.) Este argumento aparente es el siguiente:

Premisa 1: Lo mejor que se puede hacer es prevenir los peores riesgos.

Premisa 2: Los riesgos S son los peores riesgos

Conclusión: Lo mejor que se puede hacer es prevenir los riesgos S

Sostengo que este argumento no es sólido. ¿Por qué?

Antes de profundizar en ello, vamos a eliminar una posible fuente de ambigüedad. Según una interpretación posible, la premisa 1 podría ser un juicio de valor. En este sentido, podría significar que, independientemente de lo que esperes que ocurra en el futuro, crees que hay una razón específica para dar prioridad a evitar los peores resultados posibles. Se podrían decir muchas cosas sobre los pros y los contras, así como sobre las implicaciones de tales puntos de vista, pero este no es el sentido de la premisa 1 al que voy a referirme. En cualquier caso, no creo que ninguna lectura puramente valorativa de la premisa 1 baste para que este argumento funcione. En términos más generales, creo que tus valores pueden darte razones sustanciales o incluso decisivas para centrarte en el riesgo S, pero no entraré en esto.

Antes bien, lo que quiero es destacar que, (casi) independientemente de tus valores, la premisa 1 es falsa. O al menos es falsa si por “los peores riesgos” entendemos aquello de lo que hemos hablado hasta ahora, es decir, lo peor en las dimensiones de alcance y gravedad.

Cuando se trata de encontrar la acción con el mayor impacto ético hay, por supuesto, criterios más relevantes que el alcance y la gravedad de un riesgo. Nos faltan la probabilidad del riesgo, la tratabilidad de su prevención y su desatención. Los riesgos S son, por definición, los peores riesgos en términos de alcance y gravedad, pero no necesariamente en términos de probabilidad, tratabilidad y desatención.

Estos criterios adicionales son claramente relevantes. Por ejemplo, si los riesgos S resultaran tener probabilidad cero, o si su reducción fuera completamente intratable, no tendría ningún sentido intentar reducirlos.

Por tanto, debemos descartar el argumento aparente. No podré responder definitivamente a la pregunta sobre las circunstancias en las que deberíamos centrarnos en el riesgo S, pero ofreceré algunas ideas preliminares sobre la probabilidad, tratabilidad y desatención de los riesgos S.

Argumentaré que los riesgos S no son mucho más improbables que el riesgo de extinción relacionado con la IA. Explicaré por qué creo que esto es cierto y, de pasada, responderé a dos objeciones.

Es posible que pienses “esto es absurdo”: ni siquiera podemos enviar humanos a Marte, ¿por qué preocuparse por el sufrimiento a escalas cósmicas? Esta fue mi reacción intuitiva inmediata cuando me encontré por primera vez con conceptos relacionados. Pero, como altruistas eficaces, debemos ser cautos a la hora de tomarnos al pie de la letra estas reacciones intuitivas del “sistema 1”. Somos conscientes de que un gran número de investigaciones psicológicas sobre “heurísticas y sesgos” sugieren que nuestras estimaciones intuitivas de probabilidad a menudo dependen de la facilidad con la que recordamos un ejemplo prototípico del acontecimiento que estamos considerando. En el caso de sucesos que no tienen precedentes en la historia, no podemos recordar ningún ejemplo prototípico, por lo que, si no tenemos cuidado, subestimamos sistemáticamente la probabilidad de que se produzcan.

Así que deberíamos examinar críticamente esta reacción intuitiva de que los riesgos S son poco probables. Si lo hacemos, debemos prestar atención a dos desarrollos tecnológicos que son al menos factibles y que podemos esperar por razones no relacionadas. Se trata de la sintiencia artificial y la IA superinteligente; esta última podría permitir muchas más capacidades tecnológicas, como la colonización del espacio.

La sintiencia artificial se refiere a la idea de que la capacidad de tener experiencia subjetiva —y, en particular, la capacidad de sufrir— no se limita a los animales biológicos. Aunque no existe un acuerdo universal al respecto, la mayoría de los puntos de vista contemporáneos en filosofía de la mente de hecho implican que la sintiencia artificial es posible en principio. Y para el caso particular de las emulaciones del cerebro, los investigadores han esbozado una hoja de ruta concreta, identificando etapas concretas e incertidumbres pendientes.

En cuanto a la IA superinteligente, no diré nada al respecto porque se trata de una tecnología que ha recibido mucha atención por parte de la comunidad del altruismo eficaz. Me limitaré a remitir a la lectura del excelente libro de Nick Bostrom sobre el tema, titulado Superinteligencia, donde se habla de los riesgos S relacionados con la sintiencia artificial y la “IA que sale mal” bajo el término “crimen mental”.

Pero si solamente vas a retener una cosa sobre la probabilidad del riesgo S, que sea la siguiente: ¡esto no es una apuesta de Pascal! En resumen, como recordarán, Pascal vivió en el siglo XVII y se preguntó si deberíamos observar los mandamientos religiosos. Uno de los argumentos que consideró fue que, por improbable que nos parezca que Dios exista, no vale la pena arriesgarse a acabar en el infierno. En otras palabras, el infierno es tan malo que uno debería dar prioridad a evitarlo, aunque pensara que el infierno es muy improbable.

Ese no es el argumento que estamos esgrimiendo con respecto al riesgo S. La apuesta de Pascal invoca una especulación basada en una colección de libros antiguos seleccionados arbitrariamente. Basándose en esto, no se puede afirmar de forma defendible que la probabilidad de un tipo de infierno sea mayor que la probabilidad de las hipótesis alternativas.

Por el contrario, la preocupación por el riesgo S se basa en nuestras mejores teorías científicas y en muchos conocimientos empíricos implícitos sobre el mundo. Consideramos toda la evidencia disponible y, a continuación, articulamos una distribución de probabilidades sobre cómo puede desarrollarse el futuro. Como predecir el futuro es tan difícil, la incertidumbre restante será bastante alta. Pero este tipo de razonamiento podría, en principio, justificar la conclusión de que el riesgo S no es despreciablemente pequeño.

De acuerdo, pero quizá se te ocurra un argumento adicional: dado que un universo lleno de mucho sufrimiento es un resultado relativamente específico, puedes pensar que es extremadamente improbable que algo así ocurra a menos que alguien o algo optimice intencionadamente ese resultado. En otras palabras, puedes pensar que los riesgos S requieren mala intención, y que esa mala intención es muy improbable.

Creo que una parte de este argumento es correcta: estoy de acuerdo en que es muy improbable que creemos una IA con el objetivo final de crear sufrimiento, o que los humanos creen intencionadamente un gran número de IA que sufran. Pero creo que la mala intención solo representa una ínfima parte de lo que debería preocuparnos, porque existen otras dos vías más verosímiles.

Por ejemplo, consideremos la posibilidad de que los primeros seres artificialmente sintientes que creemos, potencialmente en grandes cantidades, sean seres “sin voz”, es decir, incapaces de comunicarse en lenguaje escrito. Si no somos muy cuidadosos, podríamos hacerlos sufrir sin siquiera darnos cuenta.

A continuación, consideremos el ejemplo arquetípico del riesgo asociado a la IA: un maximizador de clips superinteligente. De nuevo, no se trata de que nadie piense que este escenario concreto sea muy probable. Es solo un ejemplo de una amplia clase de escenarios en los que accidentalmente creamos un poderoso sistema, similar a un agente, que persigue algún objetivo que no está alineado con nuestros valores ni es activamente malvado. La cuestión es que este maximizador de clips puede causar sufrimiento por razones instrumentales. Por ejemplo, podría llevar a cabo simulaciones sintientes para averiguar más sobre la ciencia de la producción de clips o para evaluar la probabilidad de encontrarse con alienígenas (que podrían interrumpir la producción de clips). Alternativamente, podría engendrar subprogramas “trabajadores” sintientes para los que el sufrimiento fuera un medio de guiar la acción, de forma similar a como los humanos aprenden a no tocar un plato caliente.

Una “primera generación sin voz” de IA sintientes y un maximizador de clips que crea sufrimiento por razones instrumentales son dos ejemplos de cómo puede materializarse un riesgo S, no por mala intención, sino por accidente.

En tercer lugar, los riesgos S pueden surgir como parte de un conflicto.

Para entender la importancia del tercer punto, recordemos la historia al principio de esta charla. El operador humano Matt no era malvado en el sentido de que valorara intrínsecamente el sufrimiento de Greta. Solo quería asegurarse de que Greta cumpliera las órdenes de su dueño, cualesquiera que fueran. En términos más generales, si los agentes compiten por un conjunto compartido de recursos, existe el riesgo de que adopten comportamientos estratégicos de suma negativa que provoquen sufrimiento, incluso si todos asignan disvalor al sufrimiento.

El resultado es que los riesgos de sufrimiento grave no requieren motivaciones inusuales como el sadismo o el odio. También hay mucha evidencia histórica a favor de este principio preocupante; por ejemplo, la mayoría de las guerras o la cría intensiva de animales. Ninguna de estas cosas ocurre por malas intenciones.

Dicho sea de paso, por si te lo has preguntado, la historia de Black Mirror no era un riesgo S, pero ahora podemos ver que ilustra dos puntos importantes: primero, la importancia de la sintiencia artificial y, segundo, el sufrimiento grave causado por un agente sin mala intención.

En conclusión: para preocuparnos por el riesgo S, no hace falta postular ninguna tecnología nueva ni ninguna característica cualitativamente nueva además de lo que la comunidad del riesgo asociado a la IA ya tiene en cuenta. Así que yo diría que los riesgos S no son mucho más improbables que los riesgos X relacionados con la IA. O al menos, si alguien está preocupado por el riesgo existencial relacionado con la IA, pero no por el riesgo S, la carga de la prueba recae sobre él.

Reconozco que se trata de una cuestión difícil. Sin embargo, creo que hay algunas cosas que podemos hacer hoy para reducir el riesgo S.

En primer lugar, hay cierta superposición con trabajos conocidos en el ámbito del riesgo existencial. Más concretamente, algunos trabajos sobre la seguridad técnica y la política de la IA abordan de hecho tanto los riesgos de extinción como los riesgos S. No obstante, cualquier trabajo específico sobre la seguridad de la IA puede ser mucho más relevante para un tipo de riesgo que para el otro. Por poner un ejemplo simplificado, si pudiéramos asegurar que una IA superinteligente se apagara por defecto al cabo de 1 000 años, esto no ayudaría mucho a reducir el riesgo de extinción, pero evitaría el riesgo S de larga duración. Para algunas reflexiones más serias sobre el progreso diferencial dentro de la seguridad de la IA, remito al informe técnico del Foundational Research Institute sobre seguridad de la IA centrada en el sufrimiento.

Así que la buena noticia es que ya estamos trabajando para reducir el riesgo S. Pero hay que tener en cuenta que no ocurre lo mismo con todas las iniciativas que buscan reducir el riesgo existencial; por ejemplo, construir refugios para catástrofes o trabajar para evitar que una pandemia mortal acabe con todos puede reducir la probabilidad de extinción, pero, en una primera aproximación, no cambia la trayectoria del futuro en caso de que los humanos sobrevivan.

Además del trabajo más focalizado, también hay intervenciones amplias que pueden prevenir los riesgos S de forma más indirecta. Por ejemplo, reforzar la cooperación internacional podría reducir la probabilidad de conflictos, y hemos visto que el comportamiento de suma negativa en los conflictos es una fuente potencial de riesgos S. O, en el metanivel, podemos investigar qué tipos de intervención amplia son eficaces para reducir los riesgos S. Esto último es parte de lo que estamos haciendo en el Foundational Research Institute.

Ya he hablado de las intervenciones dirigidas a reducir los riesgos S. Hay otro aspecto de la tratabilidad: ¿habrá apoyo suficiente para llevar a cabo esas intervenciones? Por ejemplo, ¿habrá financiación suficiente? Puede que nos preocupe que hablar de sufrimiento cósmico y sintiencia artificial esté más allá de lo aceptable o, en otras palabras, que los riesgos S sean demasiado extravagantes.

Creo que es una preocupación legítima, pero no creo que debamos concluir que prevenir el riesgo S sea inútil. Recordemos que hace 10 años la preocupación por los riesgos asociados a la IA superinteligente era casi universalmente ridiculizada, descartada o tergiversada como si se tratara de Terminator.

En cambio, hoy tenemos a Bill Gates promocionando un libro que habla de emulaciones de cerebro completo, maximizadores de clips y crimen mental. Es decir, la historia del campo de la seguridad de la IA demuestra que podemos conseguir un apoyo significativo para áreas de trabajo que parecen extravagantes siempre que nuestros esfuerzos estén respaldados por argumentos sólidos.

Por último, pero no por ello menos importante, ¿hasta qué punto se ha descuidado el trabajo sobre el riesgo S?

Está claro que no se ha descuidado del todo. Ya he dicho antes que la seguridad y la política de la IA pueden reducir el riesgo S, así que podría decirse que parte del trabajo de, por ejemplo, el Machine Intelligence Research Institute o del Future of Humanity Institutea está de hecho abordando el riesgo S.

Sin embargo, me parece que el riesgo S recibe mucha menos atención que el riesgo de extinción. De hecho, he visto que se equipara el riesgo existencial con el riesgo de extinción.

En cualquier caso, creo que el riesgo S recibe menos atención de la que merece. Esto es especialmente cierto en el caso de las intervenciones dirigidas específicamente a reducir el riesgo S, es decir, intervenciones que no reducirían también otras clases de riesgo existencial. Es posible que aquí haya oportunidades al alcance de la mano, ya que los trabajos existentes sobre el riesgo existencial no están optimizados para reducir el riesgo S.

Que yo sepa, el Foundational Research Institute es la única organización de la comunidad del altruismo eficaz que se centra explícitamente en reducir el riesgo S.

En resumen: tanto los juicios empíricos como los de valor son pertinentes para responder a la pregunta de si hay que centrarse en reducir el riesgo S. Desde el punto de vista empírico, las preguntas más importantes son: ¿hasta qué punto son probables los riesgos S? ¿Es fácil prevenirlos? ¿Quién más está trabajando en ello?

En cuanto a su probabilidad, los riesgos S pueden ser improbables, pero son mucho más que una mera posibilidad conceptual. Podemos ver qué tecnologías podrían causar sufrimiento grave a escala cósmica y, en general, los riesgos S no parecen mucho más improbables que los riesgos de extinción relacionados con la IA.

Las tecnologías más factibles que podrían implicar riesgo S son la sintiencia artificial y la IA superinteligente. Por tanto, en una primera aproximación, estas áreas de trabajo son mucho más relevantes para reducir el riesgo S que otras áreas asociadas al riesgo X, como la bioseguridad o el desvío de asteroides.

En segundo lugar, la reducción del riesgo S es tratable al menos en un grado mínimo. Es probable que aún no hayamos encontrado las intervenciones más eficaces en este ámbito, pero podemos señalar algunas intervenciones que reducen el riesgo S y en las que se trabaja hoy en día, como la seguridad y la política de la IA.

También hay intervenciones amplias que pueden reducir indirectamente el riesgo S, pero aún no comprendemos muy bien el panorama macroestratégico.

Por último, el riesgo S parece estar más desatendido que el riesgo de extinción. Al mismo tiempo, reducir el riesgo S es difícil y requiere de trabajo pionero. Por lo tanto, yo diría que el Foundational Research Institute ocupa un nicho importante con mucho espacio para que otros se unan.

Dicho todo esto, no espero haber convencido a todos y cada uno de ustedes de que se dediquen a reducir el riesgo S. Creo que, siendo realistas, tendremos una pluralidad de prioridades en la comunidad: algunos nos centraremos en reducir el riesgo de extinción, otros el riesgo S, y así sucesivamente.

Por lo tanto, me gustaría terminar esta charla con una visión para la comunidad que busca dar forma al futuro lejano.

Los que nos preocupamos por el futuro lejano tenemos por delante un largo camino. Pero es una tergiversación plantearlo como una elección binaria entre la extinción y la utopía.

Pero en otro sentido, la metáfora era acertada. Efectivamente, tenemos por delante un largo viaje, pero es un viaje a través de un territorio difícil de atravesar, y en el horizonte hay un continuo que va desde una tormenta infernal hasta el más hermoso día de verano. El interés por dar forma al futuro lejano determina quién está (encerrado) en el vehículo, pero no lo que habría que hacer más precisamente con el volante. Algunos de nosotros estamos más preocupados por evitar la tormenta, mientras que otros están más motivados por la esperanza existencial de alcanzar el día de verano. No podemos visualizar la complicada red de carreteras que hay más adelante, pero nos resulta fácil ver quién más va en el coche, y podemos hablar con ellos. Así que quizá lo más eficaz que podamos hacer ahora sea comparar nuestros mapas del territorio, y ponernos de acuerdo sobre cómo manejar los desacuerdos que subsistan sin descarrilar el vehículo.

Gracias.

Para más información sobre el riesgo S, visita foundational-research.org. Si tienes alguna pregunta, no dudes en enviarme un correo electrónico a max@foundational-research.org o ponte en contacto conmigo a través de Facebook.