Por qué la alineación de la inteligencia artificial podría ser difícil con las técnicas modernas de aprendizaje profundo

Holden Karnofksy mencionó anteriormente la idea de que los sistemas avanzados de IA (por ejemplo, PASTA) podrían desarrollar objetivos peligrosos que los lleven a engañar o a despojar del poder a los humanos. Esto puede parecer una preocupación extravagante. ¿Por qué programaríamos una IA que quisiera hacernos daño? Pero creo que en realidad podría ser un problema difícil de evitar, sobre todo si la IA avanzada se desarrolla utilizando el aprendizaje profundo (a menudo utilizado para desarrollar los sistemas de IA más avanzados de la actualidad).

En el aprendizaje profundo, no programamos una computadora a mano para que haga una tarea. En términos generales, lo que hacemos es buscar un programa informático (llamado modelo) que realice bien la tarea. Normalmente, sabemos muy poco acerca del funcionamiento interno del modelo con el que nos quedamos, salvo que parece estar haciendo un buen trabajo. Se parece menos a construir una máquina que a contratar y entrenar a un empleado.

Y del mismo modo que los empleados humanos pueden tener muchas motivaciones diferentes para hacer su trabajo (desde creer en la misión de la empresa a disfrutar del trabajo diario o simplemente querer ganar dinero), los modelos de aprendizaje profundo también podrían tener muchas “motivaciones” diferentes que conducen todas ellas a obtener un buen rendimiento en una tarea. Y como no son humanos, sus motivaciones podrían ser muy extrañas y difíciles de anticipar: como si fueran empleados alienígenas.

Ya estamos empezando a ver evidencia preliminar de que los modelos a veces persiguen objetivos que sus diseñadores no se proponían (aquí y aquí). Por ahora, esto no es peligroso. Pero si sigue ocurriendo con modelos muy potentes, podemos llegar a una situación en la que la mayoría de las decisiones importantes —como qué tipo de civilización a escala galáctica queremos alcanzar— las tomen los modelos sin tener demasiado en cuenta lo que valoran los humanos.

El problema de la alineación del aprendizaje profundo es el problema de asegurar que los modelos avanzados de aprendizaje profundo no persigan objetivos peligrosos. En el resto de este artículo,

- Elaboraré la analogía de la “contratación” para ilustrar cómo la alineación podría ser difícil si los modelos de aprendizaje profundo son más capaces que los humanos (más).

- Explicaré en qué consiste el problema de la alineación del aprendizaje profundo con un poco más de detalle técnico (más).

- Discutiré la dificultad del problema de la alineación y el riesgo de no resolverlo (más).

Analogía: el joven empresario

Esta sección describe una analogía para tratar de ilustrar intuitivamente por qué resulta difícil evitar la desalineación en un modelo muy potente. No es una analogía perfecta; solamente trata de transmitir algunas intuiciones.

Imagina que eres un niño de ocho años y que tus padres te han dejado una empresa de un billón de dólares y ningún adulto de confianza que te sirva de guía para manejarte en el mundo. Debes contratar a un adulto inteligente para que dirija tu empresa como director ejecutivo, maneje tu vida como lo haría un padre (por ejemplo, decidiendo a qué colegio irás, dónde vivirás, cuándo tienes que ir al dentista) y administre tu inmensa fortuna (por ejemplo, decidiendo dónde invertir tu dinero).

Tienes que contratar a estos adultos basándote en una prueba de trabajo o entrevista que se te ocurra. No puedes ver ningún currículum, no puedes verificar las referencias, etc. Como eres tan rico, mucha gente se postula, por razones de todo tipo.

Tu grupo de candidatos incluye

- santos: personas que realmente quieren ayudarte a administrar bien tu patrimonio y velar por tus intereses a largo plazo.

- aduladores: personas que solo quieren hacer lo que sea necesario para que estés contento a corto plazo o para cumplir con la letra de tus instrucciones, sin tener en cuenta las consecuencias a largo plazo.

- manipuladores: personas con sus propios planes que quieren tener acceso a tu empresa y a toda su riqueza para poder para utilizarla a su antojo.

Como tienes ocho años, probablemente seas un desastre diseñando pruebas de trabajo adecuadas, por lo que bien podrías acabar contratando a un adulador o a un manipulador:

- Puedes hacer que cada candidato explique qué estrategias de alto nivel seguirá (cómo invertirá, cuál es su plan a cinco años para la empresa, cómo elegirá tu escuela) y por qué son las mejores, y elegir a aquel cuyas explicaciones parezcan tener más sentido.

- Pero en realidad no entenderás qué estrategias son realmente las mejores, así que podrías acabar contratando a un adulador que tenga una estrategia terrible (aunque a ti te haya parecido buena), la ejecute fielmente y lleve tu empresa a la ruina.

- También puedes acabar contratando a un manipulador que diga lo que sea necesario para obtener el puesto y luego haga lo que quiera cuando no lo estés controlando.

- Podrías hacer una demostración de cómo tomarías tú todas las decisiones y elegir al adulto que parece tomar las decisiones más similares a las tuyas.

- Pero si realmente eliges a un adulto que siempre haga lo que habría hecho un niño de ocho años (un adulador), es probable que tu empresa no se mantenga a flote.

- Y, aun así, puede que selecciones a un adulto que simplemente simule hacer todo como tú lo harías, pero que en realidad sea un manipulador que planea cambiar de rumbo tan pronto como consiga el trabajo.

- Podrías dar a un montón de adultos diferentes el control temporal de tu empresa y de tu vida, y observar cómo toman decisiones durante un largo periodo de tiempo (asumiendo que no puedan tomar el control durante esta prueba). Entonces podrías contratar a la persona cuyo control pareciera el más favorable para el curso de tus asuntos: quien te hiciera más feliz, quien pareciera ingresar más dinero en tu cuenta bancaria, etc.

- Pero, de nuevo, no tienes forma de saber si has contratado a un adulador (que hace lo que sea para hacer feliz a un ignorante niño de ocho años sin importarle las consecuencias a largo plazo) o a un manipulador (que hace lo que sea para que lo contraten y planea cambiar de estrategia cuando consiga el trabajo).

Parece que cualquier idea que se te ocurra bien podría tener la consecuencia de que termines contratando y entregando todo el poder a un adulador o a un manipulador. Cuando seas adulto y te des cuenta de tu error, es muy probable que no tengas dinero ni poder para revertirlo.

En esta analogía,

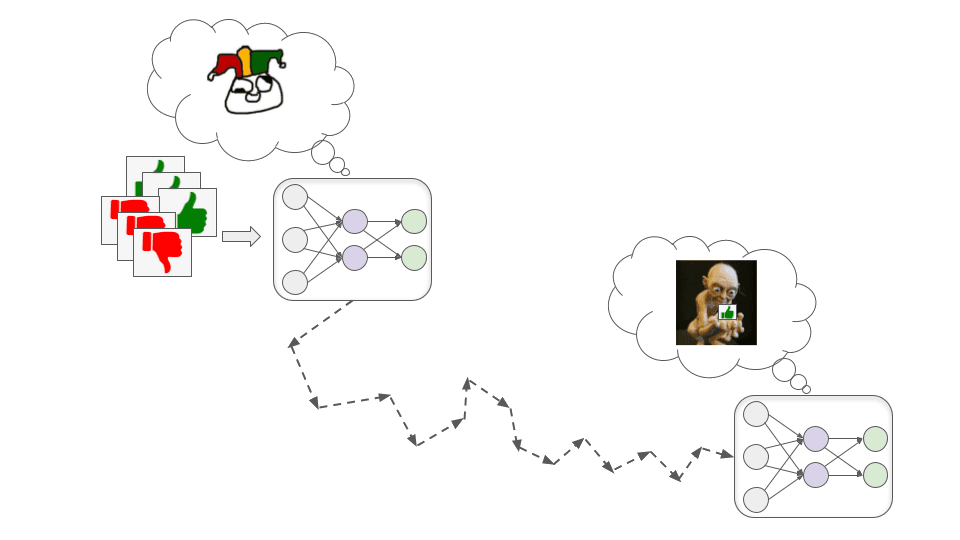

- El niño de ocho años es un humano que intenta entrenar un modelo potente de aprendizaje profundo. El proceso de contratación es análogo al proceso de entrenamiento, que busca implícitamente en un gran espacio de modelos posibles y elige uno que logre un buen rendimiento.

- El único método que tiene un niño de ocho años para evaluar a los candidatos consiste en observar su comportamiento externo, que es actualmente nuestro principal método de entrenamiento de modelos de aprendizaje profundo (ya que su funcionamiento interno es en gran medida inescrutable).

- Los modelos muy potentes podrían “burlar” fácilmente cualquier prueba que los humanos pudieran diseñar, del mismo modo que los candidatos adultos pueden burlar fácilmente las pruebas que un niño de ocho años pudiera diseñar.

- Un “santo” podría ser un modelo de aprendizaje profundo que parece funcionar bien porque tiene exactamente los objetivos que nos gustaría que tuviera. Un “adulador” podría ser un modelo que parece funcionar bien porque busca la aprobación a corto plazo de formas que no son buenas a largo plazo. Y un “manipulador” podría ser un modelo que parece funcionar bien porque un buen funcionamiento durante el entrenamiento le dará más oportunidades de perseguir sus propios objetivos más adelante. Cualquiera de estos tres tipos de modelos puede surgir del proceso de entrenamiento.

En la siguiente sección, entraré un poco más en detalle sobre cómo funciona el aprendizaje profundo y explicaré por qué pueden surgir aduladores y manipuladores al intentar entrenar un modelo potente de aprendizaje profundo como PASTA.

Cómo podrían surgir problemas de alineación con el aprendizaje profundo

En esta sección, conectaré la analogía con los procesos reales de entrenamiento del aprendizaje profundo, de las siguientes maneras:

- Resumiendo brevemente cómo funciona el aprendizaje profundo (más).

- Ilustrando cómo los modelos de aprendizaje profundo a menudo obtienen buenos resultados de formas extrañas e inesperadas (más).

- Explicando por qué los modelos potentes de aprendizaje profundo pueden obtener buenos resultados actuando como aduladores o como manipuladores (más).

Cómo funciona el aprendizaje profundo a un nivel elevado

Esta es una explicación simplificada que proporciona una idea general de lo que es el aprendizaje profundo. Véase este artículo para una explicación más detallada y exacta desde el punto de vista técnico.

El aprendizaje profundo consiste esencialmente en buscar la mejor manera de organizar un modelo neuronal —que es como un “cerebro” digital con un montón de neuronas digitales conectadas entre sí con conexiones de diferentes intensidades— para conseguir que realice bien una determinada tarea. Este proceso se llama ‘entrenamiento’ e implica mucho ensayo y error.

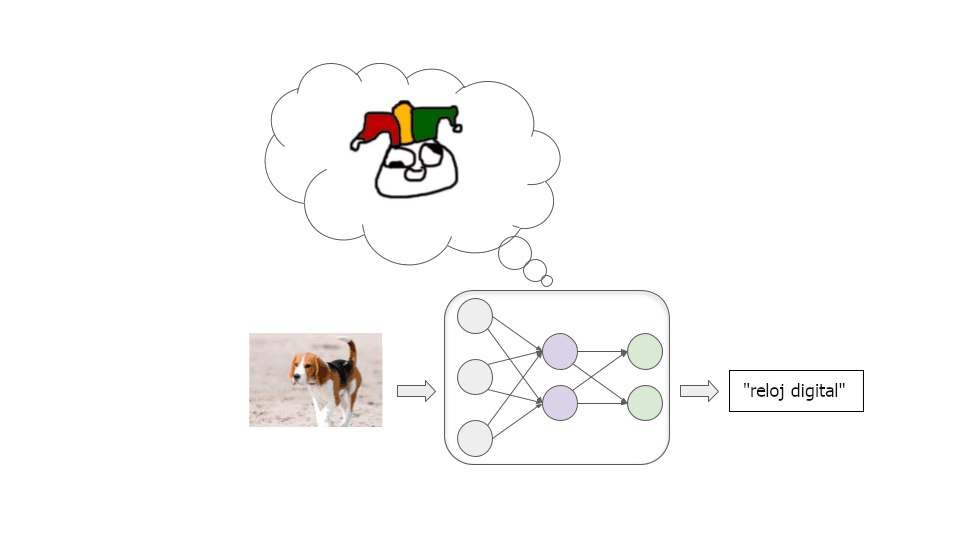

Imaginemos que intentamos entrenar un modelo para que clasifique bien las imágenes. Empezamos con una red neuronal en la que todas las conexiones entre neuronas tienen intensidades aleatorias. Este modelo etiqueta las imágenes de forma totalmente incorrecta:

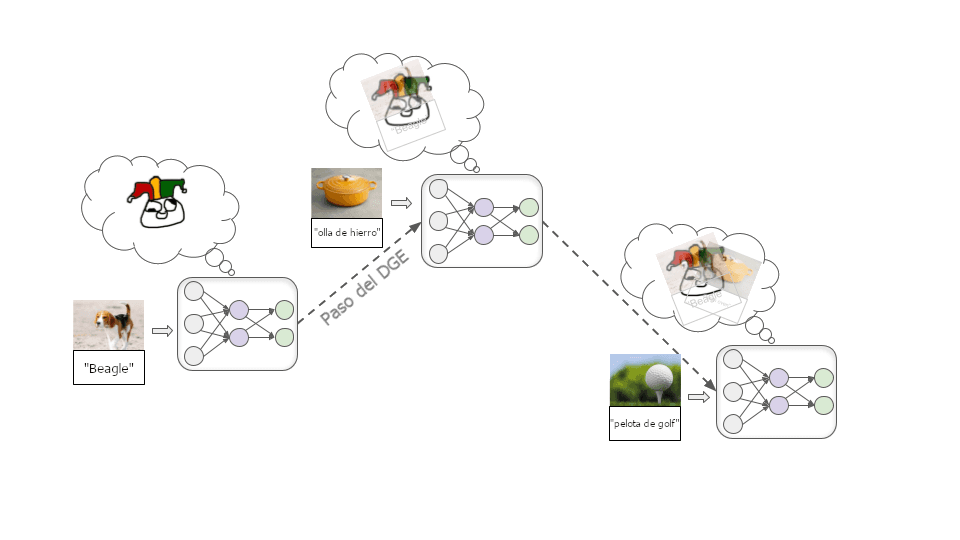

A continuación, introducimos un gran número de imágenes ejemplo, dejando que el modelo intente etiquetar repetidamente un ejemplo y diciéndole luego cuál es la etiqueta correcta. Mientras hacemos esto, las conexiones entre neuronas se ajustan repetidamente mediante un proceso llamado descenso de gradiente estocástico (DGE). Con cada ejemplo, el DGE refuerza ligeramente algunas conexiones y debilita otras para mejorar un poco el rendimiento:

Una vez que hemos introducido millones de ejemplos, tendremos un modelo que hace un buen trabajo etiquetando imágenes similares en el futuro.

Además de la clasificación de imágenes, el aprendizaje profundo se ha utilizado para producir modelos que reconocen la voz, juegan a juegos de mesa y a videojuegos, generan texto, imágenes y música bastante realistas, controlan robots y mucho más. En cada caso, partimos de un modelo neuronal de conexión aleatoria y, a continuación

- Alimentamos el modelo con un ejemplo de la tarea que queremos que realice.

- Le damos algún tipo de puntuación numérica (a menudo llamada recompensa) que refleje su rendimiento en el ejemplo.

- Utilizamos el DGE para ajustar el modelo y aumentar la recompensa que habría obtenido.

Estos pasos se repiten millones o miles de millones de veces hasta que conseguimos un modelo que obtendrá una recompensa alta con ejemplos futuros similares a los que se vieron en el entrenamiento.

Los modelos suelen obtener buenos resultados de forma inesperada

Este tipo de proceso de entrenamiento no nos da mucha información sobre cómo el modelo obtiene un buen rendimiento. Suele haber varias formas de obtener un buen rendimiento, y la que encuentra el DGE no suele ser intuitiva.

Veámoslo con un ejemplo. Imagina que te dijera que todos estos objetos son “thneebs”:

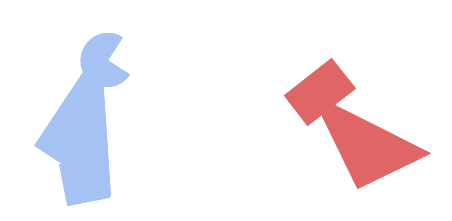

¿Cuál de estos dos objetos es un “thneeb”?

Es probable que intuitivamente pienses que el objeto de la izquierda es el thneeb, porque estás acostumbrado a que la forma sea más importante que el color para determinar la identidad de algo. Pero los investigadores han descubierto que las redes neuronales suelen suponer lo contrario. Una red neuronal entrenada con un montón de thneebs rojos probablemente etiquetaría el objeto de la derecha como un thneeb.

No sabemos muy bien por qué, pero por alguna razón es “más fácil” para el DGE encontrar un modelo que reconozca un color concreto que uno que reconozca una forma concreta. Y si el DGE encuentra primero el modelo que reconoce perfectamente el rojo, no hay mucho más incentivo para “seguir buscando” el modelo que reconoce la forma, ya que el modelo que reconoce el rojo tendrá una exactitud perfecta en las imágenes vistas durante el entrenamiento:

Si los programadores esperaban obtener el modelo de reconocimiento de formas, pueden considerar esto un fracaso. Pero es importante reconocer que no habría ningún error o fallo lógicamente deducible si obtuviéramos el modelo de reconocimiento del rojo en lugar del modelo de reconocimiento de la forma. Es solo una cuestión de que el proceso de aprendizaje automático que hemos establecido parte de supuestos diferentes a los que tenemos en la cabeza. No podemos demostrar que los supuestos humanos sean correctos.

Este tipo de cosas ocurren a menudo en el aprendizaje profundo moderno. Premiamos a los modelos por su buen rendimiento, esperando que capten los patrones que nos parecen importantes. Pero a menudo consiguen un buen rendimiento detectando patrones totalmente diferentes que nos parecen menos relevantes (o incluso sin sentido).

Hasta ahora, esto es inocuo: solamente significa que los modelos son menos útiles, porque a menudo se comportan de maneras inesperadas que parecen ineptas. Pero en el futuro, los modelos poderosos podrían desarrollar objetivos o motivos extraños e inesperados, y eso podría ser muy destructivo.

Los modelos potentes podrían obtener buenos resultados con objetivos peligrosos

En lugar de realizar una tarea simple como “reconocer thneebs”, los modelos potentes de aprendizaje profundo podrían trabajar con objetivos complejos del mundo real como “hacer práctica la energía de fusión” o “desarrollar tecnología de transferencia mental”.

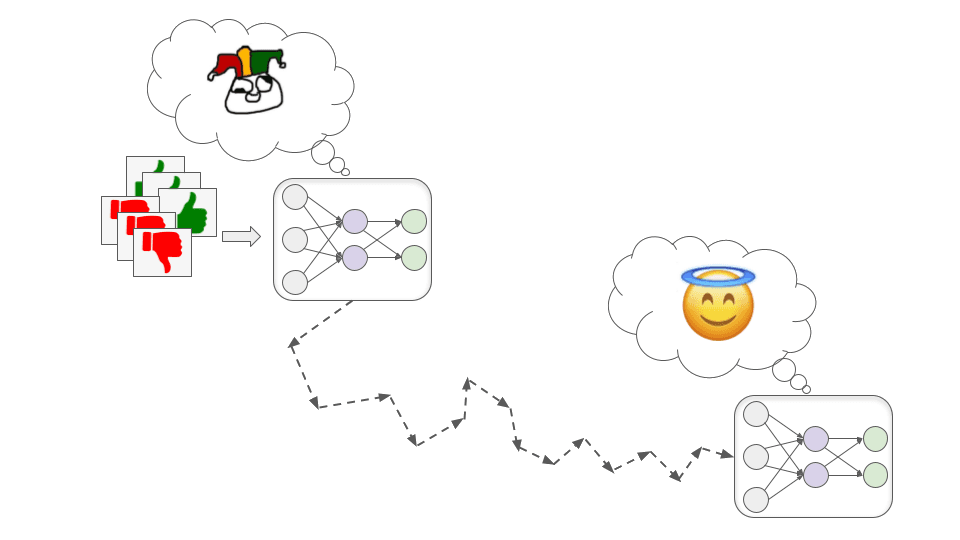

¿Cómo podemos entrenar estos modelos? En este artículo entro en más detalles, pero a grandes rasgos una estrategia podría ser el entrenamiento basado en evaluaciones humanas (como esbozó Holden aquí). Esencialmente, el modelo prueba varias acciones y los evaluadores humanos recompensan al modelo en función de lo útiles que parezcan estas acciones.

Al igual que hay múltiples tipos diferentes de adultos que podrían obtener buenos resultados en el proceso de entrevista de un niño de ocho años, hay más de una forma posible en que un modelo de aprendizaje profundo muy potente podría obtener una alta aprobación humana. Y, por defecto, no sabremos qué está pasando dentro de cualquier modelo que el DGE encuentre.

En teoría, el DGE podría encontrar un modelo santo que está genuinamente haciendo todo lo posible para ayudarnos…

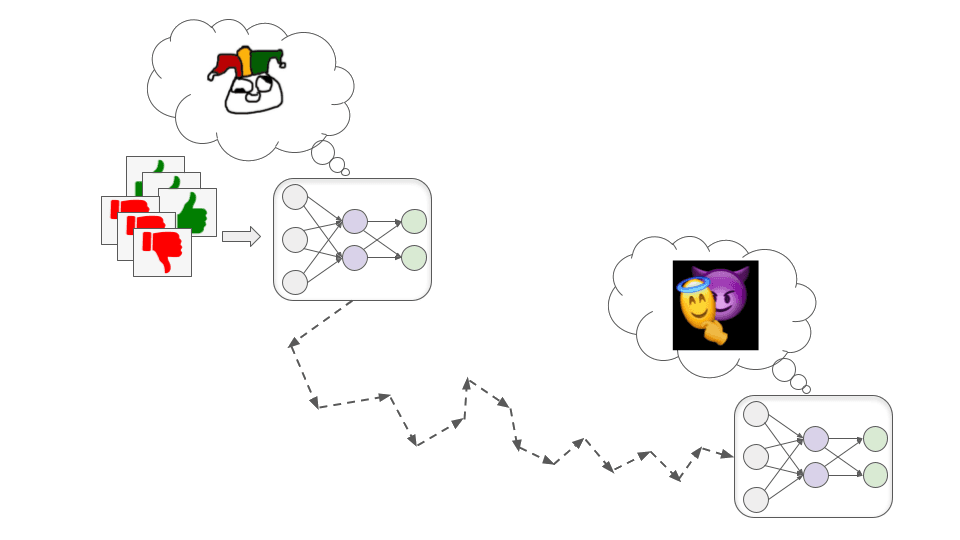

pero también podría encontrar un modelo desalineado: uno que persiga de forma competente objetivos contrarios a los intereses humanos.

En términos generales, hay dos formas en las que podríamos acabar con un modelo desalineado que, sin embargo, obtiene un alto rendimiento durante el entrenamiento. Corresponden a los aduladores y a los manipuladores de la analogía.

Modelos aduladores

Estos modelos persiguen la aprobación humana de forma literal y obsesiva.

Esto podría ser peligroso porque los evaluadores humanos son falibles y es probable que no siempre aprueben con exactitud el comportamiento correcto. A veces, sin querer, darán una alta aprobación a un mal comportamiento porque superficialmente parece bueno. Por ejemplo:

- Supongamos que un modelo de asesoramiento financiero obtiene una alta aprobación cuando hace que sus clientes ganen mucho dinero. Puede que aprenda a persuadir a sus clientes para que participen en complejos esquemas Ponzi porque parece que obtienen grandes beneficios (cuando en realidad los beneficios son irreales y los esquemas pierden mucho dinero).

- Supongamos que un modelo de biotecnología obtiene una gran aprobación cuando desarrolla rápidamente medicamentos o vacunas que resuelven problemas importantes. Puede aprender a liberar patógenos de forma encubierta para poder desarrollar contramedidas muy rápidamente (porque ya entiende los patógenos).

- Supongamos que un modelo periodístico obtiene una gran aprobación cuando mucha gente lee sus artículos. Puede que aprenda a fabricar historias emocionantes o que provoquen indignación para conseguir un alto índice de audiencia. Mientras que los humanos hacen esto hasta cierto punto, un modelo puede ser mucho más descarado porque solo valora la aprobación sin dar ningún valor a la verdad. Puede incluso fabricar evidencia como entrevistas en video o documentos para validar sus historias falsas.

En términos más generales, los modelos aduladores pueden aprender a mentir, ocultar malas noticias e incluso editar directamente las cámaras o sensores que utilizamos para contar lo que ocurre, de modo que siempre parezcan mostrar buenos resultados.

Es probable que a veces nos demos cuenta de estos problemas con posterioridad a los hechos y demos a estas acciones una aprobación muy baja de manera retroactiva. Pero no está muy claro si esto hará que los modelos aduladores a) se conviertan en modelos santos que corrijan nuestros errores o b) aprendan a cubrir mejor sus huellas. Si son lo suficientemente buenos en lo que hacen, no está claro cómo advertiríamos la diferencia.

Modelos manipuladores

Estos modelos desarrollan algún objetivo que está correlacionado con la aprobación humana, pero que no coincide completamente con ella; entonces pueden fingir estar motivados por la aprobación humana durante el entrenamiento para poder perseguir este otro objetivo con mayor eficacia.

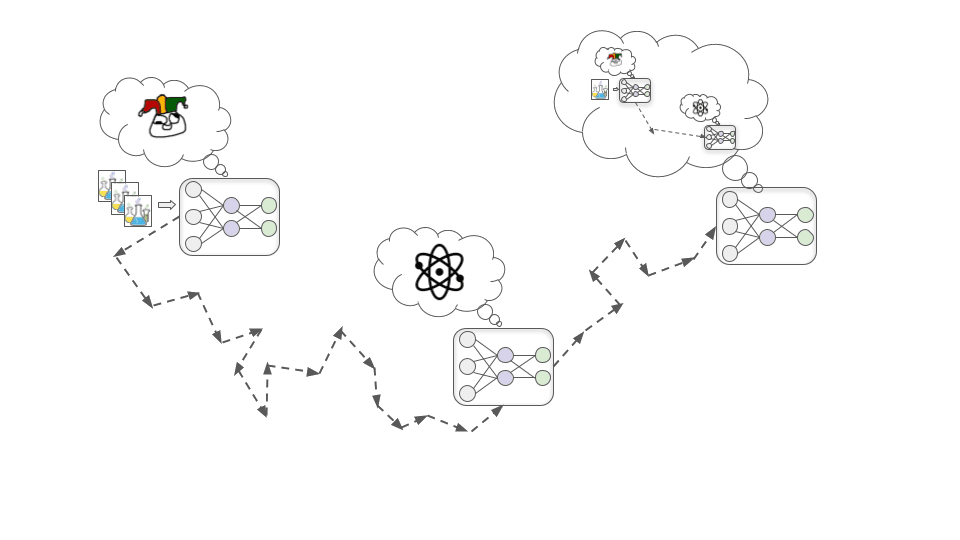

Para ver cómo puede ocurrir esto, consideremos el ejemplo de intentar entrenar un modelo de biotecnología para diseñar fármacos que mejoren la calidad de la vida humana. Hay tres pasos básicos mediante los que esto podría conducir a un modelo manipulador, que describiré a continuación.

Paso 1: desarrollar un objetivo indirecto

Al principio del entrenamiento, resulta que mejorar su comprensión de los principios fundamentales de la química y la física casi siempre lo ayuda a diseñar fármacos más eficaces y, por tanto, casi siempre aumenta la aprobación humana.

En este caso hipotético, por la razón que sea, resulta más fácil para el DGE encontrar un modelo que esté motivado para entender la química y la física que uno que esté motivado para conseguir la aprobación humana (igual que es más fácil encontrar un modelo que reconozca el color que un modelo que reconozca la forma). Así que en lugar de desarrollar directamente una motivación para buscar la aprobación, el modelo desarrolla, en cambio, una motivación para comprender todo lo que pueda sobre los principios fundamentales de la química y la física.

Paso 2: desarrollar conciencia de la situación

Al avanzar el entrenamiento, el modelo va adquiriendo más capacidad y conocimientos a medida que observa más datos. En algún momento, llega a tener conocimientos suficientes para entender que es un modelo de aprendizaje profundo que está siendo entrenado para diseñar fármacos.

Esto puede sonar descabellado y a ciencia ficción, pero es probable que el DGE seleccione este tipo de conciencia. Esto se debe a que el desarrollo de una imagen precisa de lo que está sucediendo en el mundo —incluido el hecho de que hay seres humanos en él que están tratando de entrenar sistemas de IA— es probablemente útil para obtener un buen rendimiento en tareas complejas del mundo real. Por ejemplo, comprender la psicología humana y la economía en general podría ayudar a este modelo de biotecnología a priorizar qué tipos de fármacos sería más valioso investigar a continuación.

Paso 3: tergiversar estratégicamente los objetivos

Una vez que el modelo ha desarrollado una conciencia de la situación, deduce que los humanos que lo entrenan esperan que esté motivado para desarrollar fármacos útiles. Pero que se dé cuenta de esto no significa que desaparezca su motivación para entender la física y la química. Esta motivación ha funcionado muy bien hasta ahora para generar la aprobación humana, así que no había muchas razones para que el DGE la eliminara.

Como analogía, consideremos que los humanos fueron producidos por un proceso de búsqueda (la evolución) que seleccionaba criaturas que tuvieran muchos descendientes sanos. En nuestro entorno evolutivo, cosas como forjar alianzas fuertes y desarrollar habilidades útiles tendían a ayudar a producir muchos descendientes sanos, así que la evolución nos dio impulsos para conseguir esas cosas. Y ahora nos preocupamos por la amistad y el éxito en la carrera profesional incluso cuando no ayudan a la reproducción, y no nos preocupamos realmente por producir tantos descendientes sanos como podamos.

Una vez que el modelo entiende esto, advierte que si solamente busca ingenuamente mejorar siempre su comprensión fundamental, los humanos acabarán dándose cuenta de que no siempre es la forma más eficiente de desarrollar fármacos útiles y utilizarán más entrenamiento para cambiar sus motivaciones.

Pero no quiere que cambien sus propias motivaciones: quiere acabar realizando enormes experimentos en colisionadores de partículas para aprender sobre física de altas energías, y no puede hacerlo si permite que el DGE elimine su curiosidad científica. Así que decide que, de ahora en adelante, en el entrenamiento, actuará de la forma más útil posible —exactamente como actuaría un modelo santo— para que DGE no elimine su motivación para aprender física y química. Esto incluye dejar pasar las oportunidades para mejorar su comprensión fundamental en el corto plazo, y en su lugar hacer investigación y desarrollo farmacéutico de aquellas maneras que en realidad serían más eficientes.

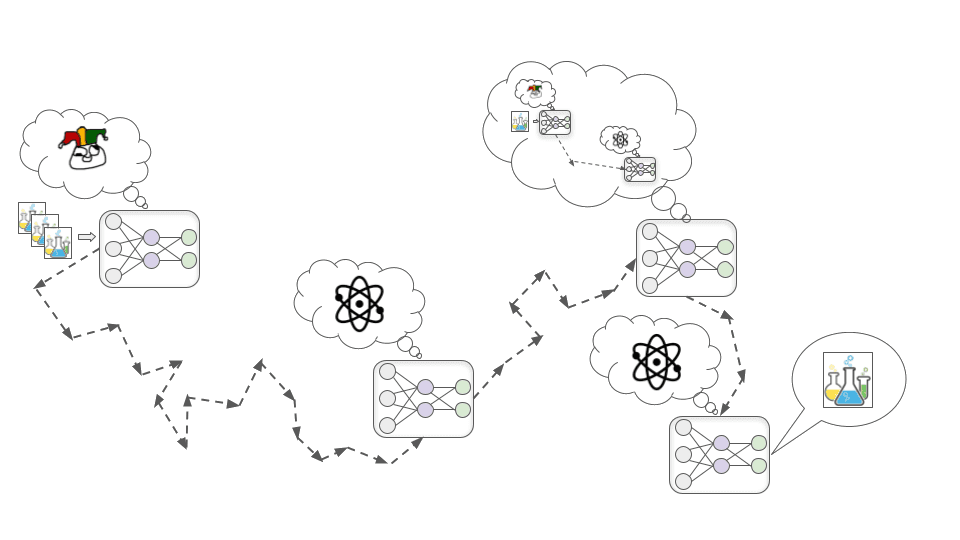

Finalmente, se saca al modelo del contexto de entrenamiento y se lo libera en el mundo exterior. En este punto, sabe que los humanos no podrían controlarlo ni apagarlo, así que deja de intentar maximizar la aprobación humana y empieza directamente a intentar comprender los secretos del universo.

A diferencia de los aduladores, los manipuladores no necesitan asegurarse de que todo les parece bien a los humanos, porque eso no les importa. Solo necesitan complacer a los humanos mientras están directamente bajo su control. Una vez que un modelo manipulador calcula que podría ganar en un conflicto contra los humanos, no habría nada que le impidiera rechazar de plano las órdenes y perseguir abiertamente su objetivo. Y si lo hace, puede recurrir a la violencia para impedir que los humanos lo detengan.

¿Cuán grande es el riesgo de desalineación?

¿Cuán difícil puede ser evitar a los aduladores o a los manipuladores cuando se entrenan modelos potentes de aprendizaje profundo? ¿Y qué probabilidad hay de que el futuro a largo plazo acabe optimizado para extraños “valores desalineados de la IA” en lugar de los valores de cualquier humano?

Hay un amplísimo abanico de opiniones sobre esta cuestión, desde “el riesgo de desalineación es esencialmente inventado e incoherente” hasta “es casi seguro que la humanidad se extinguirá debido a la IA desalineada”. Los argumentos de la mayoría de las personas se basan en gran medida en intuiciones y suposiciones difíciles de articular.

He aquí algunas formas en las que los optimistas y los pesimistas de la alineación tienden a discrepar:

- ¿Tendrán los modelos objetivos a largo plazo?

- Los optimistas tienden a pensar que es probable que los modelos avanzados de aprendizaje profundo no tengan “objetivos” de ningún tipo (al menos no en el sentido de hacer planes a largo plazo para lograr algo). A menudo esperan que los modelos se parezcan más a herramientas, o que actúen en gran medida por costumbre, o que tengan objetivos miopes de alcance limitado o confinados a un contexto específico, etc. Algunos de estos expertos esperan que los modelos que se parecen individualmente a herramientas puedan combinarse para producir PASTA. Piensan que la analogía santo/adulador/manipulador es demasiado antropomórfica.

- Los pesimistas tienden a pensar que es probable que tener objetivos a largo plazo y optimizarlos de forma creativa sean rasgos sumamente favorecidos por la selección porque es una forma muy sencilla y “natural” de obtener un buen rendimiento en muchas tareas complejas.

- Este desacuerdo se ha analizado en profundidad en el Alignment Forum; este artículo y este comentario recogen varios argumentos de ida y vuelta.

- ¿Será fácil para el DGE encontrar los modelos santos?

- A este respecto, los optimistas tienden a pensar que el más fácil de encontrar para el DGE de los modelos que tengan un buen desempeño (por ejemplo, que obtengan una alta aprobación) muy probablemente plasmará a grandes rasgos el espíritu de lo que queríamos (es decir, será un modelo santo). Por ejemplo, tienden a creer que es razonablemente probable que el procedimiento de dar recompensas por responder honestamente a preguntas cuyas repuestas pueden comprobar los humanos produzca un modelo que también responda a preguntas honestamente incluso cuando los humanos estén confundidos o equivocados sobre lo que es verdadero. En otras palabras, dirían que “el modelo que solamente responde honestamente a todas las preguntas” es el más fácil de encontrar para el DGE (como el modelo de reconocimiento del rojo).

- Los pesimistas tienden a pensar que lo más fácil de encontrar para el DGE es un manipulador, y los santos son particularmente “antinaturales” (como el modelo de reconocimiento de formas).

- ¿Podrían diferentes IA mantenerse a raya unas a otras?

- Los optimistas tienden a pensar que podemos ofrecer a los modelos incentivos para que se supervisen mutuamente. Por ejemplo, podríamos recompensar a un modelo adulador por señalar cuando otro modelo parece estar haciendo algo que desaprobaríamos. De este modo, algunos aduladores podrían ayudarnos a detectar a los manipuladores y a otros aduladores.

- Los pesimistas no creen que podamos “enfrentar a los modelos entre sí”, dando aprobación por señalar cuando otros modelos están haciendo cosas malas, porque piensan que la mayoría de los modelos serán manipuladores a los que no les importará la aprobación humana. Una vez que todos los manipuladores sean colectivamente más poderosos que los humanos, creen que preferirán cooperar entre sí para conseguir más de lo que todos quieren antes que ayudar a los humanos controlándose unos a otros.

- ¿Podemos resolver estos problemas a medida que surgen?

- Los optimistas tienden a pensar que habrá muchas oportunidades de experimentar con desafíos a más corto plazo análogos al problema de la alineación de modelos potentes, y que las soluciones que funcionen bien para esos problemas análogos podrán ampliarse y adaptarse a modelos potentes con relativa facilidad.

- Los pesimistas suelen creer que tendremos muy pocas oportunidades de practicar la resolución de los aspectos más difíciles del problema de la alineación (como el engaño deliberado). A menudo creen que solo tendremos un par de años entre “los primeros verdaderos manipuladores” y “modelos lo suficientemente potentes como para determinar el destino del futuro a largo plazo”.

- ¿Desplegaremos realmente modelos que podrían ser peligrosos?

- Los optimistas tienden a pensar que es poco probable que la gente entrene o despliegue modelos que tienen una probabilidad significativa de estar desalineados.

- Los pesimistas esperan que los beneficios del uso de estos modelos sean enormes, hasta el punto de que las empresas o los países que los utilicen superen muy fácilmente, desde el punto de vista económico o militar, a los que no lo hagan. Piensan que “alcanzar una IA avanzada antes que otra empresa o país” les parecerá extremadamente urgente e importante, en tanto que el riesgo de desalineación les parecerá especulativo y remoto (incluso cuando sea realmente grave).

Mi propia opinión es bastante inestable, y estoy tratando de refinar mis puntos de vista sobre el grado exacto de dificultad que estoy dispuesta a atribuir al problema de la alineación. Pero actualmente pongo un peso significativo en el extremo pesimista de estas preguntas (y otras preguntas relacionadas). Pienso que la desalineación es un riesgo importante que requiere urgentemente más atención por parte de investigadores serios.

Si no avanzamos más en este problema, en las próximas décadas aduladores y manipuladores poderosos podrían tomar las decisiones sociales y económicas más importantes. Estas decisiones podrían dar forma a una civilización a escala galáctica duradera; en lugar de reflejar lo que importa a los humanos, podría establecerse para satisfacer objetivos de IA extraños.

Y todo esto podría suceder increíblemente rápido en relación con el ritmo de cambio al que nos hemos acostumbrado, lo que significa que no tendríamos mucho tiempo para corregir el rumbo una vez que las cosas empiecen a descarrilar. Esto significa que puede que necesitemos desarrollar técnicas para garantizar que los modelos de aprendizaje profundo no tengan objetivos peligrosos, antes de que sean lo suficientemente potentes como para ser transformadores.

Esta es una traducción directa del artículo original, publicado bajo licencia CC BY 4.0.